Les compressions du signal numérique

- 25 réponses

- 9 participants

- 2 813 vues

- 9 followers

Etienne1992

Hello tout le monde,

Je vais m'attaquer sous peu à la rédaction d'un dossier le plus complêt possible sur les différentes compressions du signal numérique.

Le point de départ est que tous les domaines du son (radio, ciné, télé, musique, diffusion internet) font appel à divers procédés de réduction du débit numérique. Or, peu de techniciens n'ont ne serait-ce qu'une vague idée du fonctionnement de ces procédés ni de leur influence réelle sur leur travail une fois arrivé chez l'auditeur. Je cherche à savoir si il est possible de tenir compte d'une compression future lors du mastering.

Je suis à la recherche de plusieurs choses :

1) des études déjà menées sur les compressions destructives

2) des livres / liens expliquant précisément les procédés utilisés et les principes des différents formats.

3) de techniques utilisées par les ingénieurs du son pour tenir compte de la compression future de leur travail et minimiser son impact destructif.

Dans l'idéal, j'aimerai faire un comparatif des différents formats de compression (mp3, aac etc.) et éventuellement trouver des techniques applicables au mastering pour optimiser le signal en vue d'une compression future.

Je suis vraiment au début de ma recherche et toute contribution m'intéresse

A+

Mes réalisations : http://www.rallu-sound.ch

[ Dernière édition du message le 01/11/2012 à 00:06:10 ]

- 1

- 2

numa

https://www.apple.com/itunes/mastered-for-itunes/

et

http://www.sonnoxplugins.com/pub/plugins/products/pro-codec.htm

Anonyme

Tu pourrais également parler, pour être exhaustif, de la compression de données non destructive, comme le format Flac par exemple.

Etienne1992

Pour les compressions sans perte, je prévois effectivement d'en parler mais il faut quand même savoir qu'elles sont quasiment inexistantes dans les formats de diffusion courant. Les différents Dolby pour le cinéma utilisent une compression destructive, les magasins de musiques utilisent du mp3 ou de l'arc, les radios (numériques) utilisent du destructif aussi et demandent souvent du MP3 en PàD (sauf erreur) et je ne sais pas si il existe des sites de streaming qui encodent dans un format non destructif. Bref, à moins de le vouloir vraiment, il est rare de tomber par hasard sur du contenu compressé sans perte.

C'est à creuser d'ailleurs. As-tu des exemples de sites internet qui fournissent du contenu compressé sans perte ?

Mes réalisations : http://www.rallu-sound.ch

EraTom

Quel est ton niveau en math / traitement du signal / théorie de l'information ? As-tu des connaissances en matière de psycho-acoustique ?

Si je te parle de la mesure d'entropie de Shannon, par exemple, est-ce que ça te dit quelque chose ?

Si je te parle de largeur de bande critique ?

Si oui, alors je pense pouvoir te trouver des liens vers des thèses (en gros, bac+5 à bac+8) en traitement du signal qui porte sur la compression destructive du signal audio. Il y a toujours un état de l'art qui fait un inventaire assez exhaustif des techniques actuelles.

Sinon, je peux te donner des pistes et des mots clefs, t'expliquer certains grands principes généraux qui pourront sans doute t'aider à orienter tes recherches.

Lv mastering

de techniques utilisées par les ingénieurs du son pour tenir compte de la compression future de leur travail et minimiser son impact destructif.

La plupart des formats de compression travaillent par bandes de fréquences et il est donc important de bien délimiter les plages de fréquences dès l'étape du mixage. Chaque instrument doit être bien défini dans sa plage fréquentielles. Cependant, le mixage signifie "mélange" et un certain recoupement doit quand même exister.

En partant d'un mixage "propre", on peut ensuite encore augmenter l'intelligibilité du signal lors du mastering en nettoyant certaines fréquences et, au contraire, en augmentant si nécessaire la présence de certains éléments (voix notamment, plage médium/haut-médium)

Cette démarche est valable non seulement pour augmenter la "qualité" du mix après encodage mais aussi, plus généralement, pour faire face à toutes les situations de diffusion où les plages fréquentielles feront l'objet de compromis technologiques lors de leur restitution (c'est à dire quasiment toutes les situation autres que le monitoring de studio ou la hifi haut de gamme)

En d'autres termes, un mixage/mastering de bonne qualité aura toutes ses chances de passer l'étape de l'encodage (quel qu'il soit) sans trop de problèmes.

Le logiciel Sonnox ou toute autre technique d'anticipation de l'encodage trouveront leur intérêt pour contourner certaines spécificités des algorithmes d'encodage

(auto-compensation sur le haut-médium, sur les aigus)

Un autre point à considérer est le niveau RMS du fichier avant encodage. En effet, les algorithmes fonctionnant selon le principe du "masquage" des niveaux faibles

par les niveaux forts, il est important d'envisager des compromis en terme de plage dynamique lorsqu'on projette une diffusion "compressée" (débit).

Certains codecs de compression s'adaptant mieux aux niveau faibles, il peut être judicieux pour les musiciens "classique" ou "ambient" de choisir leurs plateformes de

diffusion en fonction de ce paramètre. On constate notamment que de nombreux musiciens "ambient" sont présents sur la plateforme Bandcamp.

LV

Studio de Mastering en ligne http://www.lvmastering.com/

[ Dernière édition du message le 01/11/2012 à 15:17:32 ]

Etienne1992

Quel est ton niveau en math / traitement du signal / théorie de l'information ? As-tu des connaissances en matière de psycho-acoustique ?

Pour mon niveau de math, je dirai quelque chose un peu plus haut que le niveau bac. Pour ce qui est du traitement du signal, j'ai quelques bases théoriques et surtout pas mal d'expérience pratique.

Je pense avoir un niveau moyen en ce qui concerne la psycho-acoustique. En plus des bases théoriques, J'ai finalement quelques heures de studio / sonorisation derrière moi et je commence à savoir ce qu'on peut faire "gober" à l'oreille et ce qui ne fonctionne pas.

Si je te parle de la mesure d'entropie de Shannon, par exemple, est-ce que ça te dit quelque chose ?

Si je te parle de largeur de bande critique ?

comme tu dis, ça me dit quelque chose mais il est vrai que je ne serai pas expliquer précisément à quoi tu fais référence.

Si oui, alors je pense pouvoir te trouver des liens vers des thèses (en gros, bac+5 à bac+8) en traitement du signal qui porte sur la compression destructive du signal audio. Il y a toujours un état de l'art qui fait un inventaire assez exhaustif des techniques actuelles.

Sinon, je peux te donner des pistes et des mots clefs, t'expliquer certains grands principes généraux qui pourront sans doute t'aider à orienter tes recherches.

Dans l'absolu, je pense que j'aurai besoin des deux si tu as le temps. J'aimerai bien qu'on m'explique les grands principes généraux (même si j'en ai déjà une petite idée) mais j'aimerai bien quand même aller plus loin que les beaux principes théoriques... Si effectivement il existe des thèses ou autres documents qui font un inventaire exhaustif des techniques, je pense que cela m'aiderait beaucoup (même si il se peut que j'ai du mal à saisir les démonstrations mathématiques...)

Mes réalisations : http://www.rallu-sound.ch

EraTom

Quantité d'information : (ou codage exact)

Quelque soit le "paquet de bits" considéré (image, son, texte, que sais-je) celui-ci contient une quantité d'information (sinon, on ne s'y intéresserait pas).

Cette quantité d'information n'est pas "directement proportionnelle" à la longueur du paquet de données : si je répète 10 ou 100 fois le même mot ou la même phrase, le message constitué est plus long mais la quantité d'information véhiculée n'augmente pas.

Exemple : si je répète 10 ou 100 fois le même mot ou la même phrase, le message constitué est plus long mais la quantité d'information véhiculée n'augmente pas.

Pour mesurer la quantité d'information d'un message un type a inventé ceci :

https://fr.wikipedia.org/wiki/Entropie_de_Shannon

Si tu ne comprends pas dans les détails ce n'est pas bien grave. Tout ce qu'il faut retenir c'est qu'un message plus long ne contient pas forcément plus d'information si des "motifs" se répètent (des suites de "0" et de "1" dans le cas d'un message binaire).

A l'opposé, une suite de motifs complètement aléatoire constitue un message enfermant le plus d'information possible pour une longueur donnée (par longueur je parle du nombre de 0 ou de 1).

C'est important parce que ça constitue une limite théorique que l'on ne peut pas dépasser : si une suite de bits est complètement aléatoire alors il n'existe pas de message plus court pouvant coder la même quantité d'information.

Compression non-destructive: (ou codage avec perte)

Le "problème" de la compression de données peut être formulé comme ceci :

- J'ai un message d'une certaine longueur (ou d'un certain nombre de motifs).

- Celui-ci contient une certaine quantité d'information.

- Est-ce que je peux trouver un nouveau jeu de motifs qui me permet de transmettre la même quantité d'information avec un message de longueur plus petite ?

Ce "nouveau jeu de motifs" s'appelle un dictionnaire. Tous les algorithmes de compression non-destructive cherchent à construire un dictionnaire qui permet de minimiser la longueur du message transmis (ou stocké).

La réponse à la question est "oui" et la méthode optimale a été trouvée avec le codage de Huffman :

https://fr.wikipedia.org/wiki/Codage_de_Huffman

Pour expliquer l'idée simplement :

- On analyse le message initial pour trouver des motifs récurrents et on les ordonne (de celui qui apparaît le plus souvent à celui qui apparait le moins souvent).

- On construit un dictionnaire : le motif qui apparait le plus souvent est remplacé par un motif court, le motif qui apparait le moins souvent est remplacé par le motif le plus long du dictionnaire.

En procédant de la sorte, statistiquement, le message obtenu sera plus court que le message initial. Ce que l'on peut montrer aussi c'est que le message de sortie obtenu tend à devenir la "suite de motifs aléatoires" dont je te parlais plus haut.

Ce n'est sans doute pas très clair, alors voici un exemple avec les lettres de l'alphabet.

Tu connais peut-être le codage ASCII : tous les cratères sont codés avec une taille fixe de 8bits.

Pour connaitre la longueur (en nombre de bits) d'un message du forum en codage ASCII il suffit de compter les nombres de caractères et de multiplié par 8. Bon...

Et bien des types se sont amusés à compter l’occurrence moyenne de chaque lettre dans chaque langue, notamment le français :

http://pedroiy.free.fr/alphabets/index.php?pg=http://pedroiy.free.fr/alphabets/frequence.htm

Si tu appliquais le codage de Huffman au français tu obtiendrais une codage différent du codage ASCII :

E : 01

S : 001

A : 0001

N : 00001

etc.

Le motif codant le W est très long, mais comme la lettre n'apparait quasiment jamais dans un texte en français on s'en fout.

Le E qui apparait presque 1 fois sur 5 ne prendrait que 2bits à la place de 8bits.

En moyenne, sur un message en français assez long, tu réduits globalement sa longueur par rapport au code ascii.

Normalement, si le codage est efficace (et il l'est), la nouvelle suite de motifs que l'on obtient avec le codage de Huffman est plus courte et ressemble de plus en plus à la suite de bits aléatoires.

Bien sûr, si tu changes de langue ça ne marche plus : en anglais le W est presque partout. Il faut construire un autre dictionnaire.

Ceci dit, le nombre de langues est limité : tu peux construire un dictionnaire pour le français, un dictionnaire pour l'anglais, etc. et quand tu transmets ton message tu ne fais que préciser à celui qui le reçoit quel est le dictionnaire à utiliser.

Un programme de compression comme le ZIP n'a pas cette chance : il est obligé de construire un dictionnaire pour chaque nouveau fichier qu'on lui a demandé de compresser, et pour décompresser l'archive il faut qu'il fournisse le dictionnaire (dis autrement, dans l'archive ZIP il y a le message ET le dictionnaire).

Or, dans certain cas, le dictionnaire peut-être plus gros ou aussi gros que le message codé... ça arrive notamment avec la suite de bits aléatoires.

Ceci permet de comprendre (je l'espère) qu'il existe une limite théorique qui ne peut pas être dépassée : quand le message est "complètement aléatoire" il ne devient plus possible de réduire sa taille parce que l'on est obligé de coder chaque motif un à un et qu'il n'est pas possible de les "résumer" avec l'aide d'un dictionnaire de taille raisonnable (i.e. plus petit que le message lui-même).

Si tu veux réduire la taille d'un fichier, d'une paquet de donnée, etc. d'avantage tu n'a pas le choix : il faut sacrifier une partie de l'information.

Compression destructive:

Là on veut réduire d'avantage la taille du fichier à stocker ou du message à transmettre mais à cause de la limite théorique précédent on sait que l'on va être obligé de détruire de l'information.

Ce n'est pas toujours possible : si je prends un bouquin je ne vais pas m'amuser à retirer quelques mots d'une phrase. Quoique... On y arrive bien avec le style "SMS" où l'on s'amuse à retirer certaines lettre ou contracter certains sons mais ça demande au lecteur un peu de gymnastique et de souplesse. C'est là l'astuce.

Pour une image ou un fichier audio, on sait qu'une partie des détails ne sont pas perçus ou qu'ils ne sont pas "critiques" pour la compréhension.

L'idée est alors de bien étudier la façon dont on perçoit les choses (avec des études psychoacoustiques ou psychovisuelles) et de choisir de façon soigneuse l'information que l'on peut s'autoriser à perdre.

Que ce soit pour l'image, la vidéo ou le son, les algo de compression destructive procèdent tous de la même façon :

- On utilise un modèle qui permet de reconstruire le média à encoder.

- Une partie des données du modèles sont conservées et d'autres détruites en fonction de ce que peuvent tolérer nos sens et d'un objectif de "qualité perçue".

- L'information restante est encodée avec un codage exact.

De plus, le dictionnaire du codage exact est le plus souvent pré-calculé ; il n'est pas nécessaire de le transmettre.

Pour l'audio (mp3, AAC, etc.) l'approche est la suivante :

- Découpage du signal en trames de quelques millisecondes (le signal est saucissonné).

- Modélisation du signal par un modèle "Sinusoïdes + Bruit" pour chaque trame.

- Choix des sinusoïdes à conserver dans chaque trame en fonction d'un modèle psychoacoustique.

- Codage exact des paramètres du modèle "Sinusoïdes + Bruit" da chaque trame (avec un dictionnaire adapté aux signaux audio modélisés de cette façon).

Les différences entre le mp3 et l'AAC ne sont pas "fondamentales" et le principe reste le même.

En réalité, les améliorations du AAC résident dans le choix des tailles des trames et un critère de rejet psychoacoustique plus fin (en plus de "métadonnées" supplémentaires du genre de l'ID3).

Je te laisse digérer tout ça et tu auras peut-être des questions. Je te ferai un 2nd post pour détailler le principe du mp3 ou de l'AAC.

Lv mastering

Merci pour ces infos....Au niveau de la décomposition en bandes de fréquences, je me base sur les données du système ATRAC3 qui avait attiré mon attention par le biais du minidisc.

Le Mp3 utlise t-il le même système ?

Critical Band Frequency (Hz)

Band Low High Width

0 / 0 / 100 / 100

1 / 100 / 200 / 100

2 / 200 / 300 / 100

3 / 300 / 400 / 100

4 / 400 / 510 / 110

5 / 510 / 630 / 120

6 / 630 / 770 / 140

7 / 770 / 920 / 150

8 / 920 / 1080 / 160

9 / 1080/ 1270 / 190

10 / 1270 / 1480 / 210

11 / 1480 / 1720 / 240

12 / 1720 / 2000 / 280

13 / 2000 / 2320 / 320

14 / 2320 / 2700 / 380

15 / 2700 / 3150 / 450

16 / 3150 / 3700 / 550

17 / 3700 / 4400 / 700

18 / 4400 / 5300 / 900

19 / 5300 / 6400 / 1100

20 / 6400 / 7700 / 1300

21 / 7700 / 9500 / 1800

22 / 9500 / 12000 / 2500

23 / 12000 / 15500 / 3500

24 / 15500 / 22050 / 6550

Critical bands [7] arose from the idea that the ear analyzes the audible frequency range using a set of subbands. The frequencies within a critical band are similar in terms of the ear's perception, and are processed separately from other critical bands. Critical bands arose naturally from experiments in human hearing and can also be derived from the distribution of sensory cells in the inner ear. Critical bands can be thought of as the frequency scale used by the ear [8].

http://www.minidisc.org/aes_atrac.html

Studio de Mastering en ligne http://www.lvmastering.com/

[ Dernière édition du message le 02/11/2012 à 00:46:26 ]

EraTom

Je ne devrais pas venir sur ce forum après avoir passé une soirée arrosée...

Il y a un article de Wikipedia qui parle des bandes critiques : https://en.wikipedia.org/wiki/Critical_bands

En anglais. Je ne l'ai pas lu mais le dessin au milieu ressemble à ce que je connais.

Je ne suis pas expert en bio ou en médecine, mais c'est une info que j'ai exploité. Voici ce que j'en sais :

La bande critique représente la capacité de notre oreille à séparer 2 sons de fréquences proches, une sorte de résolution fréquentielle :

- Prends 2 sinusoïdes de fréquences éloignées : tu peux les différencier.

- Rapproche les fréquences l'une de l'autre : tu finis par entendre une seule fréquence avec une sorte de battement.

- Rapproche les encore : tu ne distingues qu'un seul son (le battement s'estompe) dont la fréquence se situe environ à la moyenne des 2 fréquences des 2 sinusoïdes.

La bande critique se trouve à la limite entre l'étape 2 et 3.

Tu peux aussi procéder dans l'autre sens :

- 2 sinusoïdes de fréquences égales Fc

- On les écarte d'une fréquence ΔF : F1 = Fc + ΔF/2 ; F2 = Fc - ΔF/2

- La largeur de la bande critique correspond au ΔF à partir duquel on peut distinguer les 2 sinusoïdes (ou que "quelque chose" change dans le son perçu).

La largeur de la bande critique ΔF varie avec la fréquence centrale Fc : plus Fc est grande, plus la largeur est grande.

C'est un phénomène qui est lié à la mécanique de notre oreille interne (en particulier le comportement de notre membrane basilaire http://www.humans.be/pages/physioaudition.htm )

On pourrait le montrer par un calcul de mécanique (du genre de celui des cordes vibrantes) mais il est plus simple de le mesurer (en tout cas, la théorie rejoint la mesure).

En 1990, Glasberg et Moore ont pendu une formule empirique qui permet de calculer la largeur de la bande critique (ERB pour Equivalent Rectangular Bandwidth) :

https://en.wikipedia.org/wiki/Equivalent_rectangular_bandwidth

Pour les valeurs de Fc allant de 100Hz à 10kHz il est possible d'utiliser une formule approximative simplifiée (un linéarisation, sachant que le modèle "filtre rectangulaire" est déjà une sacrée approximation du comportement de notre oreille) :

ERB = 24.7*(4.37*Fc/1000 + 1) Hz

La largeur évolue continument avec la fréquence centrale mais étant donnés les approximations des modèles et la dispersion qui peut exister d'un auditeur à un autre, il n'est pas moins pertinent de procéder comme le propose l'ATRAC3 i.e. fixer des largeurs types pour différents intervalles du domaine fréquentiel (on pourrait même les interpoler).

Le mp3 et l'AAC exploitent les bandes critiques mais utilisent aussi un modèle psycho-acoustique qui va plus loin, avec un masquage fréquentiel et temporel hérité du MUSICAM.

Si une fréquence est émise avec une pression importante, cette pression exercée sur l'oreille va temporairement empêcher la perception de pressions plus faibles dans d'autres bandes du spectre (plus loin que la bande critique). Quand cette pression importante disparait, l'effet de masquage persiste un petit moment avant de disparaître.

Pour expliquer ceci de façon un peu simpliste, l'oreille est fortement sollicitée par une pression à une certaine fréquence, et il faut un petit moment aux organes qui la composent pour revenir à la position de repos.

Une analogie avec nos yeux : tu reçois un flash qui t'éblouit et il faut un moment avant que tu puisses distinguer de nouveau ce que tu as en face de toi.

Il y a un article de Wikipedia (in english) qui explique le phénomène (enfin, plutôt ses conséquences). C'est le principe du modèle utilisé dans le mp3 :

https://en.wikipedia.org/wiki/Auditory_masking

Le § "Simultaneous masking" discute des bandes critiques que tu évoques et qui apparait quand 2 sons sont joués en même temps.

Le § "Temporal masking" explique le masquage fréquentiel persistant au cours du temps, qui est exploité par le mp3 de façon complémentaire au masquage précédent.

Tout ce qui est masqué peut être détruit en priorité, d'où l'importance d'avoir un modèle psycho-acoustique poussé.

[ Dernière édition du message le 02/11/2012 à 02:30:51 ]

offenbach

Site officiel et boutique en ligne du Studio Delta Sigma https://www.studiodeltasigma.com

SteackBeatz

Concernant le mp3, tu peux t'interesser ( plus ou moins profondément ) à la transformée de fourier , c'est un procedé mathématique utilisé lors de la compression en mp3 .

http://www.guardian.co.uk/technology/2002/apr/04/internetnews.maths

[edit] Si j'ai bien retenu ce que j'ai vu en cours , lors d'une conversion en mp3 , on extrait le spectre de fourier du signal audio et on retire ensuite l'ensemble des fréquences considérées comme inaudible ou inutiles .

Ma musique :

[ Dernière édition du message le 02/11/2012 à 10:22:33 ]

Anonyme

EraTom

Le modèles "Sinusoïdes" a été historiquement introduit dans cette publication qui traitait de la modélisation de la parole :

R.J. McAulay and T.F. Quatieri, "Speech analysis & synthesis based on a sinusoidal representation", IEEE Trans. on ASSP, Vol. 34, No. 4, August 1986.

Le principe est le suivant :

- Le signal est découpé dans le temps en trames successives de 10ms à 20ms.

- Sur chaque trame une analyse spectrale est réalisée (FFT ou autres, parce qu'il existe d'autres technique plus efficaces, comme la décomposition en sous-espace comme Matrix-Pencil dites "hautes-résolutions", etc.)

- On récupère les "pics" au dessus d'un certain seuil dans le spectre d'amplitude et les phases associées (une FFT le spectre d'amplitudes ET de phases).

- Le contenu de la trame est alors synthétisé comme une somme de sinusoïdes :

s_j(t) = ∑ a_i_j * sin( ω_i_j*t + φ_i_j ) où

- s_j est le signal de là j-ème trame.

- a_i_j est l'amplitude de la i-ème sinusoïde de la j-ème trame.

- ω_i_j sa pulsation (=2*π*f_i, où f_i est la fréquence).

- φ_i_j est la phase (au début de la trame).

- De trame en trame, les paramètres des sinusoïdes sont appairés : On essaie de reconstruite la "trajectoire" d'une composante sinusoïdale de trame à trame (un peu comme les lignes horizontale d'un spectrogramme).

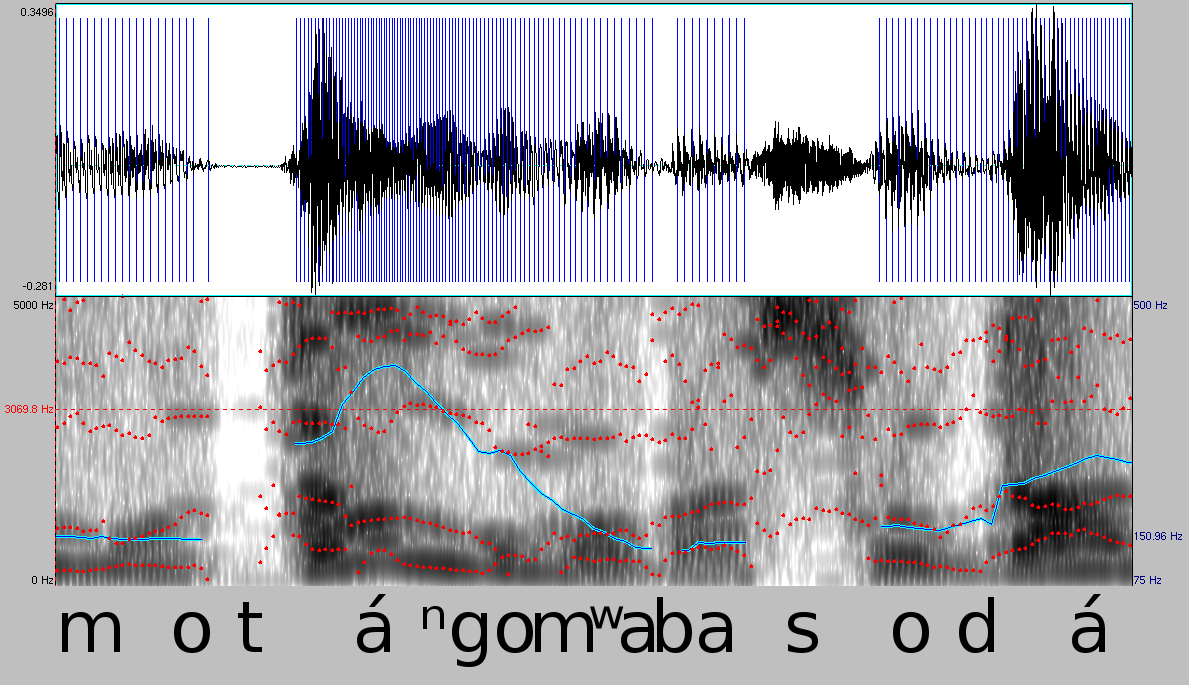

C'est ce qui est représenté dans cette image :

Quand l'appairage est réalisé, les paramètres des sinusoïdes sont interpolés par des polynômes. Pour la "phase" c'est un peu sioux, enfin, disons que l'on a trop l'habitude d'avoir une "fréquence constante".

Ce qu'il y a dans la sinusoïde est un angle qui évolue au cours du temps : φ(t)

La pulsation (proportionnelle à la fréquence) est la variation instantanée de cet angle, autrement dit sa dérivée :

ω(t) = dφ(t)/dt

Si on le prend dans l'autre sens, la phase est l'intégrale de la pulsation :

φ(t) = ∫ ω(t).dt

Dans le cas où ω(t) est une constante (le cas du signal stationnaire), on retrouve :

φ(t) = ω*t + φ0

où φ0 est la phase à l'origine.

Dans le modèle de McAulay et Quatieri, la pulsation est considérée constante lors de l'analyse, mais "variable" lors de la synthèse : les paramètres ω et φ sont interpolés de trame à trame en évitant des sauts de phases qui pourraient être audibles (on s'arrange pour que la phase à la fin de la trame précédente soit égale à la phase au début de la trame suivante, ce qui n'est pas assuré par l'étape d'analyse).

McAulay et Quatieri ont alors observé ceci : Pour un signal de parole, les voyelles (partie voisées) pouvaient être identifiées en remarquant que les trajectoires des paramètres des sinusoïdes pouvaient être crées facilement et qu'elles évoluaient continument.

En revanche, pour les consonnes, les paramètres des sinusoïdes évoluent de façon erratique et il est impossible de retrouver des trajectoires bien définies.

C'est là qu'arrive le modèles "Sinusoïdes + Bruit" pour la musique introduit dans cette publication :

X. Serra and J. Smith III, "Spectral Modeling Synthesis: A Sound System Based on a Deterministic plus Stochastic Decomposition", Computer Music Journal, Vol. 14, No. 4, Winter 1990.

Les consonnes ne sont pas des "signaux harmoniques" et ne sont pas non plus des "sommes de sinusoïdes indépendantes" : Ce sont plutôt des "bruits" ou encore des "processus stochastiques".

https://fr.wikipedia.org/wiki/Processus_stochastique

Pour la faire simple, ça revient à dire qu'à chaque instant 't' la valeur du signal 's(t)' se comporte comme une variable aléatoire.

Essayer de décrire son spectre par des sinusoïdes est inefficace : il vaut mieux le décrire avec des outils statistiques comme sa densité de probabilité, sa valeur moyenne, son écart-type, etc.

C'est d'ailleurs exactement ce que l'on fait lorsque que l'on parle de "densité spectrale de puissance", la puissance est vu comme issue d'un processus stochastique dont on calcul la moyenne des fréquences.

https://fr.wikipedia.org/wiki/Densit%C3%A9_spectrale_de_puissance

L'idée de X. Serra est la suivante :

- On fait une analyse en sinusoïdes comme le faisaient McAulay et Quatieri d'un signal réel x(t).

- On reconstruit les trajectoires des paramètres des sinusoïdes. Si ces trajectoires sont trop courtes (i.e. si elles n'existent que sur 1 à 3 trames) on les rejette. On interpole les trajectoires retenues.

- On resynthétise le signal à partir de l'analyse pour obtenir un signal approximatif s(t) ≈ x(t)

- On calcule un résidu r(t) = x(t) - s(t). En gros, celui-ci contient tout ce qui reste en dehors des sinusoïdes retenues.

- r(t) est décrit comme l'enveloppe d'amplitude spectrale d'un bruit.

Normalement, r(t) ne contient aucun "pic" puisque les sinusoïdes ont été retirées.

Imagine un spectre qui a cette tête :

http://spe.obs-mip.fr/var/ezspe/storage/images/media/images/spectre-radioactivite/2680-1-fre-FR/spectre-radioactivite_large.jpg

Les pics en rouge seraient modélisés dans s(t) puis retirés de x(t) pour former r(t). Pour modéliser r(t) Serra ne s'est pas emmerdé : il traçait des segments de droites qui représentaient grosso-modo le "plafond" du résiduel en bleu.

Tu obtiens ainsi un "bruit coloré" b(t) qui présente un spectre proche de celui de r(t).

Le signal reconstruit est x(t) ≈ s(t) + b(t).

Dans le mp3 et l'AAC, c'est ce modèle qui est utilisé.

Avant l'encodage, on utilise les modèles psycho-acoustique avec les histoires de masquage &co pour supprimer des parties de s(t), on détruit de l'information.

b(t) est modélisé par un modèle auto-régressif (c'est mieux que ce que faisait X. Serra).

https://fr.wikipedia.org/wiki/Processus_autor%C3%A9gressif

C'est la base du codage LPC (linear predictive coding) que l'on retrouve dans nos GSM.

https://en.wikipedia.org/wiki/Linear_predictive_coding

Le codage LPC vient lui aussi de la modélisation de la parole. C'est ce que l'on trouve dans les trucs de chat comme TeamSpeak, Skipe, etc.

Pour la parole le codage LPC suffit (on modélise tout avec). Ça "sonne" moins bien que le mp3 mais le débit est particulièrement bas : en fait le mp3 aurait du mal à atteindre la même qualité avec un débit aussi bas, surtout que la parole est faite de plus de 50% de consonnes (en français) que le modèle sinusoïdal est inefficace à représenter.

[ Dernière édition du message le 02/11/2012 à 11:46:36 ]

numa

c'est top tes explications !

Masteringaddict

50% de consonnes (en français) que le modèle sinusoïdal est inefficace à représenter

Serait-ce pour cette raison que le mp3 est aussi inefficace (qualitativement) sur les attaques et sur les aigus ?

[ Dernière édition du message le 02/11/2012 à 23:00:20 ]

EraTom

Bien vu, si tu cherches un son que le mp3 à vraiment du mal à représenter tu peux prendre un son percussif avec un spectre de bruit plutôt aigu : une cymbale.

Pour les aigus je crois (mais c'est à vérifier) que la raison principale est que c'est là que l'on trouve les largeurs de bandes critiques les plus grandes.

Le masquage y est plus important du coup c'est là que la destruction d'information opère en priorité.

Est-ce que c'est quelque chose que tu as perçu même à un débit élevé ?

J'ai bien une autre explication mais j'y reviendrai à la fin.

Pour les attaques, les sons brefs et les transitoires la raison est liée au modèle "Sinusoïdes + Bruit", avant même l'étape de destruction de l'information (je connais un peu mieux la question parce que j'ai bossé sur cette problématique). Il y a deux phénomènes qui interviennent.

Le premier est lié à une hypothèse de travail qui permet de faire de l'analyse spectrale (en gros, qui permet de calculer des FFT) qui n'est vérifiée que de façon approximative.

Pour calculer le spectre (périodogramme) d'un signal, celui doit être stationnaire (au sens large).

https://fr.wikipedia.org/wiki/Stationnarit%C3%A9_d%27une_s%C3%A9rie_temporelle

Pour un signal sinusoïdal (ou composé d'une somme de sinusoïdes) ceci revient à supposer que les fréquences et amplitudes ne varient pas au cours du temps.

C'est bien sûr faux pour un signal audio qui renferme de la musique...

L'astuce consiste alors à découper le signal en petites fenêtres de temps (les trames dont je parlais) et de supposer que les variations des amplitudes et fréquences dans une trame sont négligeables, autrement dit, que le signal est localement stationnaire.

C'est une approche qui tient la route pour quasiment tout le signal audio, sauf les attaques qui sont par essence des variations brutales.

Le modèle "Sinusoïdes + Bruit" du mp3, de l'AAC, etc. procède pourtant de cette façon. Le signal d'une trame qui contient une attaque ou un transitoire va quand-même être considéré comme stationnaire ; la conséquence est que l'attaque va être "moyennée" ou que "l'énergie va être étalée" sur toute la durée de la trame (qui est plus longue que celle de l'attaque).

Ceci n'est pas lié à la compression ou à la destruction d'information elles-même ; c'est directement imputable à la faiblesse du modèle de départ.

Pour corriger le tir, le mp3 et l'AAC proposent des longueurs de trames variables, des trames longues et des trames courtes :

- Tant que tout se passe bien (i.e. que l'hypothèse de stationnarité semble vérifiée) les trames longues sont utilisées.

- Dès qu'une attaque est détectée, la fenêtre d'analyse est réduite et on utilise les trames courtes pour "limiter" l'étalement.

Les modèles qui sont en gestation dans les labo aujourd'hui sont des modèles "Transitoires + Sinusoïdes + Bruit", voir "Transitoires + Sinusoïdes amorties + Bruit"

L'AAC permet d'atteindre des trames plus courtes que le mp3 ; ça améliore les perfo mais ça reste un modèle "Sinusoïdes + Bruit" (ce n'est pas encore la nouvelle génération d'encodeur audio).

Le second problème est lié à une limite théorique qui limite la résolution de l'analyse spectrale si la trame est trop courte.

Si certains ont entendu parler du "principe d'incertitude d'Heisenberg" en mécanique quantique (qui a l'air vachement compliquée) ils seront peut-être surpris d'apprendre que le problème se pose également pour l'analyse temps-fréquence en traitement du signal. Ce principe (qui est en fait un théorème) a été reformulé par Gabor (celui de la décomposition en ondelettes) ; même Wikipedia en parle :

https://fr.wikipedia.org/wiki/Principe_d%27incertitude#Exemples

En gros, ce que montre ce théorème est que si le support temporel d'un signal est étroit alors sa représentation fréquentielle est large (et inversement). Plus précisément :

σt * σf > 2π (c'est la formulation de la limite théorique)

où

σt caractérise l'étalement temporel.

σt caractérise l'étalement fréquentiel.

Ça donne directement la relation suivante :

σf > 2π / σt

En clair, même si le signal peut être considéré stationnaire sur une trame très courte, on sera incapable de démêler les fréquences des sinusoïdes qui composent le signal en calculant une FFT parce que les "pics" seront trop étalés (jusqu'à être confondus). Si on s'y prend "bien", on peut même se retrouver avec un seul gros pâté au milieu du spectre... Et là on est content.

Pour travailler avec des trames courtes il faut alors développer une autre technique que la FFT. Les solutions sont les méthodes dites HR (Haute Résolution).

Au lieu d'estimer le périodogramme (avec une FFT) puis de relever les pics, on utilise assez souvent un "modèle paramétrique" :

- Le signal temporel est considéré comme une fonction du temps que l'on impose de façon arbitraire. On laisse tout de même quelques "degrés de libertés" i.e. des paramètres de la fonction que l'on peut/veut ajuster.

- Le problème est alors de trouver le jeu de paramètres qui permet de coller au mieux au signal réel i.e. de minimiser le résidu ou l'erreur de modélisation.

Un cas concret : On décrète que notre signal est une somme de N sinusoïdes (ça tombe bien, c'est ce que l'on veut construire à la fin).

Chaque sinusoïde est affublée de trois paramètres : son amplitude a_i, sa pulsation ω_i et sa phase initiale φ_i (i allant de 1 à N).

La fonction que l'on veut faire coller à notre signal réel est alors :

s(t) = ∑ a_i * sin( ω_i*t + φ_i )

Mathématique l'estimation des 3*N paramètres devient un problème d'optimisation : J'ai un signal réel x(t) et je veux trouver le s(t) le plus proche possible de x(t). On exprime alors l'erreur quadratique moyenne et on veut qu'elle soit la plus petite possible :

On cherche les (a_i, ω_i, φ_i) tels que < ( x(t) - s(t) )² > soit minimum.

En fait, c'est la méthode des moindres carrés.

(en vérité, dans la littérature, les méthodes réalisent le plus souvent l'estimation en 2 étapes : d'abord on trouve les pulsations par une méthode de décomposition/projection en sous-espace (le nom évoque peut-être quelque chose à celui qui a déjà utilisé ce genre d'outil), ensuite on cherche les amplitudes et phases qui minimisent l'erreur quadratique, mais l'idée générale reste la même).

L'estimation des paramètres du modèle sinusoïdal par les techniques HR est bien une approche différente de celle de la FFT.

Avec la FFT :

- On calcule un spectre d'amplitude et de phase sans connaissance, a priori, du modèle final.

- On relève les pics du spectre, que l'on va représenter par des sinusoïdes. On commence par les pics les plus importants et on poursuit avec les plus petits. On arrête dès que ceux-ci sont noyés dans le bruit.

Avec les méthodes HR :

- On impose le modèle temporel (ce qui introduit une connaissance a priori) ; dans mon exemple on impose même le nombre total de sinusoïdes "N" de façon arbitraire.

- On cherche ensuite les paramètres suivant un critère d'optimalité (minimiser l'erreur quadratique moyenne).

Si la méthode HR permet de résoudre le problème de la résolution fréquentielle pour l'analyse des trames courtes, elle en pose un autre :

- On doit choisir un "N" avant de faire l'analyse et ceci peut être problématique. Il faut donc trouver une méthode supplémentaire qui permet d'estimer l'ordre du modèle (et cette méthode ne passera pas par une FFT puisqu'elle ne permet pas d'atteindre la bonne résolution).

- Si on se plante dans le choix de N (parce qu'il en fallait N+1 ou N-1) il faut quand-même que l'algorithme qui réalise l'optimisation ne parte pas dans les choux et converge vers une solution acceptable. Ça demande un vrai savoir faire en "algorithmes numériques" ; pour donner une idée, il y a des mecs qui font des thèses de math (bac+8) sur le sujet (d'ailleurs, c'était une partie de mon sujet de thèse

J'imagine (mais je n'ai pas vérifié) que pour proposer des trames plus courtes avec l'AAC qu'avec le mp3 un effort particulier a été porté sur l'analyse spectrale HR.

Je reviens maintenant sur ce que tu évoquais avec les aigus pour fournir un complément d'explication (mais ça reste de la spéculation parce que je n'ai pas mis le nez dedans).

Dans le cas d'un encodeur, on peut/doit fixer un débit max à ne pas dépasser et l'information codées est justement l'ensemble des paramètres du modèle "Sinusoïdes + Bruit" de chaque trame.

Comme le débit est limité, le nombre de sinusoïdes l'est aussi. J'ai vu des publications où c'était cette limite qui servaient à fixer le nombre maximal de sinusoïdes pour l'analyse HR.

Or il se trouve que les algorithmes d'optimisation les plus utilisés tendent à faire converger les sinusoïdes dans le bas du spectre (là où il y a le plus d'énergie). Si le nombre de sinusoïdes a priori est sous évalué, alors le haut du spectre ne sera pas pris en compte.

Il me semble que la solution classique pour contourner ce problème est de travailler par bandes de fréquence (on répartit le nombre de sinusoïde sur chaque bandes et on réalise l'optimisation pour chaque bande). Et, comme d'hab, ça pose un autre problème : comment choisir les bandes et comment repartir les sinusoïdes entre les bandes ? Faut-il les équirépartir ? Ou bien faut-il tout de même privilégier le bas du spectre où l'on a le plus de chance de trouver des sinusoïdes ?

Je crois qu'il n'y a pas vraiment de solution totalement satisfaisante aujourd'hui.

Historiquement les méthodes HR par décomposition en sous-espace viennent du domaine médical ; elles sont utilisées dans les IRM.

Ze big expert dans le domaine, qui a fait sacrément avancé le sujet, c'est une dame : Sabine Van Huffel

http://homes.esat.kuleuven.be/~biomed/person.php?persid=17

Sur sa page on trouve des liens vers des publications sur les méthodes HR qui font toujours référence.

Elle s'est même amusée à proposer une méthode qui permet de calculer conjointement les pulsation et les facteurs d'amortissement d'un modèle de sinusoïdes amorties en haute résolution (la classe). Par contre elle n'a pas les mêmes problématiques que dans l'audio (elle s'en fout des transitoires des crash cymbals, tout ce qui l'intéresse c'est de trouver des tumeurs

[ Dernière édition du message le 03/11/2012 à 02:35:32 ]

Masteringaddict

Cette expérience m'avait amené à découvrir les beautés (et les horreurs) de l'erreur expérimentale

Pour répondre à ta question, oui, j'entends les artefacts du mp3 sur des sons aigus et

ce , même à des débits de 320 kbps (au delà, autant passer en compression FLAC non destructive).

Ce que j'aime bien dans ton post, c'est de voir qu'il existe des pistes pour créer de nouveaux algorithmes.

Il est vrai qu'il me semble de mémoire que (à l'oreille) la compression effectuée par le minidisc était moins destructive et plus "musicale".

Anonyme

EraTom

Un codage exact (ou une compression sans perte si tu préfères) se heurte toujours à une limite théorique infranchissable, quelque soit l'algorithme, et tu peux le mettre en défaut assez simplement.

Génère un son aléatoire, un bruit blanc (attention, un "vrai" avec très peu de corrélation) en stéréo (2 bruits indépendants pour les canaux de droite et de gauche) et essaie de le compresser avec FLAC : tu verras que le taux de compression sera très proche de 0% (tu n'auras pas 0 parce que les générateurs de nombres aléatoires sur ordinateur ne sont jamais parfaits).

Si tu as lu mon premier post sur la compression sans perte tu as du voir que je parlais de "table de Huffman" et que je prenais l'exemple du zip.

Le zip fait un encodage "aveugle" et construit son dictionnaire comme un bourrin. Pour qu'il atteigne des taux de compression similaire à celui du FLAC il faudrait le laisser tourner très longtemps pour qu'il trouve un dictionnaire optimal or, on ne lui en laisse pas le temps parce que l'on préfère que le temps de compression soit raisonnable (et compatible avec un usage de la vie courante).

Le FLAC est dédié à la musique et son algorithme oriente la construction du dictionnaire de façon intelligente en tirant parti de connaissance a priori sur la forme du signal à encoder (ce que ne peut pas faire le zip).

De plus, le zip est obligé de transmettre le dictionnaire, alors que le FLAC possède un dictionnaire partiellement pré-calculé (on n'est pas obligé de transmettre le dictionnaire dans sa totalité, ce qui engendre un gain de place supplémentaire).

C'est une approche assez classique, en fait, qui consiste à utiliser un modèle compact pour approcher le signal réel, puis on encode l'erreur de modélisation avec un codage exact (je n'ai pas vérifié en détail, mais c'est l'état de l'art, même pour les algo de compression d'image).

Pour t'expliquer ça simplement, il procède de manière similaire au mp3 sans la partie "destruction d'information" :

- Le signal découpé en trames.

- Les corrélations entre les canaux gauche et droit sont relevées, en passant d'un modèle "gauche/droite" à un modèle "milieu/côté".

Usuellement, un CD est mixé de façon à ce que le maximum d'information soit contenu au milieu, sauf sur quelques passages où l'on veut produire un effet particulier. Les deux codages ("gauche/droite" ou "milieu/côté" ) sont comparés dans chaque trame pour déterminé lequel est le plus efficace (et on peut passer de l'un à l'autre entre chaque trame si besoin).

- Pour chaque canal et chaque trame, on a un signal réel x(t) que l'on va modéliser par un modèle "Somme de Sinusoïdes" pour former un signal synthétique s(t).

Dans le cas d'un signal audio, la somme de sinusoïdes est un modèle "compact" (c'est du jargon d'ingé ou docteur en traitement du signal). Ceci veut dire que quelques paramètres permettent de représenter un nombre assez important d'échantillons.

Imagine une sinusoïde a * sin( ω*t + φ ) @44.1kHz sur 20 ms (une petite trame), ça représente 882 valeurs. Or pour la décrire complètement tu as seulement besoin de 3 paramètres (amplitude, pulsation et phase). Ça fait un rapport de presque 1 pour 300 valeurs.

Ensuite, d'une trame à une autre on sait que les sinusoïdes n'évoluent pas (dans la grande majorité des cas, i.e sauf sur les attaques et les transitoires) de façon brutale : au lieu de coder pour chaque sinusoïde les paramètres on ne va coder que leurs petites variations.

Les valeurs sont donc moins grandes, et peuvent être codées sur une quantité de bits plus petites que si on devait coder toute la dynamique de valeur possibles des paramètres.

D'ailleurs, même sans parler de modèle sinusoïdale, si tu prends un fichier wav et que tu calcules la différence des valeurs échantillon par échantillon, tu t’aperçois que la dynamiques des différences et bien plus petite que la dynamique totale du signal, sauf sur une attaque.

Bon, je reviens sur l'encodage lui-même.

- Pour chaque trame on a un modèle s(t) assez représentatif du signal réel x(t). Là, contrairement au mp3, il n'y a pas de destruction d'information dans s(t) (on ne retire pas les fréquences masquées).

Même si le modèle s(t) est proche de x(t) il n'est pas parfait ; il y a des erreurs. On les calcule simplement en faisant une différence : err(t) = x(t)-s(t).

Usuellement, cette erreur s'appelle un "résidu". Il présente également une dynamique plus petite que x(t) (parce que le modèle est tout de même efficace), sauf sur les transitoires.

Pour pouvoir reconstruire le signal x(t) sans perte il suffit de transmettre le modèle s(t) et le résidu err(t) :

x(t) = s(t) + err(t)

On réalise alors un codage exact de err(t), avec un algorithme similaire au zip.

Je ne crois pas que FLAC et ses "confrères" utilisent un modèle compact pour les transitoires, sinon je pense que j'en aurais entendu parler (j'ai bossé sur les modélisations de transitoires pour les encodeurs prochaines générations).

Ce qui me fait dire ça c'est qu'il s'agit d'un format gratuit, or s'il y avait eu une évolution remarquable, ou une amélioration qui sort de l'état de l'art, celle-ci aurait sans aucun doute été brevetée

On peut donc s'attendre à voir venir, un jour, un algo plus performant que FLAC. 2 pistes :

1ère piste :

Utiliser un modèle "Sinusoïdes amorties" a * exp(τ*t) * sin( ω*t + φ ).

Les études actuelles (enfin, ça presque 10 ans qu'on le sait maintenant) montrent qu'en rajoutant un seul paramètre d'amortissement "τ" on peut augmenter la longueur des trames d'un rapport 3 environ tout en conservant des résidus de modélisation équivalents.

Imagine que l'on ait N sinusoïdes dans une trame de durée T, ça fait 3*N paramètres pour un temps T. Pour coder 3 trames il faudrait transmettre 3*3*N = 9*N paramètres.

Avec la prise en compte du facteur d'amortissement ça ferait à la place 4*N paramètres pour une trame de durée 3*T.

Ce nouveau modèle est donc plus compact ; tu as rapport d'un peu plus de 2.

2nde piste :

Aujourd'hui, le résidu contient les transitoires et les attaques qui ne sont pas représenté convenablement par le modèle "Sinusoïdale". On sait déjà que les sinusoïdes amorties font mieux, mais on peut aller encore plus loin en utilisant un modèle adapté aux transitoires spécifiquement : les ondelettes par exemple.

Tu aurais un signal réel reconstruit à partir de 3 signaux :

x(t) = s(t) + a(t) + err(t)

s(t) serait constitué de trames longues avec un modèle "sinusoïdes amortie"

a(t) serait constitué de trames courtes avec un modèle de transitoire fondé sur les ondelettes.

err(t) serait le résidu compressé avec un codage exact du type zip, certainement plus efficacement qu'avec le résidu précédent parce qu'il contient moins d'information (on lui a retiré les transitoires).

Patience, ça va venir, et je te fais le pari qu'il s'agira d'un schéma très similaire à celui que je te propose et qu'il pourra faire 10 à 20% de mieux que le FLAC.

[ Dernière édition du message le 04/11/2012 à 21:14:23 ]

Etienne1992

Mes réalisations : http://www.rallu-sound.ch

Anonyme

Au fait, quelqu'un connaîtrait un livre en français sur ce sujet, ou plus largement la numérisation du son etc... Avec les explications des différents théorèmes : Nyquist etc... Je voudrais vraiment comprendre exactement comment ces phénomènes sont expliqués.

EraTom

Concernant les bouquins, j'en vois un qui n'est pas mal du tout : L'audionumérique : Musique et informatique de Curtis Roads.

https://www.dunod.com/loisirs-scientifiques-techniques/audio-photo-video/son-et-acoustique/laudionumerique

Je l'avais lu pour voir un peu quelques cas concrets d'applications de la théorie du signal dans le monde de l'audio.

Il montre des applications, discute et décrit certains problèmes. Par contre il ne va pas aussi loin que moi dans mes posts.

Après je connais quelques bouquins très théoriques... le problème c'est que ça demande un niveau bac+2 / bac+3 en math (et quand je dis math c'est math universitaire ou math sup / spé).

Je ne voudrais surtout pas paraître pédant, ou te donner l'impression de vouloir te décourager, mais le truc c'est que le traitement du signal demande un formalise mathématique assez conséquent. Ça rebute même pas mal d'étudiants ; on retrouve souvent des physiciens théoriciens ou des matheux qui passent aux math appliquées.

Ce qui est bien avec la physique (et le signal c'est de la physique) c'est que l'on peut faire passer les concepts de façon intuitive, mais dans le cas du théorie du signal ce n'est pas si évident parce que les prérequis en math restent tout de même assez importants. Bref ce n'est pas un exercice facile et je ne connais pas de bouquin de niveau intermédiaire

Par exemple tu évoques le théorème de Nyquist-Shannon. Le résultat est assez simple à expliquer : le spectre est répliqué à chaque fréquence multiple de la fréquence d’échantillonnage.

La conséquence est aussi simple une fois que l'on admet le résultat : si des fréquences dépassent les "bords" du spectre répliqués vont se recouvrir (l'aliasing).

Ça suffit à comprendre pourquoi il faut mettre des filtres d'antialiasing.

Pour montrer d'où vient la duplication des bandes spectrales... c'est une autre paire de manches.

Perso j'essaierai de montrer ce qui se passe avec une seule sinusoïde échantillonnée :

- On prend une sinusoïde à une fréquence quelconque.

- On l'échantillonne à une autre fréquence quelconque. On obtient un ensemble de points (échantillonnés).

- On montre que l'on peut trouver une infinité de sinusoïdes qui passent parce ces points, et qu'elles sont espacées d'un multiple de la fréquence d'échantillonnage.

Ce genre de mini-démo ça ne demande que de connaitre les formules trigo (cos(a+b) = ... etc.) et ça peut aider à fournir une première explication. Je te la fournis dans un autre topic si tu veux (j'aimerais éviter dévier de la question initiale d'Étienne).

Par contre, si tu veux vraiment montrer le vrai théorème par bandes spectrales c'est tout de suite plus costaud :

- Tu prends un signal quelconque à une dimension (un processus stochastique pour être plus général https://fr.wikipedia.org/wiki/Processus_stochastique )

- Tu le multiplies temporellement avec un peigne de Dirac https://fr.wikipedia.org/wiki/Peigne_de_Dirac pour modéliser l'action de l'échantillonnage.

- Tu calcule ensuite la densité spectrale de puissance comme l'espérance mathématique de la transformée de fourrier du signal obtenu https://fr.wikipedia.org/wiki/Densit%C3%A9_spectrale#Densit.C3.A9_spectrale_de_puissance

- Tu constates qu'il y a duplication du spectre.

Je précise "à une dimension, le temps" parce que l'on a le même phénomène en traitement d'image "2 dimensions, les lignes et les colonnes", sur les IRM "3 dimensions de l'espace" ou la video "2 dimensions image + 1 dimension pour le temps"... pour 4 dimensions l'IRM fonctionnelle "3 dimensions de l'espace + 1 dimension pour le temps"... et même pour un nombre quelconques de dimensions (et là c'est des math qui ressemblent à de la science fiction, mais qui trouve des applications pour trouver le boson de Higgs, par exemple).

Tu vois que même la "démo" de Wikipedia sur les propriétés du peigne de Dirac précise "En oubliant toute rigueur" parce que normalement il faut définir :

- l'impulsion de Dirac comme une "distribution" https://fr.wikipedia.org/wiki/Distribution_de_Dirac

- dans le cadre de la théorie de la mesure https://fr.wikipedia.org/wiki/Th%C3%A9orie_de_la_mesure

- sur des espaces topologiques https://fr.wikipedia.org/wiki/Espace_topologique

- où pour le calcul de la densité spectrale de puissance on utilise l'intégration au sens de Lebesgue https://fr.wikipedia.org/wiki/Int%C3%A9grale_de_Lebesgue

Pour rendre le calcul "plus simple", tu peux utiliser le fait qu'un produit dans l'espace temporel est un produit de convolution dans l'espace des fréquences.

https://fr.wikipedia.org/wiki/Produit_de_convolution

C'est le théorème de Fubini :

https://fr.wikipedia.org/wiki/Th%C3%A9or%C3%A8me_de_Fubini

Ça pique, mais si tu veux vraiment comprendre exactement comment ces phénomènes sont expliqués ça passe par là.

Je vais te dire, la plupart des ingé des grandes écoles, qui sont tout de même passés par math sup/spé, regardent la démo une fois, l'oublient, et se contentent d'appliquer le résultat. (voir, ils changent leurs options pour ne plus faire de traitement du signal

En fait, plus je poste de truc ici en essayant d'expliquer certaines idées de la théorie du signal, plus je me dis qu'il faudrait que je me lance dans la rédaction d'un bouquin de niveau intermédiaire à destination des audiophiles, parce que je crois que ça n'existe pas et que l'on peut lire de vraies âneries qui tiennent parfois du mysticisme.

Je ne sais pas si j'aurais le courage et je ne pense pas y arriver seul (parce que j'aurais bien besoin d'un relecteur pour corriger des erreurs que je pourrais faire).

[ Dernière édition du message le 05/11/2012 à 01:16:39 ]

Anonyme

plus je me dis qu'il faudrait que je me lance dans la rédaction d'un bouquin de niveau intermédiaire à destination des audiophiles

Ouais, bonne idée.

Etienne1992

Je fais des podcsts pour une webradio. Nous enregistrons en Wav et convertissons le tout après édition en MP3 169 kbps (stéréo). C'est de la radio, donc ultra compressé et tout le temps très proche du 0FS. Un des responsable techniques prétend que de normaliser à -0.3 FS au lieu de 0FS éviterait certains artefacts du MP3. As-tu une explication à ce phénomène (autre que psychologique) ?

Mes réalisations : http://www.rallu-sound.ch

- < Liste des sujets

- Charte

- 1

- 2