Comment agissez-vous face à la latence ?

- 13 réponses

- 9 participants

- 1 494 vues

- 12 followers

Maléficié

26

Nouvel·le AFfilié·e

Membre depuis 3 ans

Sujet de la discussion Posté le 08/02/2023 à 20:14:06Comment agissez-vous face à la latence ?

Bonjour, je voudrais lancer une discussion sur la latence et sur comment vous agissez face à celle-ci

Comme vous le savez les plugins vont induire de la latence en fonction de ce qu'ils font et de la marque, que faites-vous face à cela ?

Est-ce qu'en général vous avancez les tracks de quelques ms/sample pour contrer cela ? Est-ce que vous utilisez les options "zero latency" ?

Ou alors est-ce que vous trouvez que ça sonne mieux avec la latence ?

Je sais qu'un EQ analogique par exemple induit du retard et donc un déphasage car il agit sur une bande de fréquence, celle-ci se retrouve retardée par rapport aux autres bandes de fréquences (je crois que c'est cela); cela va donner une certaine particularité au son

Est-ce que chaque matériel analogique produit un retard plus ou moins léger à sa sortie ou est-ce que ce n'est que les EQ ?

Voilà j'espère que le sujet vous intéressera

Comme vous le savez les plugins vont induire de la latence en fonction de ce qu'ils font et de la marque, que faites-vous face à cela ?

Est-ce qu'en général vous avancez les tracks de quelques ms/sample pour contrer cela ? Est-ce que vous utilisez les options "zero latency" ?

Ou alors est-ce que vous trouvez que ça sonne mieux avec la latence ?

Je sais qu'un EQ analogique par exemple induit du retard et donc un déphasage car il agit sur une bande de fréquence, celle-ci se retrouve retardée par rapport aux autres bandes de fréquences (je crois que c'est cela); cela va donner une certaine particularité au son

Est-ce que chaque matériel analogique produit un retard plus ou moins léger à sa sortie ou est-ce que ce n'est que les EQ ?

Voilà j'espère que le sujet vous intéressera

Anonyme

2 Posté le 09/02/2023 à 08:35:18

Déjà il est bon de séparer le processus de création/enregistrement et le processus de mix où on sort effectivement les plugins.

Par exemple il y a le delay compensate sur Protools, qui est nickel en Mix mais qu'on évite d'utiliser en Rec (ça met le bazar dans les retours). On pourra mieux te conseiller si tu nous dis quel DAW tu utilises.

Oui les filtres retardent certaines phases mais ce n'est généralement pas gênant, sinon il existe les Eq linéaires qui gardent la phase en place, c'est parfois utile quand on double une piste par exemple. Par contre les Eq linéaires sont plus gourmandes en ressources CPU.

Les vrais Eq analogiques induisent également un décalage de phase, ce qui est propre à la conception d'un filtre, mais il ne faut pas voir ça comme du retard à proprement parlé, un son rentre et sort d'un circuit analogique à la vitesse de la lumière (enfin presque). Par contre le retard est inhérent aux systèmes numériques qui nécessitent un certain temps de traitement (acquisition + calculs).

Par exemple il y a le delay compensate sur Protools, qui est nickel en Mix mais qu'on évite d'utiliser en Rec (ça met le bazar dans les retours). On pourra mieux te conseiller si tu nous dis quel DAW tu utilises.

Oui les filtres retardent certaines phases mais ce n'est généralement pas gênant, sinon il existe les Eq linéaires qui gardent la phase en place, c'est parfois utile quand on double une piste par exemple. Par contre les Eq linéaires sont plus gourmandes en ressources CPU.

Les vrais Eq analogiques induisent également un décalage de phase, ce qui est propre à la conception d'un filtre, mais il ne faut pas voir ça comme du retard à proprement parlé, un son rentre et sort d'un circuit analogique à la vitesse de la lumière (enfin presque). Par contre le retard est inhérent aux systèmes numériques qui nécessitent un certain temps de traitement (acquisition + calculs).

1

Anonyme

3 Posté le 09/02/2023 à 08:48:44

Pas de souci en phase d'enregistrement depuis plus de 15 ans, il suffit d'utiliser des plugins avec peu ou sans latence.

Au mix, on s'en fiche.

Dans tous les cas, la latence est compensée.

Je ne vois pas ce qui te pose problème.

Au mix, on s'en fiche.

Dans tous les cas, la latence est compensée.

Je ne vois pas ce qui te pose problème.

1

[ Dernière édition du message le 09/02/2023 à 08:49:04 ]

Dead Flowers

11

Nouvel·le AFfilié·e

Membre depuis 3 ans

4 Posté le 09/02/2023 à 08:59:20

Je produis, j'enregistre et je mix sur logic/vienna ensemble pro depuis des années et j'ai toujours des soucis de latence que ce soit dans le jeu des instruments ou en playback. L'unique solution pour moi: recaler à l'oreille, à la main. C'est très long mais ça marche. Pour le jeu (guitare avec amplitube ou kontakt par exemple) il existe un mode faible latence dans logic mais ça coupe les modules trop gourmand (réverbes) donc on a pas le même son/ niveau avec cette fonction.

0

Anonyme

5 Posté le 09/02/2023 à 09:09:38

Attention, beaucoup de musiciens jouent "avant le temps", et ça n'a rien à voir avec la latence. Ça se corrige en recalant, mais surtout, ça se travaille, et ensuite on peut jouer avec le temps de façon propre.

0

hallucinoze

347

Posteur·euse AFfamé·e

Membre depuis 22 ans

6 Posté le 09/02/2023 à 09:19:41

Salut,

Comme dit Papy Serge, en mixage à la différence de la phase de composition, la latence n'a pas trop d'importance.

Mais c'est pas normal de devoir recaler à la main, il y a a mon avis un disfonctionnement quelques part.

Il me semble que toutes les stations audionumériques embarquent un module de gestion de la latence.

Cà vaut le coup de prendre un moment et d'experimenter:

J'ai lu que les cartes sons etaient optimisées pour etre economes en resources à leur vitesse maximale.

Du coup, c'est gagnant/gagnant le cpu est economisé et la latence diminuée du fait de la vitesse d'échantillonnage elevée.

Du coup, enregistrer à 96khz a du sens.

Jouer avec la taille des buffer aussi selon la sceance de composition ou d'enregistrement.

Ce qui m'a beaucoup aidé aussi, c'est d'avoir une partition windows dediée à cubase.

Donc pas de reseau, pas d'antivirus, firewall ou vpn, pas de gadget multimedia, pas de mise à jour.

Tout va bien plus vite que ma partition windows du quotidien.

Est ce que quelqu'un a fait des tests sur la consomation cpu de sa carte son en fonction de la vitesse d'échantillonnage ?

Comme dit Papy Serge, en mixage à la différence de la phase de composition, la latence n'a pas trop d'importance.

Mais c'est pas normal de devoir recaler à la main, il y a a mon avis un disfonctionnement quelques part.

Il me semble que toutes les stations audionumériques embarquent un module de gestion de la latence.

Cà vaut le coup de prendre un moment et d'experimenter:

J'ai lu que les cartes sons etaient optimisées pour etre economes en resources à leur vitesse maximale.

Du coup, c'est gagnant/gagnant le cpu est economisé et la latence diminuée du fait de la vitesse d'échantillonnage elevée.

Du coup, enregistrer à 96khz a du sens.

Jouer avec la taille des buffer aussi selon la sceance de composition ou d'enregistrement.

Ce qui m'a beaucoup aidé aussi, c'est d'avoir une partition windows dediée à cubase.

Donc pas de reseau, pas d'antivirus, firewall ou vpn, pas de gadget multimedia, pas de mise à jour.

Tout va bien plus vite que ma partition windows du quotidien.

Est ce que quelqu'un a fait des tests sur la consomation cpu de sa carte son en fonction de la vitesse d'échantillonnage ?

0

Maléficié

26

Nouvel·le AFfilié·e

Membre depuis 3 ans

7 Posté le 09/02/2023 à 09:36:02

Citation de PapySerge :

Déjà il est bon de séparer le processus de création/enregistrement et le processus de mix où on sort effectivement les plugins.

Par exemple il y a le delay compensate sur Protools, qui est nickel en Mix mais qu'on évite d'utiliser en Rec (ça met le bazar dans les retours). On pourra mieux te conseiller si tu nous dis quel DAW tu utilises.

Oui les filtres retardent certaines phases mais ce n'est généralement pas gênant, sinon il existe les Eq linéaires qui gardent la phase en place, c'est parfois utile quand on double une piste par exemple. Par contre les Eq linéaires sont plus gourmandes en ressources CPU.

Les vrais Eq analogiques induisent également un décalage de phase, ce qui est propre à la conception d'un filtre, mais il ne faut pas voir ça comme du retard à proprement parlé, un son rentre et sort d'un circuit analogique à la vitesse de la lumière (enfin presque). Par contre le retard est inhérent aux systèmes numériques qui nécessitent un certain temps de traitement (acquisition + calculs).

Je n'ai pas mentionné mais je parlais pour le mixage, mes excuses

Je ne demandais pas particulièrement de conseil à ce propos, je voulais plutôt connaitre l'attitude des utilisateurs d'audiofanzine face à cela, je sais qu'il m'arrive parfois de calculer la latence induite par les plugins d'une piste et d'avancer cette même piste de la valeur de latence indiquée par Ableton afin qu'elle reste toujours recalée par rapport à l'ensemble.

Je constate à l'oreille une assez grande différence entre avec et sans recalage, notamment pour les drums où le son change totalement en fonction de si on recale ou non en sortie de piste (notamment si on utilise des plugins avec beaucoup de latence comme le pro G); on peut se retrouver avec une snare moins impactante dû au décalage induit par les plugins entre la snare top et la snare bot par exemple.

Cependant je sais que des ingénieurs mix ont conscience de cette problématique et ne retardent pas leurs pistes, ainsi je voulais connaitre les points de vue des gens présents ici pour peut-être ouvrir de nouvelles portes créatives en mixage

1

Eric Music Strasbourg

4598

Squatteur·euse d’AF

Membre depuis 18 ans

8 Posté le 09/02/2023 à 10:07:15

Citation de hallucinoze :

Salut,

Comme dit Papy Serge, en mixage à la différence de la phase de composition, la latence n'a pas trop d'importance.

Mais c'est pas normal de devoir recaler à la main, il y a a mon avis un disfonctionnement quelques part.

Il me semble que toutes les stations audionumériques embarquent un module de gestion de la latence.

Cà vaut le coup de prendre un moment et d'experimenter:

J'ai lu que les cartes sons etaient optimisées pour etre economes en resources à leur vitesse maximale.

Du coup, c'est gagnant/gagnant le cpu est economisé et la latence diminuée du fait de la vitesse d'échantillonnage elevée.

Du coup, enregistrer à 96khz a du sens.

Jouer avec la taille des buffer aussi selon la sceance de composition ou d'enregistrement.

Ce qui m'a beaucoup aidé aussi, c'est d'avoir une partition windows dediée à cubase.

Donc pas de reseau, pas d'antivirus, firewall ou vpn, pas de gadget multimedia, pas de mise à jour.

Tout va bien plus vite que ma partition windows du quotidien.

Est ce que quelqu'un a fait des tests sur la consomation cpu de sa carte son en fonction de la vitesse d'échantillonnage ?

Hélas non.

Plus la.frequence d'échantillonnage est élevée et plus la consommation cpu augmente. À 96 c'est 2 fois plus en cpu qu'en 48.. ça suit donc exactement la rapport fréquence d'échantillonnage.

Par contre la latence est divisée par 2. Le nom re de vsti est alors réduit puisque le cpu ne pourra plus suivre .

Sans compter que si la conso cpu n'est que de 60% par exemple mais qu'un cœur est à 100% il y a imediatement des glitschs (artefact).

L'audiovisuel étant en "temps réel " demande une puissance de calcul faramineuse. Plus la fréquence de base du cpu est élevé et son mode turbo aussi, plus le phénomène de saturation est repoussé. Le problème étant alors la chaleur dégagée qui devient invivable pour le cpu.

Contrairement à ce qui a.ete écrit le hardware a de la latence. On a d'ailleurs créé des lignes à retard.

Le spl hardware etait aussi pour cela permettant de remettre en phase un son.

Ce qui a été écrit sur le fait de rajouter les plugin au mix n'est pas faux. Perso il y a quelques années je travaillais avec une reverb hardware pour la prise et le confort du chanteur puis j'utilisais un vstfx au mix.

Pour la compression j'utilisais un 1176LN hardware pour gagner quelques db mais.aussi pour assurer la prise sans saturation numérique puis je voyais le reste au mix.

Il va sans doute y avoir du changement sur la règle du rendement du cpu en rapport avec la fréquence avec les cpu 7900x3d de chez AMD grâce au cache étendu. La mémoire cache est 5 fois plus rapide que la ddr5 6000 plus d'espace dans le cpu pour stocker = moins d'aller retours.

On constate sur les jeux une élévations des fps. Il y a fort à pailler que si c'est nouveau processeurs 3d perdent 300 mégahertz de vitesse de base la mémoire cache colossale permet d'accroître de 25% les résultats par rapport au cpu 7950x sorti en septembre. Ils sont identiques en tout point sauf sur le cache plus élevé mais la fréquence plus basse.

Je ferai quelques bench sur top confog 2023 sur AF. Je vais aussi comparer si cela intéresse induit ou non une baisse de la latence pour un même buffet et une même fréquence ce qui n'est pas si évident que ça. En revanche su la puissance cpu est décuplée il serait possible de réduire le buffet et donc de diminuer la latence sans arriver au problème de saturation cpu sur un cœur qui cause les glitsch... à.suivre...

0

Eric

purplefox

358

Posteur·euse AFfamé·e

Membre depuis 19 ans

9 Posté le 09/02/2023 à 10:07:27

Hello, ça m'intrigue ce que tu dis, je fais des racks parfois complexes sous Ableton dans divers contextes, je ne constate pas de problèmes de compensation de latence. Ableton affiche d'ailleurs la latence de chacun des plugins à titre informatif.

1

Wolfen

14019

Drogué·e à l’AFéine

Membre depuis 23 ans

10 Posté le 09/02/2023 à 10:33:41

Alors, attention à ne pas confondre plusieurs concepts

Déjà la latence qu'est-ce que c'est ? Chaque joujou numérique fonctionne avec des convertisseurs analogiques / numériques et vice-versa, et présente à la partie purement DSP des échantillons sonores à traiter par bloc d'une taille donnée. Dans le contexte d'un ordinateur PC ou mac, avec un DAW en élément central pour faire de la musique, on a une latence induite par la partie conversion en entrée, par la partie conversion en sortie, et aussi par ce que les plug-ins dans le DAW vont avoir envie de rajouter. On a la même chose d'ailleurs sur du hardware quand celui-ci est numérique.

Le plus souvent, on connaît surtout la latence de la conversion en entrée, parce que c'est celle sur laquelle on peut agir dans les paramètres du DAW et de la carte son. Ainsi, si on sélectionne manuellement une taille de buffer de 256 échantillons par exemple, et qu'on travaille avec une fréquence d'échantillonnage de 96 kHz, on va avoir une latence sur la partie entrée de 256 / 96 000 = 2.66667 ms. A laquelle il faudra ajouter également la latence sur la conversion de sortie - qui est rarement indiquée dans les DAWs malheureusement (je la vois dans Reaper par contre par exemple) - souvent du même ordre de grandeur, et aussi un offset qui dépend de ce que la carte son fait en plus en interne. Là par exemple je viens de faire le test sur ma RME Babyface, avec 256 samples et 96 kHz Reaper me dit 3.3/3.6 ms, soit une latence totale cumulée de 6.9 ms si je joue de la guitare en direct (en général je descend beaucoup plus bas heureusement en taille de buffer pour ce genre d'utilisation).

Plusieurs remarques à ce sujet :

Pour terminer, un petit point sur le "analogique" vs "numérique". Oui, il y a de la latence ajoutée parfois induite par l'analogique, mais elle est plus que négligeable, sauf si vous faites des enregistrements acoustiques où on doit ajouter dans l'équation de la distance physique entre un émetteur et un microphone. Cette distance va également rajouter une certaine latence, vitesse du son non instantanée oblige, et il arrive presque systématiquement que les ingénieurs du son s'amusent à "recaler" des enregistrements entre eux pour compenser ces distances, que ce soit pour des amplis + enceintes guitare avec des micros positionnés à différentes distances des HPs, ou pour un mix général de batterie acoustique notamment sur la caisse claire.

Car ces recalages peuvent avoir un impact sonore pour des raisons différentes de la latence, à savoir la phase. Les deux micros caisse claire donnent souvent des signaux qui sont "hors phase", c'est-à-dire qui mixés vont créer des annulations sur certaines plages fréquentielles, notamment parce que les micros en question sont souvent positionnés dans un sens différent par rapport à la caisse claire. Pour résoudre le problème, il suffit dans ce cas et dans d'autres simplement d'inverser la phase d'une des deux pistes pour retrouver du contenu fréquentiel. Il arrive aussi qu'on fasse appel à des plug-ins de rotation de phase (un peu plus rare) pour pouvoir avoir accès à tous les réglages intermédiaires entre "toucher à rien" et inverser la phase.

Mais parfois ça ne suffit pas, on sent qu'il manque un truc, et on n'arrive pas à le récupérer. Alors on décale un peu une piste par rapport à une autre pour essayer d'améliorer le son. Dans ce cas, il arrive qu'on soit en face d'un problème d'annulation de phase, lié à un traitement appliqué sur deux pistes de façons différentes, avec ces deux pistes qui sont très corrélées, c'est-à-dire qui sont faites d'un enregistrement provenant de la même source, comme deux micros caisse claire, ou une prise guitare enregistrée sur deux micros. Dans ces cas là, le souci vient du traitement qui diffère, par exemple un filtre analogique utilisé que sur un seul micro, ou un filtre numérique sur une des pistes. La vraie solution dans ces cas là, c'est la fameuse phase linéaire, qui va gommer les modifications faites sur la phase du signal par le filtre en question (si il est numérique, parce que si c'était analo évidemment c'est fichu), de manière à ce que la sommation des deux signaux corrélés ne produise plus d'annulations de phase ou de modifications fréquentielles. Faites le test, copiez-collez le contenu d'une piste dans une seconde piste, écoutez les deux ensemble en mettant sur une des deux un filtre sans phase linéaire puis avec, par exemple un passe bas résonant. La piste filtrée seule va sonner pareil dans les deux cas, par contre la somme des deux sera plus propre et plus riche en phase linéaire qu'en phase minimale.

Voilà ce que je peux dire sur le sujet

Déjà la latence qu'est-ce que c'est ? Chaque joujou numérique fonctionne avec des convertisseurs analogiques / numériques et vice-versa, et présente à la partie purement DSP des échantillons sonores à traiter par bloc d'une taille donnée. Dans le contexte d'un ordinateur PC ou mac, avec un DAW en élément central pour faire de la musique, on a une latence induite par la partie conversion en entrée, par la partie conversion en sortie, et aussi par ce que les plug-ins dans le DAW vont avoir envie de rajouter. On a la même chose d'ailleurs sur du hardware quand celui-ci est numérique.

Le plus souvent, on connaît surtout la latence de la conversion en entrée, parce que c'est celle sur laquelle on peut agir dans les paramètres du DAW et de la carte son. Ainsi, si on sélectionne manuellement une taille de buffer de 256 échantillons par exemple, et qu'on travaille avec une fréquence d'échantillonnage de 96 kHz, on va avoir une latence sur la partie entrée de 256 / 96 000 = 2.66667 ms. A laquelle il faudra ajouter également la latence sur la conversion de sortie - qui est rarement indiquée dans les DAWs malheureusement (je la vois dans Reaper par contre par exemple) - souvent du même ordre de grandeur, et aussi un offset qui dépend de ce que la carte son fait en plus en interne. Là par exemple je viens de faire le test sur ma RME Babyface, avec 256 samples et 96 kHz Reaper me dit 3.3/3.6 ms, soit une latence totale cumulée de 6.9 ms si je joue de la guitare en direct (en général je descend beaucoup plus bas heureusement en taille de buffer pour ce genre d'utilisation).

Plusieurs remarques à ce sujet :

- Evidemment, les plug-ins vont eux-même potentiellement rajouter de la latence supplémentaire. Ce n'est pas toujours le cas, mais ça arrive spécifiquement dans certains types de plug-ins avec plus ou moins d'importance, tels que les EQs et autre outils qui proposent la phase linéaire dans les traitements (je vais y revenir d'ailleurs), les algorithmes qui pourraient fonctionner sans latence mais le font quand même avec pour réduire un peu leur charge CPU ou paralléliser des tâches (je pense aux réverbs à convolution qui font ça parfois, ou encore aux synthés avec des systèmes d'attributions de voix un peu complexes), certains types de traitements comme les compresseurs et limiteurs avec de "l'overhead", et enfin tous les plug-ins qui font de la distorsion et autres traitements non linéaires, les algos qui ont besoin d'une certaine quantité d'échantillons à traiter avant de pouvoir en renvoyer en sortie (ce qui arrive souvent dès que y a de la FFT comme dans les pitch shifters à quelques exceptions près), et ceux qui ont besoin d'oversampling pour réduire les phénomènes de repliement, l'oversampling étant souvent une opération qui rajoute de la latence.

- Comme la latence en secondes se calcule en fonction de la taille de buffer et de la fréquence d'échantillonnage, on peut se douter qu'il est possible aussi de réduire la latence pendant une session d'enregistrement en passant du 44.1 kHz au 96 kHz. Attention dans ces cas-là, il arrive par exemple qu'on puisse descendre jusqu'à 48 échantillons en 44.1 kHz, mais pas aussi bas en 96 kHz, bien vérifier dans chaque cas la latence minimale et réelle en secondes qu'on obtient.

- Mais alors pourquoi ne pas simplement descendre le plus bas possible tout le temps en latence ? Et bien, il se trouve que certains types de plug-ins, pas tous attention, peuvent consommer beaucoup plus de ressources CPU lorsque la latence est basse. Sur un projet complexe, il est de bon ton ainsi de garder une basse latence au début, pour faire les enregistrements correctement et avec un certain confort, puis de passer à une latence plus élevée plus tard, pendant la phase de mix, ce qui permet d'accumuler plus de plug-ins dans la session.

- Normalement, la totalité des DAWs ont des fonctionnalités enclenchées automatiquement de gestion de la latence, qui permet de caler correctement tous les enregistrements et toutes les pistes les unes par rapport aux autres à l'échantillon près sur la même base de temps. Dans Pro Tools, il me semble qu'ils ont mis un certain temps à rendre ça aussi fluide que chez les concurrents, mais normalement personne ne devrait jamais avoir à recaler des enregistrements les uns par rapport aux autres pour compenser une latence. Sinon ça veut dire qu'il y a eu un problème quelque part (fonction de gestion de la latence désactivée quelque part, plug-in qui n'indique pas la latence qu'il ajoute au DAW, instrumentiste qui ne sait pas jouer dans le temps oui oui ça arrive

). En tout cas c'est pas la faute du DAW, et c'est pas non plus quelque chose de normal, personne ne fait jamais ça en 2023 !

). En tout cas c'est pas la faute du DAW, et c'est pas non plus quelque chose de normal, personne ne fait jamais ça en 2023 !

Pour terminer, un petit point sur le "analogique" vs "numérique". Oui, il y a de la latence ajoutée parfois induite par l'analogique, mais elle est plus que négligeable, sauf si vous faites des enregistrements acoustiques où on doit ajouter dans l'équation de la distance physique entre un émetteur et un microphone. Cette distance va également rajouter une certaine latence, vitesse du son non instantanée oblige, et il arrive presque systématiquement que les ingénieurs du son s'amusent à "recaler" des enregistrements entre eux pour compenser ces distances, que ce soit pour des amplis + enceintes guitare avec des micros positionnés à différentes distances des HPs, ou pour un mix général de batterie acoustique notamment sur la caisse claire.

Car ces recalages peuvent avoir un impact sonore pour des raisons différentes de la latence, à savoir la phase. Les deux micros caisse claire donnent souvent des signaux qui sont "hors phase", c'est-à-dire qui mixés vont créer des annulations sur certaines plages fréquentielles, notamment parce que les micros en question sont souvent positionnés dans un sens différent par rapport à la caisse claire. Pour résoudre le problème, il suffit dans ce cas et dans d'autres simplement d'inverser la phase d'une des deux pistes pour retrouver du contenu fréquentiel. Il arrive aussi qu'on fasse appel à des plug-ins de rotation de phase (un peu plus rare) pour pouvoir avoir accès à tous les réglages intermédiaires entre "toucher à rien" et inverser la phase.

Mais parfois ça ne suffit pas, on sent qu'il manque un truc, et on n'arrive pas à le récupérer. Alors on décale un peu une piste par rapport à une autre pour essayer d'améliorer le son. Dans ce cas, il arrive qu'on soit en face d'un problème d'annulation de phase, lié à un traitement appliqué sur deux pistes de façons différentes, avec ces deux pistes qui sont très corrélées, c'est-à-dire qui sont faites d'un enregistrement provenant de la même source, comme deux micros caisse claire, ou une prise guitare enregistrée sur deux micros. Dans ces cas là, le souci vient du traitement qui diffère, par exemple un filtre analogique utilisé que sur un seul micro, ou un filtre numérique sur une des pistes. La vraie solution dans ces cas là, c'est la fameuse phase linéaire, qui va gommer les modifications faites sur la phase du signal par le filtre en question (si il est numérique, parce que si c'était analo évidemment c'est fichu), de manière à ce que la sommation des deux signaux corrélés ne produise plus d'annulations de phase ou de modifications fréquentielles. Faites le test, copiez-collez le contenu d'une piste dans une seconde piste, écoutez les deux ensemble en mettant sur une des deux un filtre sans phase linéaire puis avec, par exemple un passe bas résonant. La piste filtrée seule va sonner pareil dans les deux cas, par contre la somme des deux sera plus propre et plus riche en phase linéaire qu'en phase minimale.

Voilà ce que je peux dire sur le sujet

4

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

[ Dernière édition du message le 09/02/2023 à 10:34:27 ]

Maléficié

26

Nouvel·le AFfilié·e

Membre depuis 3 ans

11 Posté le 09/02/2023 à 11:58:28

Merci beaucoup pour les précisions théoriques, ça m'aide à y voir plus clair notamment du côté hardware qui m'est totalement étranger

0

Eric Music Strasbourg

4598

Squatteur·euse d’AF

Membre depuis 18 ans

12 Posté le 09/02/2023 à 17:17:15

Juste pour information sur cubase il y a une fonction Contraindre la compensation du délai.

Lorsqu'il est necessaire d'enregistrer une guitare par exemple cette fonction est fort utile.

Les principaux vstfx... qui produisent de la latence supplémentaire sont désactivés momentanément. Ceci permet alors d'enregistrer sans être victime du surcroît de latence. Ensuite on désactive la fonction. Le mix initial revient comme avant l'enregistrement. La latence de la carte son quant à elle est i compressible en dehors des réglages buffers / fréquences

Lorsqu'il est necessaire d'enregistrer une guitare par exemple cette fonction est fort utile.

Les principaux vstfx... qui produisent de la latence supplémentaire sont désactivés momentanément. Ceci permet alors d'enregistrer sans être victime du surcroît de latence. Ensuite on désactive la fonction. Le mix initial revient comme avant l'enregistrement. La latence de la carte son quant à elle est i compressible en dehors des réglages buffers / fréquences

0

Eric

[ Dernière édition du message le 10/02/2023 à 23:32:22 ]

rroland

27466

Modérateur·trice thématique

Membre depuis 21 ans

13 Posté le 09/02/2023 à 20:14:53

Je ne constate aucun souci de latence au mix, la plupart des logiciels possèdent une compensation automatique de latence.

2

Rroland www.studiolair.be

hallucinoze

347

Posteur·euse AFfamé·e

Membre depuis 22 ans

14 Posté le 24/07/2023 à 12:01:44

Salut,

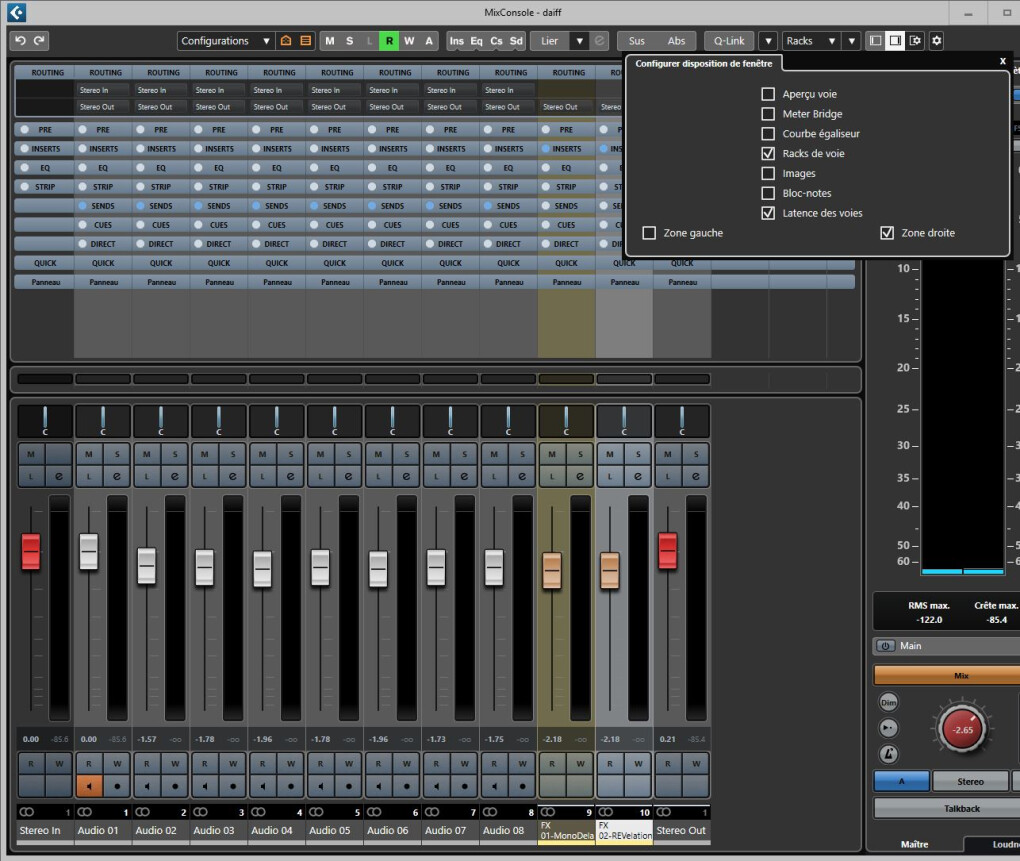

pour ce qui concerne Cubase, il y a aussi l'affichage de la latence induite par les effets extérieurs (conversion/Fx/conversion) dans le configurateur de Studio.

mais encore dans la console de mixage pour les inserts

0

- < Liste des sujets

- Charte