réactions au dossier Dossier sur les processeurs à convolution

- 30 réponses

- 20 participants

- 1 519 vues

- 26 followers

Wolfen

14016

Rédacteur·trice

Membre depuis 23 ans

Sujet de la discussion Posté le 20/02/2024 à 17:00:05Dossier sur les processeurs à convolution

Aujourd'hui, c'est l'heure de mettre à jour notre fameux dossier sur les applications de l'opération de convolution numérique dans la M.A.O. ! Presque 20 ans après, quels en sont les usages principaux aujourd'hui, et y a-t-il encore des territoires à défricher ?

Lire l'article

Ce thread a été créé automatiquement suite à la publication d'un article. N'hésitez pas à poster vos commentaires ici !

Lire l'article

Ce thread a été créé automatiquement suite à la publication d'un article. N'hésitez pas à poster vos commentaires ici !

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

- 1

- 2

Francisbr

4

Nouvel·le AFfilié·e

Membre depuis 21 ans

26 Posté le 25/02/2024 à 10:40:10

Bonjour Wolfen,

Merci pour cet article.

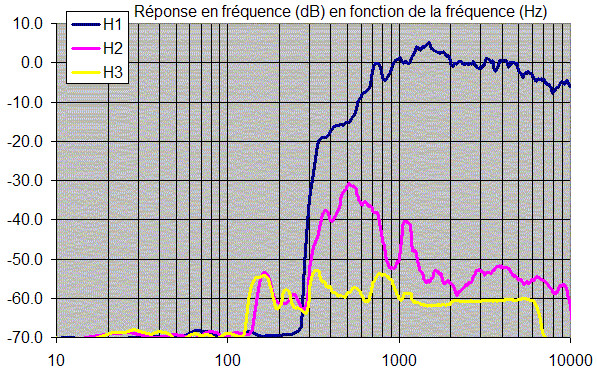

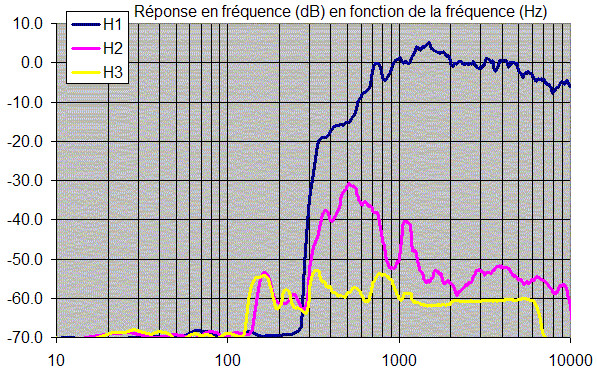

Il y a quelques années (2004), dans le cadre de la mesure de la réponse en fréquence d'une enceinte, j'utilisai Cool Edit (maintenant Adobe Audition) associé au Plug-In Aurora d'Angelo Farina.

Ce dernier permettait de générer le sine sweep, puis, une fois celui-ci enregistré, d'effectuer la convolution afin d'obtenir la réponse impulsionnelle de l'enceinte dans son environnement.

Après application d'une FFT on obtenait la réponse en fréquence ainsi que les spectres de distorsion :

C'était le bon vieux temps...

Bien cordialement.

Francis

www.francisaudio.fr

Merci pour cet article.

Il y a quelques années (2004), dans le cadre de la mesure de la réponse en fréquence d'une enceinte, j'utilisai Cool Edit (maintenant Adobe Audition) associé au Plug-In Aurora d'Angelo Farina.

Ce dernier permettait de générer le sine sweep, puis, une fois celui-ci enregistré, d'effectuer la convolution afin d'obtenir la réponse impulsionnelle de l'enceinte dans son environnement.

Après application d'une FFT on obtenait la réponse en fréquence ainsi que les spectres de distorsion :

C'était le bon vieux temps...

Bien cordialement.

Francis

www.francisaudio.fr

3

[ Dernière édition du message le 25/02/2024 à 10:48:24 ]

Wolfen

14016

Rédacteur·trice

Membre depuis 23 ans

27 Posté le 26/02/2024 à 16:06:19

Citation de grol :

Hello, super article !

Mais alors, ma question est : comment sont faites les simulations de systèmes non-linéaires ? Par exemple toutes ces simulations de La2a, 1176 et autres préamplis? Je suis un utilisateur de la série Slatedigital VMR que j'adore, et je me suis toujours dis que cela devait fonctionner avec une sorte de convolution par pas, comme si on avait un échantillonnage d'IR pour avoir la réponse du système à chaque niveau d'énergie... Je sais pas si je suis clair?

Merci beaucoup !

Pour tout ce qui est non linéaire, on utilise principalement la modélisation physique aujourd'hui, même on voit apparaître de plus en plus de Machine Learning

1

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

miles1981

8370

Je poste, donc je suis

Membre depuis 21 ans

28 Posté le 27/02/2024 à 16:21:34

Pas surprenant des details vu le redacteur

Je me souviens avoir etudie la possibilite de faire une simulation (3D acoustique) dans une piece pour generer l'IR et faire des calculs psychoacoustiques pour savoir si la salle est adaptee (concert, salle de classe, etc).

Apres pour la partie machine learning, au moins, c'est le bon terme qui est utilise, pas le terme galvaude et hype d'IA, j'apprecie :D

Je me souviens avoir etudie la possibilite de faire une simulation (3D acoustique) dans une piece pour generer l'IR et faire des calculs psychoacoustiques pour savoir si la salle est adaptee (concert, salle de classe, etc).

Apres pour la partie machine learning, au moins, c'est le bon terme qui est utilise, pas le terme galvaude et hype d'IA, j'apprecie :D

1

Audio Toolkit: http://www.audio-tk.com/

Wolfen

14016

Rédacteur·trice

Membre depuis 23 ans

29 Posté le 28/02/2024 à 10:46:08

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

Wolfen

14016

Rédacteur·trice

Membre depuis 23 ans

30 Posté le 28/02/2024 à 10:46:36

Citation de miles1981 :

Pas surprenant des details vu le redacteur

Je me souviens avoir etudie la possibilite de faire une simulation (3D acoustique) dans une piece pour generer l'IR et faire des calculs psychoacoustiques pour savoir si la salle est adaptee (concert, salle de classe, etc).

Apres pour la partie machine learning, au moins, c'est le bon terme qui est utilise, pas le terme galvaude et hype d'IA, j'apprecie :D

Merci

0

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

alphatruc

1226

AFicionado·a

Membre depuis 16 ans

31 Posté le 28/02/2024 à 12:50:48

Merci beaucoup pour cet article très interressant, assez détaillé, très intelligible, cela donne une vue d'ensemble très concrete des choses.

Cela fait monter le niveau d'intérêt pour AF (maintenant je vais devoir un peu surveiller les actus AF)

Chouette !

Et merci car il y a toujours quelque chose que l'on ne connait pas encore et qui aide a comprendre les choses quand c'est si bien expliqué

et d'après ce que j'en comprend sur ce fameux rédacteur Wolfen il semble obtenir le respect de gens qui sont très compétant dans ce forum, donc encore bravo [/i]

[/i]

Cela fait monter le niveau d'intérêt pour AF (maintenant je vais devoir un peu surveiller les actus AF)

Chouette !

Et merci car il y a toujours quelque chose que l'on ne connait pas encore et qui aide a comprendre les choses quand c'est si bien expliqué

et d'après ce que j'en comprend sur ce fameux rédacteur Wolfen il semble obtenir le respect de gens qui sont très compétant dans ce forum, donc encore bravo

1

Tamburini & Liberatore

[ Dernière édition du message le 28/02/2024 à 12:56:23 ]

- < Liste des sujets

- Charte

- 1

- 2