Top config PC MAO 2019 (test, bench, discussion, débat...)

- 1 600 réponses

- 70 participants

- 106 103 vues

- 79 followers

Darkmoon

Ce sujet est la suite logique de celui intitulé :

Top config PC MAO 2018 (test, bench, discussion, débat...)

(Dernière page ici.)

...où nous avons effectué plusieurs tests, dès le printemps 2018, concernant les nouveaux processeurs du moment, comme le i7 8700k, sous différents DAW/STAN (station de travail audio numérique).

Nous poursuivons donc ici à causer des nouveaux processeurs du moment, comme le i7 9700k et i9 9900k sous Socket 1151, ceux de la série X, comme les i9 9820X, 9800X, 9920X, 9940X, 9960X, 9980XE sous Socket 2066, et, bien sûr, les Ryzen 7 3700X, 3800X, 3900X et les Threadripper 1900X, 1920X, 1950X, 2920X, 2950X, 2990WX.

Mais tous sont bienvenus, peu importe leur processeur!

Nous effectuons parfois des tests et des benchs. Nous causons aussi de configuration MAO et d'optimisation, de notre façon de bosser dans tel ou tel DAW, etc. Nous partageons nos machines et configs et aiguillons les newbs et/ou ceux qui posent des questions vers la machine la plus appropriée pour leur besoin et, bien sûr, nous débattons parfois, mais dans la bonne humeur et le respect, parce que nous sommes passionnés, mais ne partageons pas tous forcément les mêmes idées et opinions (ce qui est très bien ainsi!).

Voilà, en souhaitant de bons échanges à tous!

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

[ Dernière édition du message le 11/09/2019 à 04:37:29 ]

2Rmusic

Facebook du Cercle d'Amy mon groupe de deux!

Et notre deezer : Le cercle d'Amy sur deezer

Eric Music Strasbourg

https://www.numerama.com/tech/635882-thunderbolt-4-3-questions-pour-comprendre-lavenir-des-ports-de-votre-ordinateur.html

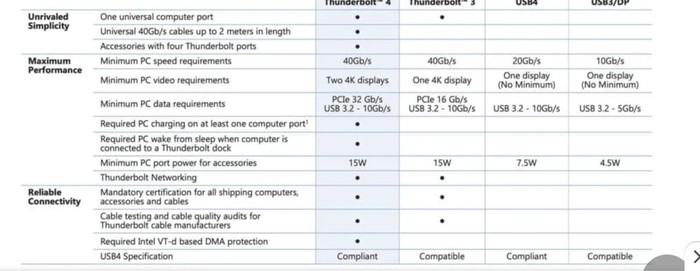

la spécification impose plusieurs contraintes, comme la prise en charge de deux écrans 4K ou d’un écran 8K ainsi que du PCIe à 32 Gbit/s. Afin de mettre un terme à la confusion sur les différents types de câbles, Intel préconise un câble Thunderbolt 4 universel, symbolisé par le logo en forme d’éclair, décliné en longueurs de 0,2 m, 0,8 m et 2 m et qui supporte un débit de 40 Gbit/s. Des câbles de 5 à 50 mètres de long sont également envisagés.

Eric

[ Dernière édition du message le 26/12/2020 à 20:09:25 ]

SpaceEko

Quelle est la carateristique d'une carte mère que je dois prendre en compte si je veux que le CPU soulage ma GTX960 4G vieillissante et me permette de la garder encore un peu ( je fais un peu de gaming mais cette GTX commence à trainer la pate sur les jeux actuels ).

J'ai entendu dire que c est quelque-chose de possible , depuis peu.

Je sais qu'on est sur un forum musique mais bon vu qu'il y a des connaisseurs dans le coin.. je demande au cas ou

JohnnyG

Le changement le plus bénéfique en jeux c'est encore la carte graphique. Et en ce moment c'est un peu compliqué. Le neuf est difficile à trouver et les risques de trouver une carte d'occasion qui ne soit pas rincé par du minage de bitcoin est faible. Et l'occasion est surcoté...

SpaceEko

[ Dernière édition du message le 27/12/2020 à 00:45:22 ]

JohnnyG

Avec certains CPU qui avait un chipset vidéo intégré ( ce qui n'est pas le cas des i7 ou i9) dans des portables on pouvait activer, dans certaines conditions, le chipset pour la bureautique et ne se servir du gpu que pour les grosses applications et les jeux. Ça augmentait l'autonomie des portables.

Le mieux que tu puisses faire c'est soit OC ta carte, mais faut pas s'attendre à un miracle. Si tu as ne serait ce que 10% de c'est énorme, et je ne te parles pas des problèmes de stabilité, température et autres consommation de courant.. L'autre option, est de trouver une autre 960 qui ne doit pas coûter grand chose et faire un sli.

Faut que tu ais encore un port PCI Express de libre et que ta carte mère le permette...

Dans une optique de jouer, il vaut largement privilégier le budget GPU que CPU, c'est largement plus profitable pour les FPS.

SpaceEko

D'une manière générale j'ai toujours été contre l'overclocking donc je ne vais pas m'y aventurer même si pas mal matos actuel à l'air prévu et conçu dans ce sens.

Ma priorité est d'avoir une config musclée pour la musique , mon budget va dans ce sens , le gaming est secondaire mais bienvenu.

Merci pour les infos et la bonne idée !

[ Dernière édition du message le 27/12/2020 à 03:49:19 ]

Hindy

Avec certains CPU qui avait un chipset vidéo intégré ( ce qui n'est pas le cas des i7 ou i9) dans des portables on pouvait activer, dans certaines conditions, le chipset pour la bureautique et ne se servir du gpu que pour les grosses applications et les jeux. Ça augmentait l'autonomie des portables.

Bonjour ;

À moins que je ne parle pas de la même chose certains CPU récents ont un chipset graphique intégré. J’utilise un I7 9700 K et je n’ai pas de carte graphique, mes deux écrans sont directement connectés à la carte mère. En revanche je pense que pour les jeux il faut oublier, en particulier en 4K. Pour mon usage MAO, je ne suis pas limité pour l’instant, ça fonctionne étonnamment bien.

J’espère que je parle bien de la même chose que vous.

Au passage, merci pour tous ces précieux renseignements qu’on peut lire ici.

JohnnyG

Hindy

Aujourd’hui je me sers du chipset graphique du CPU par priorité d’investissement, en vu d’autres dépenses pour l’amélioration de mon poste de travail, la CG n’étant pas d’une importance capitale pour mon usage. A terme il y aura une CG correcte pour gagner en fluidité d’affichage surtout si j’investis dans un ou des écrans plus performants.

[ Dernière édition du message le 27/12/2020 à 10:44:25 ]

Anonyme

....Je sais, je vais paraître prétentieux, ....

Non.

Tu ressemble juste à un type qui, à force de s'intéresser au truc, développe un certain degrés d'expertise. Et comme tu n'est pas avare de tes trouvailles, ça sert aux autres. Donc, tu peux continuer. Et même si tu te la pétais un peu, vu le niveau, ça ne serait pas répréhensible. Mais vu que ton humilité t'honore…

[ Dernière édition du message le 28/12/2020 à 00:57:17 ]

madamereve

Un petit lien sur un sujet qui parle.du Thunderbolt 4.

Le TB4 arrive sur des laptops

https://www.inpact-hardware.com/article/2225/le-pc-portable-expertbook-b9-14-dasus-passe-a-tiger-lake

madamereve

Un utilitaire excellent pour télécharger tous vos iso de Win7 à Win10. Tous types de versions et MAJ. Je me suis fait ma rafale de distribs.

https://www.heidoc.net/joomla/technology-science/microsoft/67-microsoft-windows-and-office-iso-download-tool

SpaceEko

Pour ma config j'ai choisi de la ram qui tourne à 3600 Mhz et CL16 ( Gskills ).

Sachant que la carte mère que j'ai choisi peut accepter jusqu'a 4600 Mhz mais bon le prix de la ram s'envole trop haut , donc je suis toujours dans le compromis.

https://shop.hardware.fr/fiche/AR201909300082.html

Est ce que c'est suffisant pour la musique ?

Freudon

Moi j'ai de la G-Skill Trident Néo 128gb 3600mhz en CL18.

Pour tous mes instruments vst c'est top.

Après tout dépend ce que tu veux dire par musique.

Freudon

Et pour la musique il vaut mieux un système stable donc a 3600mhz

Enfin c'est mon avis

SpaceEko

C'est pas pour faire tourner 128 pistes audio d'un groupe mais plutot pour charger pas mal de VST sans me poser trop de questions et traiter mes synthés hardware via les entrées de la carte son , avec des effets vst aussi.

madamereve

Darkmoon

@Darkmoon

https://audiogridder.com/#audiogridder

Idée et concept très interessant!

Peut-être pas pour le jeu en temps réel à très basse latence (à tester), mais pour des sessions de mixage intensives et/ou de l’orchestration/musique à l’image (avec éditeur de partition/piano roll), ça permet d’utiliser plus d’un PC en tant que serveur de plugins (instrument et FX). Un peu comme VEP en fait, mais avec bcp plus de latitude~liberté, si j’ai bien compris.

La première idée d’utilisation qui me vient en tête : utiliser notre ancien PC uniquement comme serveur de plugins (on le reformate et le dédie qu’à cet usage)! Ou alors faire le contraire : utiliser notre nouvelle « bête de course » comme serveur et l'ancien PC uniquement en tant que client~DAW.

Par contre, j’anticipe quelques « désagréments/problèmes/questions » :

- puisque le « PC serveur » devient un « logiciel hôte à plugins », ça implique que les licences/gestionnaires de licence (iLok License Manager/eLicenser, etc) doivent être installé sur ce PC. Conséquemment, pour les plugins ne permettant pas d’être installé sur plus d’un PC, faut faire un choix : installer sur le PC serveur ou sur le PC DAW~client (si l’on veut pouvoir les utiliser normalement, directement sur le PC où est notre DAW, comme à l’habitude).

- ils disent que la GUI des plugins est capturée et retransmise vers le PC DAW~client, mais je doute que cette GUI soit dynamique et permet d’interagir avec les potards et boutons sur cette dernière (ils semblent dire que oui, mais je comprends pas trop comment. Faudrait que la capture se fasse à n image/s ainsi que le « pointage » de la souris, le tout retransmis, rafraîchi en temps réel dans les 2 directions

). Donc faut utiliser un éditeur générique... ...moins pratique.

). Donc faut utiliser un éditeur générique... ...moins pratique. - sur le site, je ne trouve aucune explication sur le réseau en tant que tel.

Est-ce à dire que cela ne nécessite rien de particulier (AVB/Dante?)? Suffit que chaque PC soit relié à notre réseau local via RJ45 (ou WIFI) sur notre routeur/box ?

Est-ce à dire que cela ne nécessite rien de particulier (AVB/Dante?)? Suffit que chaque PC soit relié à notre réseau local via RJ45 (ou WIFI) sur notre routeur/box ? - et, surtout, quid de la latence? C'est sûr que tout ça doit induire au moins 3~4ms en plus, j'imagine.

Bref, à tester! Et merci pour le lien!

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Darkmoon

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

madamereve

Le serveur AudioGridder fonctionne sur un ordinateur qui héberge vos plugins d'effets et d'instruments. Sur votre poste de travail, sur lequel vous exécutez votre logiciel audio numérique, vous utilisez l'AudioGridder FX ou le plugin d'instrument pour accéder à votre bibliothèque de plugins via le réseau. Le plugin recherche les serveurs disponibles sur votre réseau et, une fois connecté, vous permet de créer des chaînes d'insertion ou de charger des instruments. Les données midi et audio de votre logiciel de musique numérique seront diffusées en continu sur le réseau, traitées sur le serveur et retransmises en continu.

Pour contrôler un plugin et ajuster ses paramètres, AudioGridder capture l'interface utilisateur du plugin côté serveur et le diffuse en streaming vers le client. En même temps, il capture les événements de la souris et du clavier sur le client et les rejoue sur le serveur.

AudioGridder peut également prendre en charge un éditeur générique, qui permet d'accéder directement aux paramètres d'un plugin.

[ Dernière édition du message le 02/01/2021 à 06:24:05 ]

Eric Music Strasbourg

puisque le « PC serveur » devient un « logiciel hôte à plugins », ça implique que les licences/gestionnaires de licence (iLok License Manager/eLicenser, etc) doivent être installé sur ce PC. Conséquemment, pour les plugins ne permettant pas d’être installé sur plus d’un PC, faut faire un choix : installer sur le PC serveur ou sur le PC DAW~client (si l’on veut pouvoir les utiliser normalement, directement sur le PC où est notre DAW, comme à l’habitude).

C'est de toute façon la même chose avec vep. Les clés ilok ou elicenser doivent être sur l'ordinateur qui exécute le vsti... Donc aucun changement intéressant à ce niveau... Dommage ça aurait été bien plus pratique d'héberger les clés sur une seule machine...

En ce qui concerne la latence elle est la même que sur vep et dépend de la.machine hôte ( notre DAW). On peut choisir d'ajouter de un a quatre buffers pour laisser le temps de transmission des données. 4 buffers ça fait rêver c'est rien!

Après plus de souplesse je veux bien mais sur quoi? Que ce soit mixer modifier un plugin tout est possible avec vep. Du coup je ne vois pas quelle fonction pourrait on ajouter...

Pour moi le principe est le.meme que le vep et le résultat sans doute aussi sauf erreur de jeunesse si c'est un produit récent... Je n'ai pas vérifié.

Le gros reproche que l'on peut faire a vienna vsl c'est qu'il faut une clé ilok pour chaque pc plus une licence vep sur chaque pc ce qui est coûteux... Vienna offre une bank de son pour faire passe la pilule des 95 euros mais bon...

Autre point aucune possibilité de faire jouer la bank x installé sur deux ou trois pc. Seul le pc ayant la clé ilok bénéficie de la licence et de l'utilisation de la.bank en question...

Dit comme ça on se dit que ça n'est pas grave... Sauf que si parce que si tu épuises les ressources du pc slave numéro 1 ben t'as pas la licence sur le pc numéro 2!

.

Ceci oblige à bien calculer la conso moyenne que les.banks dont nous avons allons avoir besoin utilisent pour les dispatcher suivant la puissance de chaque pc...

Si c'est la solution que j'utilise aujourd'hui et qui est sans aucune mesure plus puissante qu'un seul pc où tout se trouve, je rêve tout de même du pc du futur ou tout serait intégré sans problème de puissance du cpu de mémoire d'espace disk .... Si ce dernier point n'est pas un réel problème la puissance cpu l'est bien.

Autre point si freudon n'avait pas été là pour le guider un peu sur le réseau j'attendrai encore pour faire de la musique. Une fois configuré ça paraît simple mais quand tu ne sais pas de quoi on parle tu es totalement noyé

Eric

[ Dernière édition du message le 02/01/2021 à 09:25:36 ]

madamereve

Pour la question mise en réseau, c'est certain que c'est pointu mais il faut bien démarrer comme nous l'avons fait avec l'audio.

J'ai fait un peu de serveur distant pour avoir accès constamment à mes données quand je bougeais. C'était assez drôle mais la machine doit être constamment branchée.

Je pense qu'il y a la documentation adéquate et des tutos. J'ai quelques notions sur les ip fixes et dynamiques et les dns.

Bonne année.

[ Dernière édition du message le 02/01/2021 à 09:49:10 ]

Eric Music Strasbourg

La gratuité est assez dingue... Il faut voir l'ensemble des compatibilités au, vst2, vst3....

Ce dont je peux témoigner à propos de vep c'est sa légèreté... Il.ne consomme.rien en cpu. La même bank de sons hyper energivore qui consomme 50% de barre de consommation sur cubase ne consomme quasiment rien sur vep (10%) maxi.... Ainsi sur mon pc.hote la limite cpu sur ce type de bank de sons est vite trouvée.

Sur les serveurs vep ça n'est pas le cas.

Sur la latence du vep avec 4 buffers il faut compter une milliseconde de plus à ajouter a la.latence du DAW suivant le.buffer de la carte son... En fait c'est moins qu'une interface midi branchée a un clavier maître...

Là où tu devras faire être attention c'est sur les exports... Si j'ai une session vep avec seulement un master left right l'ensemble du son et des.instrument.generes par ce pc sortira en stéréo.... Mais les instruents seront mélangés premixés par le mixeur du vep... (Une sommation comme un sous groupe).

On peut choisir d'avoir x.sorties stéréo pour sortir chaque instrument de façon indépendante a savoir un instrument une piste stéréo . L'intérêt lors de l'export en audio est d'avoir chaque piste séparée et donc de mixer en post production comme on le souhaite...

Si cette solution est la plus flexible elle est aussi forcément la plus lourde... La quantité de données qui transitent est démultipliée.

Ceci a une conséquence sur le choix des câbles.rj45. il ne faut alors selon moi pas.descendre en dessous de la catégorie 7. N'y connaissant rien je ne l'ai pas.fait au départ et j'ai pris du RJ45 que je qualifierait de.standard... c'est le glitsch assuré très rapidement alors que le cpu va très bien...

La limite se trouve alors dans les cartes RJ45 et les câbles...

En catégorie 7 je n'ai jamais réussi a saturer le système ni côté DAW ni côté slave...

Ce type de.systeme.implique une rigueur matériel à tout les.etages mais ça vaut le coup !

Eric

[ Dernière édition du message le 02/01/2021 à 10:41:53 ]

Eric Music Strasbourg

Avoir l'interface du plugin éditable dans le.daw directement est un avantage certain.

Sur vep les.reglages sont sauvegardés dans le DAW mais l'édition ne se fait que sur chaque serveur!!!

La différence est la suivante. J'ai 4 ordi dont 3 en esclaves vep j'ai donc 4 souris!!!

On peut bien-sûr mettre un sélecteur de souris clavier qui bascule d'un pc à l'autre j'ai fini par le faire pour partager écran souris clavier sur deux des ordinateurs mais ça ne vaut pas. un système virtuel ou le gui apparaît dans le daw!

Dernier point si vep.peut.mixer en.7.1 qu'en est il de audio gridder ?

En tous cas si audio.gridder commence à offrir dans le.futur.ded reverb à .convolution façon vienna vep aura du souci à se faire.

Eric

[ Dernière édition du message le 02/01/2021 à 10:52:04 ]

- < Liste des sujets

- Charte