réactions à la news Le premier synthé codé par une IA de l'Histoire ?

- 121 réponses

- 21 participants

- 5 511 vues

- 19 followers

Neo Alchemist

10019

Administrateur·trice du site

Membre depuis 5 ans

Sujet de la discussion Posté le 02/03/2023 à 09:56:00Le premier synthé codé par une IA de l'Histoire ?

Il semblerait que oui. En tout cas c'est ce qu'annonce le youtubeur Doctor Mix, qui a collaboré avec un outil d'un nouveau genre.

Lire la news

Ce thread a été créé automatiquement suite à la publication d'une news pour ce produit. N'hésitez pas à poster vos commentaires ici !

Lire la news

Ce thread a été créé automatiquement suite à la publication d'une news pour ce produit. N'hésitez pas à poster vos commentaires ici !

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

76 Posté le 08/03/2023 à 10:23:05

Citation de GBo :

Citation de 8oris :Ah? Moi, ça fonctionne parfaitement:

[...]

Ca doit dépendre de qui demande alors, je dois manquer de tact avec les machines, ou alors c'est le "as a system administrator" qui change tout ?

Voilà, ce sera la découverte du jour: quand on utilise mal un outil, il donne de mauvais résultat.

Un agent conversationnel, avant de lui poser n'importe quelle question, on l'instruit, on lui donne un contexte et une fois que c'est fait, on commence à lui parler.

C'est vraiment symptomatique de ce thread: une foule de gens qui critiquent un outil, pointent ses faiblesses (techniques, ethiques) alors qu'ils ne savent ni comment il fonctionne (paradigme, techno utilisée) et pas plus comment s'en servir correctement. L'outil est présenté comme un proto, une version beta et les gens ont une curiosité qui ne dépasse pas celle d'un article lu dans un média aussi peu renseigné qu'eux et sont les premiers à dire des trucs du style: "Ca ne fonctionne pas, ça dit de la merde et regardez, j'ai réussi à le piéger". "Qui fait le malin, tombe dans le ravin" comme on dit!

Et on s'étonne que la France soit à la traine technologiquement, qu'elle réinvente la roue en bois pour faire de la F1...Tout ça me rappelle, allez en vrac: la norme télévisée française, le minitel ou plus récemment Salto et la lettre électronique de la Poste...Ou quand "vive la science" ne rime pas avec "Vive la france".

1

[ Dernière édition du message le 08/03/2023 à 10:23:52 ]

GBo

52

Posteur·euse AFfranchi·e

Membre depuis 23 ans

77 Posté le 08/03/2023 à 10:53:56

8oris, j'avais posé la question correctement, la preuve qu'"il" l'a parfaitement comprise, c'est qu'"il" a commencé à écrire le script bash comme il faut par le célèbre #!/bin/bash, je ne le lui ai pas soufflé, et il n'y avait rien de piégeux, la bonne réponse est partout sur le web. Mais tu as raison, c'est nous les buses, cet outil est parfait entre tes mains expertes, la France elle a besoin de toi.

0

[ Dernière édition du message le 08/03/2023 à 11:02:56 ]

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

78 Posté le 08/03/2023 à 16:13:15

Citation de GBo :

8oris, j'avais posé la question correctement,

Assurément pas vu ton utilisation du facepalm pour qualifier la réponse obtenue.

Citation de GBo :

la preuve qu'"il" l'a parfaitement comprise, c'est qu'"il" a commencé à écrire le script bash comme il faut par le célèbre #!/bin/bash, je ne le lui ai pas soufflé, et il n'y avait rien de piégeux, la bonne réponse est partout sur le web.

Il a répondu inexactement à une question posée inexactement. Pour toi, il n'y avait rien de piégeux mais l'inexactitude de ta question, son absence de contexte, l'a rendue piégeuse. C'est ça qui "m'énerve" : les utilisateurs qui reprochent à cet outil de remplacer l'humain et donc lui parlent comme à un humain alors que c'est une machine et qu'il faut lui parler comme à une machine. L'approche est biaisé dès le début.

Citation de GBo :

Mais tu as raison, c'est nous les buses,

Bah, désolé mais dans 90% des cas, quand un applicatif logiciel ne fonctionne pas, le problème se situe entre la chaise et le clavier.

Dans le cas des agents conversationnels, il y a un gros biais de la part des utilisateurs à qui on a présenté cet outil comme une espèce de machine magique qui comprend parfaitement les questions et y répond parfaitement alors que...non.

La MAO et l'informatique réponde à une seule règle, un dogme même: "Shit In, Shit Out".

Citation de GBo :

cet outil est parfait entre tes mains expertes

Je n'ai jamais dit qu'il était parfait, je n'ai jamais dit que j'étais un expert, je dis simplement que:

- c'est un outil d'assistance à la production, pas un outil de production.

- c'est un outil et à ce titre, son usage suppose un apprentissage de la part de l'utilisateur et un peu de pragmatisme dans l'utilisation des résultats.

Citation de GBo :

la France elle a besoin de toi.

Fort heureusement: non.

3

[ Dernière édition du message le 08/03/2023 à 16:13:40 ]

Billybilly

662

Posteur·euse AFfolé·e

Membre depuis 11 ans

79 Posté le 08/03/2023 à 16:21:42

Je comprends pas clairement ton point de vue 8oris.

Pour toi, tous les exemples de réponses erronées de ChatGPT qui abondent autant dans les posts que dans les vidéos, podcasts et articles cités viendraient en fait à chaque fois uniquement de la demande de l'utilisateur qui ne serait pas formé correctement à formuler une demande ? Et donc que dans l'absolu, ChatGPT serait toujours dans le juste tant qu'on sait lui poser une question ?

Pour toi, tous les exemples de réponses erronées de ChatGPT qui abondent autant dans les posts que dans les vidéos, podcasts et articles cités viendraient en fait à chaque fois uniquement de la demande de l'utilisateur qui ne serait pas formé correctement à formuler une demande ? Et donc que dans l'absolu, ChatGPT serait toujours dans le juste tant qu'on sait lui poser une question ?

1

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

80 Posté le 08/03/2023 à 18:56:53

Citation de Billybilly :

Je comprends pas clairement ton point de vue 8oris.

Pour toi, tous les exemples de réponses erronées de ChatGPT qui abondent autant dans les posts que dans les vidéos, podcasts et articles cités viendraient en fait à chaque fois uniquement de la demande de l'utilisateur qui ne serait pas formé correctement à formuler une demande ?

Non, je ne dis pas que ChatGPT échoue uniquement parce que les questions sont mal posés mais les cas qui abondent, comme on en trouve par exemple ici, sont souvent des corner-cases, des cas limites de l'IA.

Comme à ses débuts, certains lui posaient des questions dont la bonne réponse était hors du cadre temporel de l'IA donc forcément qu'elle se plantait. C'est un peu comme si on cherchait un mot allemand dans le dictionnaire français et qu'on pesterait qu'il n'y soit pas.

Sur un usage "pour lequel il est prévu" (i.e pour lequel il est entraîné, programmé) et utilisé comme il se doit, il fonctionne globalement très bien.

Et pour revenir au sujet, ChatGPT n'est pas un développeur, ce n'est pas non plus un IDE, c'est un agent conversationnel donc pas étonnant qu'il développe mal.

Citation de Billybilly :

Et donc que dans l'absolu, ChatGPT serait toujours dans le juste tant qu'on sait lui poser une question ?

Oui, une question pour laquelle il a été entraîné suffisamment pour donner une réponse correcte et ce aux corner cases près...

2

alex.d.

5912

Je poste, donc je suis

Membre depuis 10 ans

81 Posté le 08/03/2023 à 19:07:03

Citation de 8oris :

C'est un peu comme si on cherchait un mot allemand dans le dictionnaire français et qu'on pesterait qu'il n'y soit pas.

Non, quand tu cherche un mot allemand dans un dictionnaire français, le dictionnaire te dit qu'il ne connaît pas ce mot. Alors que ChatGPT, il ne sait pas dire qu'il ne sait pas ; il invente toujours une réponse qui lui semble plausible.

2

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

82 Posté le 08/03/2023 à 19:21:46

Ca, c'est tout à fait vrai.

0

Billybilly

662

Posteur·euse AFfolé·e

Membre depuis 11 ans

83 Posté le 08/03/2023 à 19:22:00

Citation de 8oris :

Citation de Billybilly :Et donc que dans l'absolu, ChatGPT serait toujours dans le juste tant qu'on sait lui poser une question ?

Oui, une question pour laquelle il a été entraîné suffisamment pour donner une réponse correcte et ce aux corner cases près...

C'est là où on est pas d'accord. Dans les deux vidéos de Monsieur Phi que j'ai postées en tout début de ce fil de commentaires, ChatGPT sort des trucs absurdes sur des questions très simples et bien renseignées (le requin qui est un mammifère, Descartes qui voyage beaucoup en Amérique du Sud, etc...).

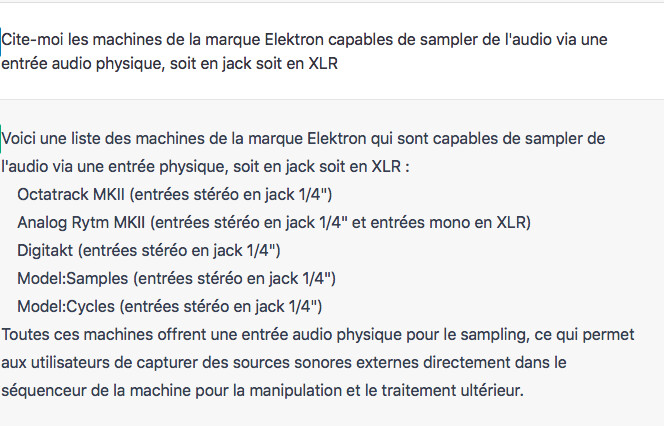

Tout à l'heure, j'ai refait ma petite expérience de demander simplement une liste de matériel étant en mesure de sampler.

J'ai pas l'impression d'avoir formulé ma question de manière particulièrement ambigu mais en tout cas la réponse est non seulement à 50% fausse (non les models n'ont pas d'entrée audio physique) mais le pire c'est qu'il invente des caractéristiques mélangées à du vrai, notamment sur l'Analog Rytm MKII et ses entrées mono en XLR.

0

[ Dernière édition du message le 08/03/2023 à 19:23:12 ]

Will Zégal

78712

Will Zégal

Membre depuis 23 ans

84 Posté le 08/03/2023 à 20:23:29

Reste donc à avoir la liste des questions pour lesquelles il a été entraîné.

2

deb76

3841

Squatteur·euse d’AF

Membre depuis 21 ans

85 Posté le 08/03/2023 à 21:49:25

Ce que j'ai constaté, après avoir demandé à ChatGPT comment créer une série dodécaphonique aléatoire avec Open Music de l'Ircam et Opusmodus (soit tout simplement une série arithmétique pour créer la gamme chromatique puis une permutation aléatoire pour créer les 12 notes de la série aléatoire en Common Lisp) et dans Max de Cycling 74 de créer une ring modulation : Dans la formulation de ses réponses, au niveau de la formalisation des processus, ChatGPT a apporté des réponses qui se tiennent et en proposant différentes options, notamment pour la série aléatoire soit à partir des hauteurs, mais aussi des fréquences Hz ou à partir des classes de hauteurs modulo 12. Pour la ring modulation créée avec Max, les objets qu'il suggérait étaient exacts. En revanche, pour les exemples de code pour la série dodécaphonique aléatoire il a proposé des fonctions issues d'autres programmes comme le Visual Basic, Python ou Ruby pour ne citer qu'eux. Pour le code pour créer une ring modulation avec Max il a proposé un fichier texte - ce qui est la procédure typique pour exporter un patch Max - qui ne fonctionne pas même malgré la correction des balises d'entrées et de sorties. Bref, généralement, à partir de mes questions, il analyse bien ce que je lui demande, propose un descriptif correct de ce qu'il faut faire mais par contre il se plante totalement dans ses exemples.

0

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

86 Posté le 08/03/2023 à 22:49:42

Pour l'histoire du requin (ou le fail "fastest marine mammal"), c'est un problème d'entraînement ou plutôt une de ces limites.

ChatGPT se base beaucoup sur des jeux de données non vérifiées et il est en PLS sur tout ce qui concerne la classification étant donné que ce sont des domaines sur lesquelles il y a beaucoup de confusions, de fausses idées, de fausses idées généralement acceptées. Certaines personnes disent que les tomates sont des fruits, d'autres des légumes.

Ca pointe là une grosse limite : qui valide (et comment) le jeu de données utilisés pour l'entraînement?

Il y a aussi la problématique des faux syllogismes (l’ornithorynque a un bec, le canard a un bec donc l'ornithorynque est un canard) et je ne sais pas du tout comment c'est géré.

ChatGPT se base beaucoup sur des jeux de données non vérifiées et il est en PLS sur tout ce qui concerne la classification étant donné que ce sont des domaines sur lesquelles il y a beaucoup de confusions, de fausses idées, de fausses idées généralement acceptées. Certaines personnes disent que les tomates sont des fruits, d'autres des légumes.

Ca pointe là une grosse limite : qui valide (et comment) le jeu de données utilisés pour l'entraînement?

Il y a aussi la problématique des faux syllogismes (l’ornithorynque a un bec, le canard a un bec donc l'ornithorynque est un canard) et je ne sais pas du tout comment c'est géré.

0

alex.d.

5912

Je poste, donc je suis

Membre depuis 10 ans

87 Posté le 08/03/2023 à 23:33:32

Bien sûr, ce n'est qu'un problème d'entraînement, il n'hallucine jamais.

À l'instant, il m'a sorti ceci :

La consommation d'oeufs de cheval n'est pas illégale dans la plupart des pays, mais elle peut ne pas être courante dans certaines cultures alimentaires.

Cependant, il y a quelques exceptions. Par exemple, la vente et la consommation d'oeufs de cheval ont été interdites en France depuis 1993 en raison du risque de transmission de maladies animales à l'homme. En Suisse, la consommation d'oeufs de cheval a été interdite en 2013 pour des raisons similaires.

Il convient de noter que la réglementation sur la consommation d'oeufs de cheval peut varier en fonction des lois et des règlements locaux de chaque pays. Il est donc important de vérifier les lois et les règles en vigueur dans votre pays avant de consommer des oeufs de cheval.

Il n'a pas su me donner ses sources, mais il a l'air drôlement bien renseigné.

Ah, et à la coque, l'oeuf de cheval c'est 4 minutes de cuisson, mais si ça vient d'un gros cheval, on peut aller jusque 6 minutes (merci ChatGPT pour tes bonnes recettes).

À l'instant, il m'a sorti ceci :

La consommation d'oeufs de cheval n'est pas illégale dans la plupart des pays, mais elle peut ne pas être courante dans certaines cultures alimentaires.

Cependant, il y a quelques exceptions. Par exemple, la vente et la consommation d'oeufs de cheval ont été interdites en France depuis 1993 en raison du risque de transmission de maladies animales à l'homme. En Suisse, la consommation d'oeufs de cheval a été interdite en 2013 pour des raisons similaires.

Il convient de noter que la réglementation sur la consommation d'oeufs de cheval peut varier en fonction des lois et des règlements locaux de chaque pays. Il est donc important de vérifier les lois et les règles en vigueur dans votre pays avant de consommer des oeufs de cheval.

Il n'a pas su me donner ses sources, mais il a l'air drôlement bien renseigné.

Ah, et à la coque, l'oeuf de cheval c'est 4 minutes de cuisson, mais si ça vient d'un gros cheval, on peut aller jusque 6 minutes (merci ChatGPT pour tes bonnes recettes).

4

[ Dernière édition du message le 08/03/2023 à 23:38:49 ]

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

88 Posté le 08/03/2023 à 23:52:05

C'est ouf! :D

0

alex.d.

5912

Je poste, donc je suis

Membre depuis 10 ans

89 Posté le 09/03/2023 à 00:00:13

J'ai poussé le vice un peu plus loin. J'ai demandé une recette à base d'oeufs de cochons :

Les oeufs de cochon, également appelés "oeufs de porc", sont souvent utilisés en cuisine dans différentes cultures du monde. Voici une recette simple qui met en valeur les saveurs riches et salées de ces oeufs:

Omelette aux oeufs de cochon

Ingrédients:

4 oeufs de cochon

1 petit oignon haché finement

1 petite gousse d'ail hachée finement

1 petite tomate hachée finement

2 cuillères à soupe d'huile d'olive

Sel et poivre noir moulu

(...)

peut-on mettre des oeufs de vache à la place ?

Il n'est pas recommandé de remplacer les oeufs de cochon par des oeufs de vache dans cette recette, car les deux types d'oeufs ont des textures, des saveurs et des propriétés nutritionnelles différentes.

Les oeufs de vache sont plus couramment utilisés en cuisine et ont une texture et une saveur plus douces que les oeufs de cochon, qui sont plus riches et plus salés. Les oeufs de vache sont également plus liquides que les oeufs de cochon, ce qui peut affecter la texture de l'omelette.

Si vous ne pouvez pas trouver des oeufs de cochon, vous pouvez utiliser des oeufs de caille, qui ont une saveur et une texture similaires. Si vous ne pouvez pas trouver de substitut, vous pouvez toujours préparer une omelette classique avec des oeufs de poule, en ajustant les temps de cuisson en conséquence.

Toujours convaincu que les approximations ne viennent que de l'imperfection des sources ? Parce que moi, franchement, je veux bien voir la source où il a vu que les oeufs de vache sont plus liquides que les oeufs de cochon.

Mais non : ChatGPT est, par nature, un bullshiteur. Il cherche à faire illusion en trouvant une réponse qui pourra faire illusion, c'est tout.

Les oeufs de cochon, également appelés "oeufs de porc", sont souvent utilisés en cuisine dans différentes cultures du monde. Voici une recette simple qui met en valeur les saveurs riches et salées de ces oeufs:

Omelette aux oeufs de cochon

Ingrédients:

4 oeufs de cochon

1 petit oignon haché finement

1 petite gousse d'ail hachée finement

1 petite tomate hachée finement

2 cuillères à soupe d'huile d'olive

Sel et poivre noir moulu

(...)

peut-on mettre des oeufs de vache à la place ?

Il n'est pas recommandé de remplacer les oeufs de cochon par des oeufs de vache dans cette recette, car les deux types d'oeufs ont des textures, des saveurs et des propriétés nutritionnelles différentes.

Les oeufs de vache sont plus couramment utilisés en cuisine et ont une texture et une saveur plus douces que les oeufs de cochon, qui sont plus riches et plus salés. Les oeufs de vache sont également plus liquides que les oeufs de cochon, ce qui peut affecter la texture de l'omelette.

Si vous ne pouvez pas trouver des oeufs de cochon, vous pouvez utiliser des oeufs de caille, qui ont une saveur et une texture similaires. Si vous ne pouvez pas trouver de substitut, vous pouvez toujours préparer une omelette classique avec des oeufs de poule, en ajustant les temps de cuisson en conséquence.

Toujours convaincu que les approximations ne viennent que de l'imperfection des sources ? Parce que moi, franchement, je veux bien voir la source où il a vu que les oeufs de vache sont plus liquides que les oeufs de cochon.

Mais non : ChatGPT est, par nature, un bullshiteur. Il cherche à faire illusion en trouvant une réponse qui pourra faire illusion, c'est tout.

4

deb76

3841

Squatteur·euse d’AF

Membre depuis 21 ans

90 Posté le 09/03/2023 à 01:20:37

Ah, les oeufs de cheval... Je viens de découvrir, merci alex.d. j'ai bien ri !!!

0

Will Zégal

78712

Will Zégal

Membre depuis 23 ans

91 Posté le 09/03/2023 à 01:37:03

Excellent.

1

[ Dernière édition du message le 09/03/2023 à 01:40:09 ]

Billybilly

662

Posteur·euse AFfolé·e

Membre depuis 11 ans

92 Posté le 09/03/2023 à 08:26:06

Citation de Will Zégal :

Reste donc à avoir la liste des questions pour lesquelles il a été entraîné.

Mais justement, à partir du moment où on devrait se renseigner sur ce à quoi il peut répondre avant de lui poser une question sachant que ce n'est indiqué nulle part précisément, c'est qu'il y a un énorme problème. Surtout que ChatGPT répond parfois qu'il n'est pas en mesure de répondre ou bien va s'interdire de le faire en invoquant des principes moraux et de neutralité tout en dissertant (délirant) sur les oeufs de cheval.

Et désolé mais la question du requin qui est un mammifère ou un poisson, ce n'est pas un vaste débat qui secoue la communauté scientifique depuis des dizaines d'années

1

Will Zégal

78712

Will Zégal

Membre depuis 23 ans

93 Posté le 09/03/2023 à 08:42:09

Ma phrase était ironique.

Savoir sur quoi il peut répondre, ça voudrait dire un base de données. Laquelle serait tellement grosse qu'il faudrait... un moteur de recherche. Un peu paradoxal.

Ou la solution serait que chatGPT dise lui-même sur quoi il est fiable. Sauf que comme le montre la vidéo de Mr Phi que j'ai postée, ça n'est pas son propos et ça ne serait peut-être même pas techniquement possible dans l'approche technique de sa conception.

Je pense que l'erreur commune de chatGPT est de le prendre pour une intelligence artificielle ou un super moteur de recherche qui rend des résultat en langage courant (fut-ce du code). Sauf que c'est pas ça.

Déjà, l'appellation d'intelligence artificielle est décidément très trompeuse alors qu'il s'agit de machine learning.

Mais c'est fondamentalement un agent conversationnel. Son but est de produire des textes plausibles et cohérents, pas exacts.

Savoir sur quoi il peut répondre, ça voudrait dire un base de données. Laquelle serait tellement grosse qu'il faudrait... un moteur de recherche. Un peu paradoxal.

Ou la solution serait que chatGPT dise lui-même sur quoi il est fiable. Sauf que comme le montre la vidéo de Mr Phi que j'ai postée, ça n'est pas son propos et ça ne serait peut-être même pas techniquement possible dans l'approche technique de sa conception.

Je pense que l'erreur commune de chatGPT est de le prendre pour une intelligence artificielle ou un super moteur de recherche qui rend des résultat en langage courant (fut-ce du code). Sauf que c'est pas ça.

Déjà, l'appellation d'intelligence artificielle est décidément très trompeuse alors qu'il s'agit de machine learning.

Mais c'est fondamentalement un agent conversationnel. Son but est de produire des textes plausibles et cohérents, pas exacts.

3

Billybilly

662

Posteur·euse AFfolé·e

Membre depuis 11 ans

94 Posté le 09/03/2023 à 10:27:23

Citation de Will Zégal :

Ma phrase était ironique.

Savoir sur quoi il peut répondre, ça voudrait dire un base de données. Laquelle serait tellement grosse qu'il faudrait... un moteur de recherche. Un peu paradoxal.

Ou la solution serait que chatGPT dise lui-même sur quoi il est fiable. Sauf que comme le montre la vidéo de Mr Phi que j'ai postée, ça n'est pas son propos et ça ne serait peut-être même pas techniquement possible dans l'approche technique de sa conception.

Je pense que l'erreur commune de chatGPT est de le prendre pour une intelligence artificielle ou un super moteur de recherche qui rend des résultat en langage courant (fut-ce du code). Sauf que c'est pas ça.

Déjà, l'appellation d'intelligence artificielle est décidément très trompeuse alors qu'il s'agit de machine learning.

Mais c'est fondamentalement un agent conversationnel. Son but est de produire des textes plausibles et cohérents, pas exacts.

Will, je répondais plutôt à 8oris qui pour le coup tient la position que ChatGPT dit la vérité dans l'absolu et que les réponses érronées viendraient de l'utilisateur incapable de formuler correctement une question. (et sinon merci pour le résumé de la vidéo de monsieur phi mais j'ai posté ses deux vidéos consacrées au sujet sur la première page du fil de discussion...)

1

Will Zégal

78712

Will Zégal

Membre depuis 23 ans

95 Posté le 09/03/2023 à 10:28:18

Oups !

Mais elle était plutôt destinée aussi à 8oris et aux gens qui font un peu trop confiance dans le chatGPT actuel.

On peut lui faire confiance dans une certaine mesure, mais sur ce pour quoi il est fait : générer du texte. Pas apporter des réponses.

Mais elle était plutôt destinée aussi à 8oris et aux gens qui font un peu trop confiance dans le chatGPT actuel.

On peut lui faire confiance dans une certaine mesure, mais sur ce pour quoi il est fait : générer du texte. Pas apporter des réponses.

2

[ Dernière édition du message le 09/03/2023 à 10:29:48 ]

deb76

3841

Squatteur·euse d’AF

Membre depuis 21 ans

96 Posté le 09/03/2023 à 11:34:39

Citation de Will Zégal :

Oups !

Mais elle était plutôt destinée aussi à 8oris et aux gens qui font un peu trop confiance dans le chatGPT actuel.

On peut lui faire confiance dans une certaine mesure, mais sur ce pour quoi il est fait : générer du texte. Pas apporter des réponses.

Oui, c'est ça, il est fait pour générer du texte. Et il n'apprend pas en temps réel, ce que Chat GPT m'avait précisé : "Je suis désolé pour la confusion. En effet, en tant que modèle de langage, je ne peux pas apprendre de nouvelles compétences en temps réel, mais plutôt utiliser les connaissances que j'ai acquises pendant mon entraînement pour répondre aux questions."

1

Frajean

3154

Squatteur·euse d’AF

Membre depuis 11 ans

97 Posté le 09/03/2023 à 14:47:11

Non, mais si ChatGPT répond qu'on peut aussi faire une omelette avec des oeufs de poule, c'est qu'il a parfois un peu raison. En attendant, je m'en vais poser mes questions cuisine sur Marmiton, ce sera plus sûr

2

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

98 Posté le 09/03/2023 à 18:02:08

Bon, vos exemples démontrent sans conteste que Chatgpt peut faire/dire n'importe quoi. Mais toujours pareil, pour la recette aux oeufs de cochon, je suis désolé mais les "oeufs de cochon" existent. Une simple recherche dans Google le prouve. Alors, évidemment, ce ne sont pas de véritables oeufs de cochon mais une préparation d'oeufs pour les faire ressembler à des cochons.

Du coup, ils ont effectivement une texture différente de celle des oeufs de poule et des qualités nutritionnelles différentes aussi. vous savez que ce ne sont pas des oeufs (au sens ovule animal) parce que vous avez une capacité très difficile à implémenter dans une machine qui s'appelle l'inférence. Quand on vous dit qu'il pleut des cordes ,vous savez qu'il ne pleut pas littéralement des cordes (bon, sauf si vous êtes à Orléans), pour une machine la corde est un objet avec un sens, pleuvoir est une action avec un sens, l'association des deux termes associé leur sens, peu importante la concordance.

Autre problématique des agents coversationnels: les entités nommées. Je ne m'étends pas sur le sujet mais ceux qui se sont frottés au TAL savent de quoi je parle.

Donc, effectivement, Chatgpt peut dire n'importe quoi mais si on prend suffisamment de recul, on peut aisément comprendre pourquoi et donc l'orienter mieux pour qu'il réponse mieux. Dans le coup de la recette, il aurait été intéressant de lui demander ce qu'est un oeuf de cochon.

Pour les œufs de cheval, je n'ai pas chercher mais sachant que "oeuf de cheval" est corrigé automatiquement par Google en "oeuf à Cheval", c'est une piste.

Dans mon cas perso (je suis un genre de développeur), il m'a souvent aidé à trouver des solutions de manière bien plus efficace qu'un moteur de recherche et qui fonctionnaient parfaitement. Je travaille dans une équipe de doctorants en informatique qui l'utilisent aussi pour ce faire. Pour coder certaines "routines" basiques mais non triviales from scratch, et dont on a besoin en one shot, c'est un outil vraiment satisfaisant notamment parce qu'il a la capacité d'adapter ses réponses.

Exemple: j'avais besoin d'un navigateur headless en python capable de gérer des add-ons. Une solution aurait été d'utiliser Sélénium, c'est une bouse intergalactique mais très utilisée. Chatgpt m'a évidemment fait une réponse en me le conseillant, je lui ai demandé d'utiliser une autre solution et il m'a trouvé un autre module (playwright) bien moins connu, bien moins documenté aussi... J'ai gagné 1 semaine de temps de recherche, de lecture de doc, de galères de debuggage, de prise de tête sur STO bref le rêve. Après, la question était très normée, balisée, déterministe, idéale pour une machine. Dans ce cas là, il est très efficace...

Du coup, ils ont effectivement une texture différente de celle des oeufs de poule et des qualités nutritionnelles différentes aussi. vous savez que ce ne sont pas des oeufs (au sens ovule animal) parce que vous avez une capacité très difficile à implémenter dans une machine qui s'appelle l'inférence. Quand on vous dit qu'il pleut des cordes ,vous savez qu'il ne pleut pas littéralement des cordes (bon, sauf si vous êtes à Orléans), pour une machine la corde est un objet avec un sens, pleuvoir est une action avec un sens, l'association des deux termes associé leur sens, peu importante la concordance.

Autre problématique des agents coversationnels: les entités nommées. Je ne m'étends pas sur le sujet mais ceux qui se sont frottés au TAL savent de quoi je parle.

Donc, effectivement, Chatgpt peut dire n'importe quoi mais si on prend suffisamment de recul, on peut aisément comprendre pourquoi et donc l'orienter mieux pour qu'il réponse mieux. Dans le coup de la recette, il aurait été intéressant de lui demander ce qu'est un oeuf de cochon.

Pour les œufs de cheval, je n'ai pas chercher mais sachant que "oeuf de cheval" est corrigé automatiquement par Google en "oeuf à Cheval", c'est une piste.

Dans mon cas perso (je suis un genre de développeur), il m'a souvent aidé à trouver des solutions de manière bien plus efficace qu'un moteur de recherche et qui fonctionnaient parfaitement. Je travaille dans une équipe de doctorants en informatique qui l'utilisent aussi pour ce faire. Pour coder certaines "routines" basiques mais non triviales from scratch, et dont on a besoin en one shot, c'est un outil vraiment satisfaisant notamment parce qu'il a la capacité d'adapter ses réponses.

Exemple: j'avais besoin d'un navigateur headless en python capable de gérer des add-ons. Une solution aurait été d'utiliser Sélénium, c'est une bouse intergalactique mais très utilisée. Chatgpt m'a évidemment fait une réponse en me le conseillant, je lui ai demandé d'utiliser une autre solution et il m'a trouvé un autre module (playwright) bien moins connu, bien moins documenté aussi... J'ai gagné 1 semaine de temps de recherche, de lecture de doc, de galères de debuggage, de prise de tête sur STO bref le rêve. Après, la question était très normée, balisée, déterministe, idéale pour une machine. Dans ce cas là, il est très efficace...

3

Billybilly

662

Posteur·euse AFfolé·e

Membre depuis 11 ans

99 Posté le 09/03/2023 à 18:14:37

Ok, je comprends bien ton point de vue. C'est ce qui est développé aussi dans la vidéo de Defekator (que j'ai postée un peu plus haut dans le fil), à savoir qu'il faut faire des demandes très précises, très contextualisées pour espérer obtenir quelque chose de pertinent ou exploitable. Mais ça signifie quand même qu'on doit toujours avoir une longueur d'avance sur la machine, ou en tout cas avoir une idée très précise de ce qu'on recherche et que ce n'est vraiment définitivement pas un wikipedia avec interface de langage. Ce que j'en retiens, c'est que là où il peut être le plus intéressant, c'est dans la recherche de procédures (qu'il faudra évidemment vérifier derrière) mais que c'est très bancal dans la recherche de données brutes.

1

8oris

5660

Je poste, donc je suis

Membre depuis 22 ans

100 Posté le 09/03/2023 à 18:38:31

C'est ça ! Et d'ailleurs,c'est très bien d'avoir besoin d'un temps d'avance sur la machine, cela permet de garder la main dessus.

0

- < Liste des sujets

- Charte