réactions au dossier [Bien débuter] Qu'est-ce que la phase en audio ?

- 90 réponses

- 25 participants

- 6 231 vues

- 33 followers

Los Teignos

Lire l'article

Ce thread a été créé automatiquement suite à la publication d'un article. N'hésitez pas à poster vos commentaires ici !

__________________________________________________________________________________

Le GIEC chiffre à 3,3 milliards le nombre de victimes du réchauffement climatique. On en parle ?

Dr Pouet

Deux micros captant une même source à deux distances différentes, cela provoque en théorie un décalage de phase sur la partie son direct.

N'est-il pas plus juste de parler de décalage temporel ?

Et d'ailleurs, si la différence de distance vaut D, ça vaudra D / 340 (m/s).

Déjà, la partie différence d'intensité n'a rien à voir avec la phase. Et c'est pourtant ce que font tous les mixeurs lorsqu'ils manipulent un pan-pot.

Oui. Un pan-pot (potentiomètre panoramique) d'une table de mixage c'est 2 gains différents, liés l'un à l'autre. Du coup, c'est une stéréo assez artificielle et simpliste. Ça fonctionne pas trop mal. Mais quand on écoute un vrai enregistrement acoustique avec par exemple une paire de micros omnis, et bien dans ce cas on se rend compte que la spatialisation du son est bien plus réaliste.

Anonyme

Un différence de phase ne peut être réduite à un retard que dans le cas d'un signal périodique, ce que la musique n'est pas.

Même pour de la musique en boucle ?

Wolfen

Imaginons deux fichiers WAV mono. En gros la corrélation c’est à quel points ces deux sources audio ont quelque chose en commun du point de vue du traitement du signal. Si on prend un fichier audio et qu’on en fait une copie, les deux fichiers obtenus auront une corrélation parfaite. Si on en décale un des deux dans le temps par rapport a l’autre, cette corrélation sera toujours là mais amoindrie avec la longueur du décalage. Si on enregistre deux fois la même partie de guitare dans deux fichiers audio, ces deux résultats ne sont pas corrélés du tout. Si on repique un instrument avec deux micros a partir de la mëme interprétation, on obtient deux signaux un peu corrélés aussi.

Pourquoi je parle de ca ? Et bien le truc c’est que quand on mixe deux signaux corrélés, ca créé un résultat dans lequel on entend ces fameux problèmes de phase. De même, si vous avec un enregistrement stéréo, dans lequel la piste gauche et la piste droite ont un peu de corrélation, le mix mono va présenter aussi ces problèmes.

Du coup dans le contexte du mix on essaie de faire en sorte d’éviter au max la corrélation entre les pistes (par exemple en jouant deux fois la même partie plutot qu’en copiant une prise partout a l’identique). Sinon on cherche à la compenser, en alignant les sons pour réduire le nombre d’annulations, en écoutant avec ou sans inversion de phase ce qui a l’air d’être le moins pire, en utilisant des outils de rotation de phase, ou en utilisant des filtres a phase linéaire pour compenser exactement avec la compensation automatique de latence le bordel que le filtre peut mettre dans la phase...

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

nii

Citation :Gloire à la phase ! Non à l'antiphase !

BBmiX

Un différence de phase ne peut être réduite à un retard que dans le cas d'un signal périodique, ce que la musique n'est pas.

Comme tu dis la musique n'est pas un signal périodique constant , on ne compose pas du bruit blanc ou rose , ça deviendrait monotone

Je sens qu'on a pas finis de discuter la dessus !!! je n'est pas la science infuse ,je doute aussi

Je parlais de sémantique ( l'emploi des mots ) et du contexte ou ils sont employés .

On devrait parler DES phases , car une phase seule , elle , elle s'en fiche , elle est en phase avec elle même

( corrélation ; co = 2 )

Donc dés qu'on amène une autre phase avec celle ci , que ce soit la même ( décalée en temps ou en intensité ) une autre (c'est à dire la même avec effet, eq ou filtre par exemple ) , là on à un phénomène qui change le son .

( et là je parle d'une seule ( mono ) , ça tord encore plus le cerveau si on parle de stéréo , et encore plus en prise de son ( vitesse do son IRL )

...

...Au delà de tes arguments très juste , jan , je pense qu'il faut retenir également:

Au niveau de ce qu'on doit savoir lorsqu'on mixe en stéréo bi-canal sur deux enceintes, c'est suffisant. Mais en fait, la restitution du relief met en cause des notions plus étendues que ces seuls deux critères

Je pense que c'est très important de comprendre et de noter que le problème de phase ne vient pas juste du fait que les deux signaux soient ou parfaitement en phase ou complètement hors phase avec une inversion de polarité. Il y a aussi les états intermédiaires qui vont créer des atténuations du signal, et ce sur la totalité des fréquences ou seulement à certaines, à différents degrés, ce qui va créer tout un bordel potentiel divers et variés

Du coup dans le contexte du mix on essaie de faire en sorte d’éviter au max la corrélation entre les pistes (par exemple en jouant deux fois la même partie plutot qu’en copiant une prise partout a l’identique). Sinon on cherche à la compenser, en alignant les sons pour réduire le nombre d’annulations, en écoutant avec ou sans inversion de phase ce qui a l’air d’être le moins pire, en utilisant des outils de rotation de phase, ou en utilisant des filtres a phase linéaire pour compenser exactement avec la compensation automatique de latence le bordel que le filtre peut mettre dans la phase

Justement : parfaitement en phase, ou déphasé, ce sont des cas particuliers, indépendants de la fréquence. C’est plutôt dans les autres cas que le mot « phase » prend tout son sens.

D’une manière générale, la phase est un truc pas toujours intuitif.

Plus la vidéo Evidemment .

(-; Be Funky ;-)

Jan mk2

Rappelons que sauf erreur de ma part, il faut bien un déphasage entre les signaux pour assurer la stéréo. Deux signaux en phrase parfaite donneraient un son mono.

Si on chipote un peu, tu as raison si on prend le terme stéréo au pied de la lettre. Le sens étymologique de stéréo est relief. Du coup, la mono orientée entre deux enceintes n'est pas à proprement parler une stéréo. Mais elle ne le serait pas non plus si on disposait de pan-pots qui agiraient sur le décalage temporel comme il le font sur le niveau.

N'est-il pas plus juste de parler de décalage temporel ?

Tout à fait, pan sur mon bec ! J'aurais pu me défendre si j'avais écrit "décalages de phases" au pluriel, mais non, sur ce coup, c'est irrécupérable (de lapin).

Alan Parson a peut-être dit : "Audiophiles don't use their equipment to listen to your music. Audiophiles use your music to listen to their equipment."

Jan mk2

Tout à fait. selon que l'on parle de musique( analogique et/ou numérique ) d'électricité , de prise de son , les termes changent et il est difficile de l'expliquer , de se faire comprendre ...

Comme tu dis la musique n'est pas un signal périodique constant , on ne compose pas du bruit blanc ou rose , ça deviendrait monotone

Ben... le bruit blanc n'est pas un signal périodique, pas plus que le bruit rose.

Quelques signaux périodiques en audio : sinus, dent de scie, carré. La condition sine qua non est que la fréquence doit être constante et chaque période identique.

On devrait parler DES phases , car une phase seule , elle , elle s'en fiche , elle est en phase avec elle même.

( corrélation ; co = 2 )

xHors sujet :Citation :Gloire à la phase ! Non à l'antiphase !

Non à l'anti phrase.

Alan Parson a peut-être dit : "Audiophiles don't use their equipment to listen to your music. Audiophiles use your music to listen to their equipment."

BBmiX

(-; Be Funky ;-)

Anonyme

Wolfen

Rappelons que sauf erreur de ma part, il faut bien un déphasage entre les signaux pour assurer la stéréo. Deux signaux en phrase parfaite donneraient un son mono.

Et bien non

Développeur de Musical Entropy | Nouveau plug-in freeware, The Great Escape | Soundcloud

Dr Pouet

C'est pas simple ce truc. Je viens de lire tous les posts et...

Oui, ce n’est pas simple. Mais on n’a pas forcément besoin de tout comprendre dans la théorie et les explications. Les recettes de cuisine évoquées pour détecter, et résoudre les problèmes, sont suffisantes !

Dr Pouet

On en parlait en 2011 :

https://fr.audiofanzine.com/techniques-du-son/forums/t.24161,comment-faire-une-vraie-stereo-a-partir-d-un-fichier-mono,post.6582892.html

Je ne sais pas s’il y a des outils qui font ça actuellement.

iktomi

Ceci dit ça me fait penser aux bonnes vieilles musiques de jeux Amstrad (notamment le thème de Cybernoid que j'ai toujours adoré) qui étaient stéréo (les musiques) avec tous les "instrus" résolument mono ET certains exclusivement D ou G.

Bienvenu en 1987

[ Dernière édition du message le 27/10/2020 à 11:34:37 ]

BBmiX

C'est pas simple ce truc. Je viens de lire tous les posts et...

tant que tu reste en phase avec toi même

Je ne sais pas s’il y a des outils qui font ça actuellement.

idem ; des outils " suiveurs " qui ferait ça tout au long d'un morceau , je n'y crois pas trop en fait .

(-; Be Funky ;-)

[ Dernière édition du message le 27/10/2020 à 12:45:35 ]

8oris

Trés bien expliqué merci vu la complexité de l'acoustique ,une des sciences les plus compliquée.

Non mais LOL!

Danbei

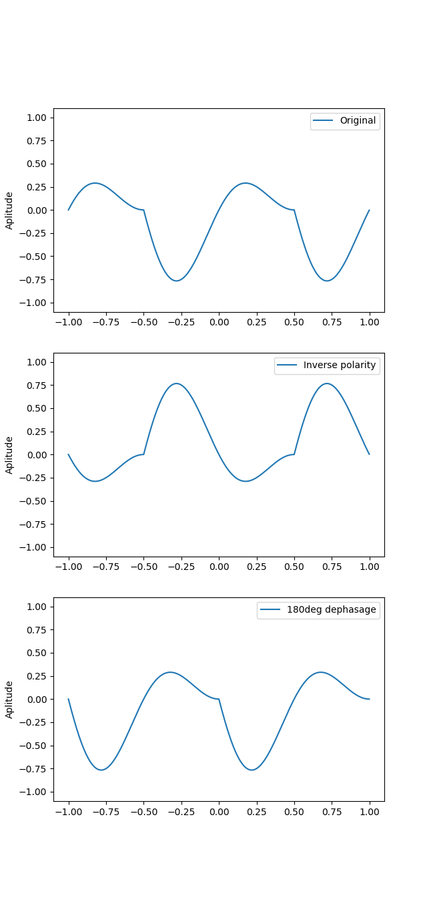

Une inversion de polarité entraîne un déphasage de 180° quelle que soit la fréquence.

De manière général ce n'est pas le cas, par exemple avec ce signal plus bas, duquel on montre deux périodes.

L'inversion de la polarité de donne pas le même résultat qu'un déphasage de 180°.

En fait un déphasage de 180° est équivalent à une inversion de polarité dans le cas ou le signal a une symétrie par rapport au point (milieu_de_la_période, 0). Avec une sinusoïde ça marche parce qu'on a la bonne symétrie.

Dr Pouet

Danbei

La subtilité c'est qu'appliquer un déphasage de 180° à un signal "complexe" (contenant plusieurs fréquences) n'est pas appliquer un déphasage de 180° à chacune des composantes du signal séparément.

Dans l'exemple que je montre, j'ai appliqué un déphasage de 180° au signal entier, dans ce cas ce n'est pas équivalent à une inversion de polarité.

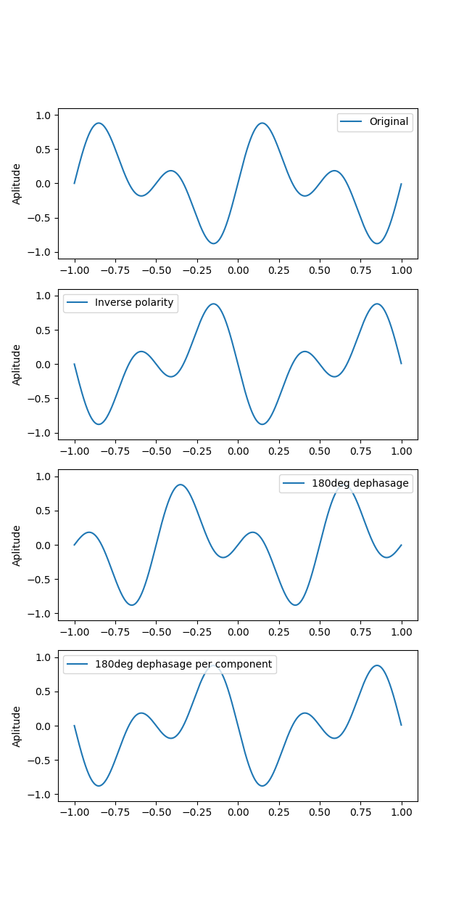

Si on décompose le signal en chacune de ses composantes fréquentielles et qu'on applique un déphasage de 180° à chacune des composantes séparément pour à la fin les recombiner, je suppose que tu as raison.

EDIT : Illustration

Cette fois ci avec un signal plus simple (composé de deux sinus)

On a bien le même résultat avec l'inversion de polarité et le déphasage par composante.

[ Dernière édition du message le 27/10/2020 à 14:35:38 ]

Jan mk2

De toutes façons, je n'ai pas beaucoup à me fatiguer, car c'est la définition de l'inversion de polarité dans toutes la littérature scientifique qui traite de ce sujet

Alan Parson a peut-être dit : "Audiophiles don't use their equipment to listen to your music. Audiophiles use your music to listen to their equipment."

iktomi

En fait j'ai peut être compris ta phrase de travers.

Non mais si vous êtes déphrasés pour parler de déphasage, on va pas s'en sortir !

Dr Pouet

Oui Danbei, j'allais le dire. Il y avait un biais dans ton exemple. Car dans le premier schéma que tu montres, j'ai bien l'impression qu'il est appliqué un retard équivalent à une demi longueur d'onde de la fondamentale ce qui correspond dans son cas (et seulement pour elle) à une inversion de polarité.

De toutes façons, je n'ai pas beaucoup à me fatiguer, car c'est la définition de l'inversion de polarité dans toutes la littérature scientifique qui traite de ce sujet

Ah oui exact. Ben justement là on voit bien la différence entre retard temporel (le premier cas) et changement de phase.

Will Zégal

Pourtant, tout être humain qui entend une cloche sait d'où provient le son. Si la phase était cette source de connaissance, nous hésiterions entre plusieurs directions.

Autant j'ai un peu raccourci en semblant limiter la stéréo a une question de phase, autant il m'a semblé que tu me répondais en parlant de spatialisation (surtout d'un son mono). La question de la stéréo n'est-elle pas un peu plus large ?

Je peux par exemple avoir une nappe de synthé centrée et pourtant stéréo.

Ce qui ne veut pas dire que je n'ai pas fait erreur, hein.

Wolfen a d'ailleurs été plus précis que moi en parlant de signaux corrélés.

Je suppose qu'on sera tous d'accord pour dire que ma nappe de synthé est composée deux de signaux / canaux non parfaitement corrélés et que c'est bien ça qui la rend stéréo, mais ce qui différencie les signaux droit et gauche est-il uniquement une question de temps pour arriver aux oreilles ou (aussi) une différence de phase entre les signaux ?

iktomi

Will Zégal

Mais dans tous les cas est-ce qu'on peut parler de stéréo dans ce cas ? Deux sons identiques reproduits sur deux pistes, même réparties dans le champ stéréo, ne font jamais qu'un signal mono.

f.fe

GUITARTEC

- < Liste des sujets

- Charte