Du volume, du volume ! Oui, mais à quel prix ? Cette série d’articles passera en revue les origines de la course au volume, les considérations physiques, les nouvelles normes et outils et son impact sur la santé publique.

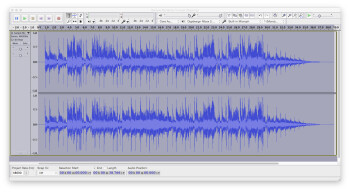

Indéniablement, l’audionumérique a été une « bénédiction » : on ne reviendra pas ici sur toutes ses innovations, la place allouée à cet article n’y suffirait pas. Prenons simplement quelques exemples : un éditeur comme Audacity, multiplateforme et gratuit, disposant d’un Paulstretch qui nourrira à l’infini n’importe quel échantillonneur. « Passez » votre voix « dans » une guitare grâce aux logiciels de convolution (gratuits…) LA Convolver ou Reverberate LE. Disposez pour une cinquantaine d’euros d’un des meilleurs logiciels de transposition et compression/expansion temporelle, avec Amazing Slow Downer. Pour une trentaine d’euros, voici Mainstage, une application dédiée à la scène (Mac seulement, il est vrai), avec une foultitude d’effets (y compris pour l’audio), de synthés virtuels et d’instruments échantillonnés, plus un outil d’échantillonnage issu d’AutoSampler de Redmatica (arme secrète de plusieurs éditeurs de banques d’échantillons…). Ou encore, sur iPad, Auria, STAN audio 48 pistes, permettant le travail à l’image (!), avec une qualité sonore irréprochable (pour 24,99 euros…).

Mais l’audionumérique a aussi été une « malédiction » : alors que l’on dispose d’outils incroyables et toujours plus performants, la qualité audio a subi une baisse continuelle, offrant de la musique et du son de plus en plus écrasés, saturés, l’opposé de ce qui fait la vie d’un objet sonore, musical. Sans compter l’impact de ces pratiques en termes de santé publique.

Car il faut comprendre une chose : si notre environnement et les pratiques d’écoute restent les mêmes, on aboutira à une génération de sourds à partir de 40–50 ans ! Pourtant cela fait des années qu’un certain nombre de professionnels (notamment via la Semaine du Son) tirent la sonnette d’alarme. Même les pouvoirs publics, dont on connaît la rapidité de réaction, se sont emparés du sujet ; il n’est jamais trop tard pour bien faire…

Mais avant d’expliquer le pourquoi de cette funeste perspective, revenons en arrière, pour un peu d’histoire.

Comment, pourquoi ?

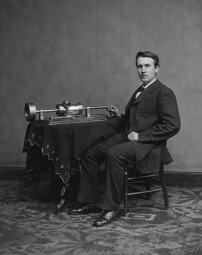

Un rappel, évident, mais nécessaire : la musique enregistrée n’est que la tradition la plus récente de diffusion de cet art. Avant l’arrivée des premiers procédés de reproduction inventés par Édouard-Léon Scott De Martinville (le phonautographe), Charles Cros (le paléophone) et Thomas Edison (le phonographe), on ne pouvait en écouter qu’interprétée en direct, dans un cadre domestique ou dans un espace dédié.

Et, une fois les moyens d’enregistrement disponibles, l’idée de « produire » la musique, le son, au sens où l’on intervient après fixation sur un support, n’était pas de mise : le principe de base était de rendre le plus fidèlement possible ce que les musiciens, compositeurs, arrangeurs, chefs d’orchestre prenaient tant de temps à peaufiner, de la composition aux répétitions, en passant par l’orchestration, l’arrangement. Modifier la dynamique d’un orchestre ou d’un instrumentiste après coup, simplement pour que le son global soit plus fort n’était pas de mise (voir Reverse Orchestration).

En revanche, la pratique du gain/level riding, suivi de gain (que l’on pourrait qualifier de compression manuelle), a dès le départ été pratiquée dans les premiers studios, qu’ils soient de musique ou de cinéma avec l’arrivée du son synchrone, et ce afin d’éviter les surmodulations, les crêtes, ou pour éviter de passer sous le bruit de fond propre du support visé. Mais c’est tout particulièrement dans les stations de radio que l’on retrouvera cette pratique, menant à l’apparition des premiers limiteurs, après que plusieurs techniciens ont effectué des modifications maison sur des amplificateurs. En découle, en 1936–1937, l’arrivée sur le marché des Western Electric 110-A, RCA 96-A et Gates 17-B, libérant plus ou moins les opérateurs de cette tâche.

Les premiers racks performants datent de 1947, année de sortie du General Electric GE BA-5 (limiteur feed-forward), RCA le copiant immédiatement, sous le nom de… RCA BA-5. Premiers effets collatéraux, le pompage et la distorsion (déjà…). Peu de temps après, le RCA BA-6A tente de remédier à ces effets. Mais c’est l’apparition de nouveaux tubes variable-mu dans les années 50, des compresseurs/limiteurs avec fonctionnement opto-électrique (Teletronix LA-2A) ou utilisant des transistors à effet de champ (Urei 1176) dans les années 60, associés aux débuts de l’enregistrement multipiste, qui vont changer à jamais la gestion du volume, avant, pendant et après enregistrement.

Reverse Orchestration

Bien sûr, la volonté de reproduire fidèlement ce que l’on entendait en l’enregistrant n’a pas été la seule direction suivie. Et c’est notamment dans le domaine du cinéma que les premières expériences ont été menées. Deux exemples seulement : en France, Maurice Jaubert, premier véritable théoricien de la musique de films, a mis en avant la nécessité de s’appuyer sur les apports techniques afin de proposer une autre réalité sonore, en appliquant ses théories (voir notamment la scène du dortoir dans Zéro de Conduite de Jean Vigo, 1933).

Et en Russie, Prokofiev, compositeur régulier de Sergueï Eisenstein, a pratiqué la « reverse orchestration1 », grâce au placement des microphones : la possibilité de saturer ou de mettre en avant un instrument au-dessus d’une masse orchestrale d’une façon totalement impossible dans la réalité (un basson soliste sur les triple forte d’un tutti d’orchestre, par exemple). Voir Alexandre Nevski (1938).

1-Selon le terme créé par Robert Robertson dans Eisenstein On The Audiovisual, IB Tauris Publishing, 2009.