Top config PC MAO 2021 (test, bench, discussion, débat...)

- 1 405 réponses

- 55 participants

- 95 106 vues

- 74 followers

Darkmoon

Je créer ce nouveau thread pour faire suite à ces deux derniers (créés par moi-même et Charles Bunk) :

Top config PC MAO 2019 (test, bench, discussion, débat...)

Top Config M.A.O 2020

Nous poursuivons donc ici à causer des nouveaux processeurs du moment. Nous effectuons parfois des tests et des benchs. Nous causons aussi de configuration MAO et d'optimisation, de notre façon de bosser dans tel ou tel DAW, etc. Nous partageons nos machines et configs et aiguillons les newbs et/ou ceux qui posent des questions vers la machine la plus appropriée pour leur besoin et, bien sûr, nous débattons parfois, mais dans la bonne humeur et le respect, parce que nous sommes passionnés, mais ne partageons pas tous forcément les mêmes idées et opinions (ce qui est très bien ainsi!). Bref, le sujet est relativement libre et ouvert, du moment que ça concerne l'informatique et la MAO!

Voilà, en souhaitant de bons échanges à tous pour cette nouvelle année 2021!

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Eric Music Strasbourg

Eric

Elka21

Est ce qu'une appli classique peut voir ce qui se passe en temps réel sur un driver qui travaille à un niveau plus bas je crois ?

nicosplash

https://soundcloud.com/nicosplash

Eric Music Strasbourg

Eric

Darkmoon

Je suis d’accord que si l'on utilise plusieurs écrans et/ou des écrans avec de très haute résolutions et qu’on se retrouve à ouvrir plusieurs dizaines de GUI simultanément un GPU un peu plus puissant qu’un iGPU est nécessaire, mais j’ai l’impression que c’est quand même une utilisation extrême. Combien de fenêtres de plugins est ce que vous ouvrez simultanément dans votre manière de travailler ?

Idem. Snowfall a une utilisation très spécifique qui ne justifie pas de pouvoir recommander — de façon générale — l’achat d’une carte graphique pour faire de la MAO. Avec un PC récent et les IGPU (puce graphique intégrée) actuels, c’est bon pour 99.9% des utilisateurs.

Je rappel qu’à l’époque des mes bench avec mon 8700K, j’avais pris soin de comparer (pendant quand même quelques semaines d’utilisation pour les 2 cas) la différence entre l’IGPU du 8700K et ma GeForce GTX 1060 6 GB et que je n’avais noté absolument aucune différence perceptible. Autrement dit, sur de gros projets gourmands en ressources (en basse latence), le fait d’utiliser l’IGPU ne se répercutait pas du tout sur la consommation CPU. Et sinon, pour ce qui est de l’affichage de certains plugins, ne disposant que de deux écrans en 1080P et n’en ouvrant pas plus de 3, 4 fenêtres à la fois sur le 2e écran (Voxengo SPAN, DB meter, EQ paragraphique, P. Ex.) je n’ai jamais expérimenté aucun problème.

...J’avais 151 processus en arrière-plan alors que sur win10, j’en ai 130. Mais je n’ai pas fait d’optimisation.

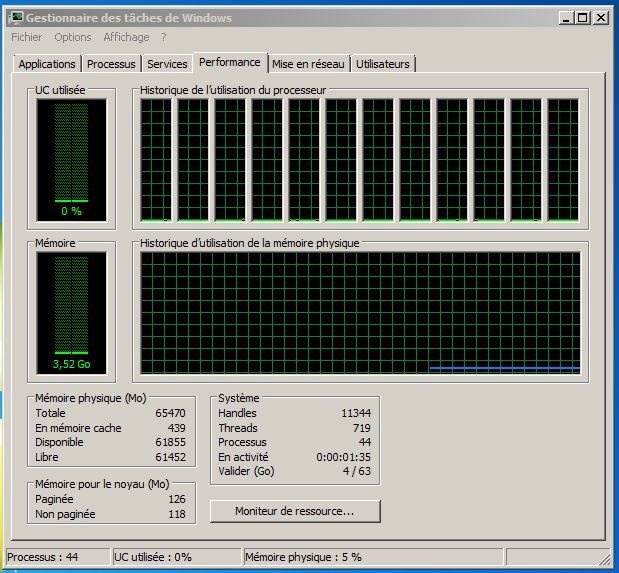

Comme je l’ai partagé il y a quelques semaines, je suis repassé à W7 sur mon PCMAO (8700K) et voici ce que j’ai en terme de processus et de conso RAM (1:35 minute après l’ouverture de session Windows) :

44 processus et 3,52Go d’utilisation RAM! Et ça c’est avec les services réseau activés pour aller sur le net et tout et tout. J’ai juste fait les 5, 6 « tweak » d’usage les plus commun et nécessaire, rien de trop poussé. Et, en passant, je n’ai plus aucun problème de « micro-glitch intempestif » (avec un buffer à 64smp).

Chaque nouvelles sorties de Windows est prétendue plus véloce que la précédente . . . comme j'ai gardé un double boot avec Xp, ce n'est pas ce que je constate au final en réactivité. Et comment pourrait il en être autrement puisque à chaque version, de plus en de plus de processus tournant en tache de fond ? ...

Yep! Idem! C’est quand même fou, la puissance des CPU augmente sans cesse, mais si je prends en compte les chiffres de madamereve (151 ou 130 processus), l’exploitation de processus a, elle, plus que triplé avec les nouveaux OS,

Je serais curieux de vérifier si le lancement de tel ou tel logiciel est « moins rapide » sous mon W7 que sur W10 ou W11. Mais je suis très « sceptique » d'avance, car, sérieusement, c’est quasi instantané de mon côté. Et pour ce qui est du chargement de banque Kontakt, P. Ex., j’avais déjà effectué des tests à l’époque de mes bench et c’était essentiellement l’utilisation d’un disque NVMe qui faisait la différence (± 4,5x la vitesse de chargement d’avec un SSD) selon les vitesses d'accès, etc.

.Bref, je suis revenu à mon win10 en me disant que la transition ne serait pas dramatique voire sympathique.

Latencymon reste au même niveau concernant la latence en ce qui me concerne.

D’un point de vue général ce n’est pas une révolution....

C’est ce que je pense (jusqu’à ce qu’on me prouve le contraire par autre chose que des impressions). De mon côté, moi aussi je ne constate pas bcp de différence entre W10 et W7 sous LatencyMon. Rien de significatif, mais quand même des valeurs un tantinet moindres (en μs) sous W7. Et, surtout, bcp moins de « pagefault ».

À l’utilisation, dans les faits concrets, la seule chose que ça change, c’est que j’ai le contrôle total sur ce qui se passe en arrière-plan. Conséquemment, même en basse latence (64smp), si je joue pendant plusieurs heures d’affilée, rien ne se déclenche pour provoquer un minuscule glitch, ce qui m’arrivait parfois sous W10, même si ce n’était pas dramatique et que ça se produisait qu’une fois au 15 minutes environ (un très minuscule glitch).

Cela étant dit, je doute que ce soit équivalent à ce dont il est question pour WIndows 11, le commentaire sous l’article me semble un peu mauvaise langue : ce n’est pas parce que l’idée de donner la priorité aux applications en premier plan existait déjà qu’il n’y a pas eu un progrès de fait dans l’implémentation.

Je bifurque un peu, il est parfois conseillé de prioriser les processus en arrière-plan pour la MAO via ce paramètre. Cela permettrait de ne pas interrompre le travail du pilote audio, explication qui m’a toujours paru fumeuse étant donné que ce paramètre concerne à priori les applications et non pas les pilotes. Est ce que quelqu’un à des éléments, des bench qui infirme ou confirme cette explication.

Des bench, non, puisqu'en effet personne n’a jamais vraiment su comment ça agit précisément (du moins j’ai jamais trouvé sur le net en plus de 25 ans!). Il fut une époque (vous connaissez ma « minutie légendaire qui relève presque du TOC

Le seul truc qui ne relève pas de l’impression et de rumeurs, c’est que, à une époque, Steinberg, lui, précisait bien, pour Cubase, de choisir « Les services d’arrière-plan » au lieu du choix par défaut qui est sur « Les programmes ». J’ose imaginer que Steinberg avait de bonnes raisons et savait pourquoi (je pourrais retrouver les sources et liens si besoin).

Et c’est aussi Steinberg (à une époque) et Digidesign/Avid (Pro Tools) qui, encore jusqu’à il y a quelques années, préconisaient de désactiver l’Hyper-Threading dans le BIOS. Mais ça aussi, lors de mes bench (pour ceux qui s’en souviennent) j’avais démontré dans mes vidéos que désactiver l’Hyper-Threading dans le BIOS n’améliorait rien, mais au contraire dégradait fortement les performances, que ce soit dans FL, SO, Reaper, Cakewalk, Mixcraft. C’était sans équivoque!

Mais pour revenir au fait de prioriser les processus en arrière plan, mon hypothèse, c'est que la majorité (on parle d’il y a plusieurs années, hein, début 2000 au moins si ça ne remonte pas à encore plus loin) des individus qui ont repris les principaux conseils pour paramétrer un PC pour faire de la MAO ont seulement « répété » ce conseil de Steinberg et, de fils en aiguille, ça c’est retrouvé un peu partout comme « tweak à faire » sans préciser que cela s'appliquait spécifiquement pour Cubase (et/ou a Pro Tools, à vérifier). Mais bon, n’ayant jamais été en mesure de passer plus d’une journée à tenter de comprendre la « logique absconse » de Cubase

Sinon, si l’on cherche retrouve mes anciens post sur AF, vous remarquerez que, perso, j’ai tjrs pris soin de formuler, P. Ex. « si nous sommes sous Cubase », comme ici au point #5, vers la fin.

Sinon, il y a Process Lasso, que certains doivent connaître et qui permet pour chaque thread [...] Bref, pour avoir tweaké plusieurs bécanes au cours de ma vie de musicien geek, je pense qu’aller au delà de la désactivation de services inutiles qui tournent en tâche de fond + mise en place d’options d’alimentation délivrant un max de puissance, ne sert pas à grand chose. En tout cas, ça me semble tout à fait dispensable.

Je pense, concernant ce dernier point aux tweaks du registre, tweaks des IRQs (priorités, passage en mode full MSI). Après, peut-être que l’optimisation du timer de Windows (avec ISLC ou Timertool.exe) apporte un léger gain dont il serait sans doute dommage de se priver.

Qu’en pensez-vous ?

Je suis d’accord!

J’ai testé quelque peu la priorité des thread (autant manuel qu’avec certains utilitaires dédiés), mais je n’ai jamais noté d’amélioration significative.

Bref, pour moi, de nos jours les seules « tweak » vraiment nécessaires à effectuer pour faire de la MAO sont :

- désactiver la carte son onboard dans le BIOS,

- désactiver/quitter/suspendre l’antivirus/Win Defender (ajouter aussi des exclusions pour les dossiers de samples/banque dans WDefender). Idem pour tout autre logiciel (Messenger, navigateur internet, etc.) lors d’une session MAO,

- paramétrer la gestion/options d’alimentation sur « performances élevées », mettre tout ce qui concerne les mises en veille/arrêt des disques à « 0/jamais/désactivé », désactiver la suspension sélective USB ,etc.,

- décocher « autoriser à éteindre ce périphérique pour économiser de l’énergie » pour tous les concentrateurs USB dans de gestionnaire de périphérique.

Dans la très grande majorité des cas, ce sera amplement suffisant!

Sinon (si problème~« glitch » seulement) :

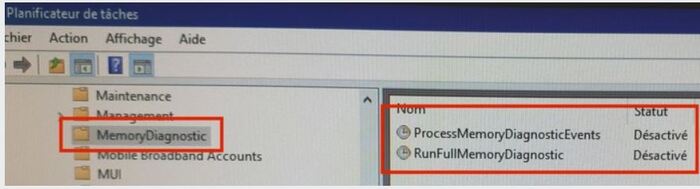

- désactiver ces 2 lignes/tâches dans le planificateur de tâche (c’est ce qui empêchait les quelques glitch intempestifs chez moi, sous W10) :

- éventuellement, désactivez momentanément la carte réseau (à une époque, c’était souvent cette dernière qui provoquait des requêtes provoquant des glitchs en basse latence. Moins vrais de nos jours, de façon générale),

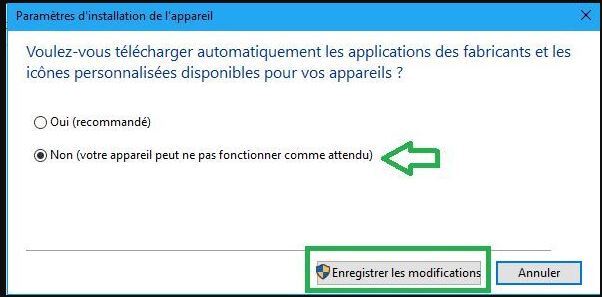

- faire attention à cette option, depuis W10 :

Car, parfois, chez certains, Windows télécharge et remplace (automatiquement, en arrière-plan, sans nous informer

Danbei ou Darkmoon si vous avez une méthode "scientifique" pour analyser les résultats w10 bvs w11 ça serait pas mal parce que j’ai un peu peur que le panneau de performances Windows soit un peu court... ça ne sert à rien de dire que ceci est mieux ou moins bien si en réalité ça n’est pas vérifié. d’autre part je me demande si ça peut servir à d’autres parce que chaque ordi est un peu différent voir beaucoup d’ailleurs.

Bah, ça dépend ce qu’on veut observer, mais c’est pas bien compliqué d’imaginer comment faire pour que ce soit « concret~objectif ».

Je sais pas, si, P. Ex., l’on cause de l’ouverture d’un logiciel, ben suffit qu’à mesurer le laps temps entre le moment du clic de souris et son ouverture ....avec un chrono. J’crois pas que ça nécessite une précision extrême dans la mesure où si la différence est moindre que de l’ordre de la seconde, ce n’est pas très « significatif ». Donc un simple chrono à la main (smartphone) suffit.

Sinon (pour être plus précis), juste à faire des captures vidéo (avec OBS, P. Ex.) et d’utiliser ensuite un soft de montage vidéo : nous calons les 2 vidéos au clic de la souris et pourrons observer si les fenêtres du soft s’ouvrent au même moment. Si l’on réalise la capture en 60i/s, ben l’échelle de précision sera de 16,66ms. Ou de 33,33ms à 30i/s. Bref, si les fenêtres s’ouvrent simultanément, je ne crois pas qu’en déca de cette échelle de précision (admettons qu’une s’ouvre avant, mais qu’on ne puisse le constater), l’on puisse vraiment dire que ce soit « plus rapide à l’usage ».

Pour ce qui est de la perf en basse latence, ben suffirait d’ouvrir un projet identique, une fois sous W10, une autre fois sous W11. Mais bon, sur une même machine, donc ça nécessite un dual boot et c’est donc juste « chiant » à mettre en place.

Pour le reste (chargement de banque Kontakt, P. Ex.) je n’y crois pas. Ça ne fait pas de sens. Si j’ouvre mon DAW dans un projet vide, l’OS ne peut pas anticiper lequel de mes templates je vais peut-être ouvrir 10 secondes plus tard et « pré charger » les 60Go de RAM que nécessite ce projet orchestral, P. Ex. L’OS n’anticipe pas ce genre de truc.

La fonction « Superfetch » (que moi je désactive depuis tjrs), présente, en effet, depuis de nombreuses versions (depuis 98 ou XP, je crois), ça ne fait qu’analyser quel logiciel l’utilisateur ouvre le plus souvent pour ensuite déplacer (à l’époque de 98/XP) les données correspondantes au début du disque (à l’époque des HDD) et/ou précharger en RAM. Mais ça ne gère pas les « plugins » (que ce soit en MAO ou autres) au sein même des logiciels ni les données (samples, photos, vidéos) qui seront exploitées par les logiciels. Ça ne fait pas de sens, car, P. Ex., un professionnel qui bosse sur plusieurs gros projets de photos~vidéos, l’OS ne peut pas « précharger » les rush d’un (des) shooting photo~vidéo qui peuvent faire plusieurs dizaines de Go. Ça limiterait la RAM dispo pour d’autres tâches plus « probables » et pertinentes.

Et pour ce qui est de la latence audio de nos interface, il n’y a rien de plus objectif et concret que d’utiliser RTL Utility en connectant un câble d’une sortie à une entrée pour mesurer la latence réelle effective (ce que je reproche souvent à AF de ne pas faire lors de ses tests d’interface audio

Sinon pour le reste, ben ça nécessite « juste » d’avoir 2 PC identiques (ou en dual boot) avec les mêmes logiciels, plugins, composants, périphériques, projets.

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Danbei

La fonction « Superfetch » (que moi je désactive depuis tjrs), présente, en effet, depuis de nombreuses versions (depuis 98 ou XP, je crois), ça ne fait qu’analyser quel logiciel l’utilisateur ouvre le plus souvent pour ensuite déplacer (à l’époque de 98/XP) les données correspondantes au début du disque (à l’époque des HDD) et/ou précharger en RAM. Mais ça ne gère pas les « plugins » (que ce soit en MAO ou autres) au sein même des logiciels ni les données (samples, photos, vidéos) qui seront exploitées par les logiciels.

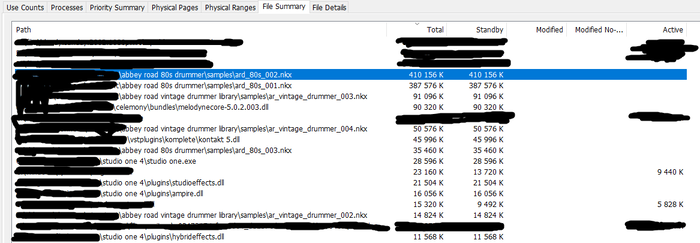

On peut aussi s'en convaincre en regardant ce qu'il y a dans la RAM. Par exemple, après avoir ouvert une session Studio One et l'avoir fermé, dans la RAM il y a (logiciel rammap) :

On y voit des VST, des VSTi, Studio One, Kontakt, Melodyne etc.. Je reprécise qu'au moment du screen aucun soft de MAO n'est ouvert.

La réouverture de la session est plus rapide, parce qu'il y a une partie des banques de sons déjà présente dans la RAM.

Et non ça ne déplace pas les données sur le support de stockage, ce serait pas très malin parce que ce genre de déplacement coute cher en performances.

Ça ne fait pas de sens, car, P. Ex., un professionnel qui bosse sur plusieurs gros projets de photos~vidéos, l’OS ne peut pas « précharger » les rush d’un (des) shooting photo~vidéo qui peuvent faire plusieurs dizaines de Go.

Ça limiterait la RAM dispo pour d’autres tâches plus « probables » et pertinentes.

Il y a à priori pas vraiment de risque à utiliser cette fonctionnalité : dans le pire des cas l'OS n'a pas anticipé correctement quelles données allaient être utilisées et tout se passe comme si la fonctionnalité n'était pas présente. Dans le meilleur des cas l'OS a bien deviné et les données à chargées sont déjà dans la RAM.

[ Dernière édition du message le 09/11/2021 à 22:09:52 ]

Eric Music Strasbourg

Eric

madamereve

Au démarrage dans les deux cas ? Parce que si on ouvre des fichiers ou des soft, après les avoir refermer ils seront dans le cache.

Après avoir ouvert quelques fichiers :

Pour savoir ce qu'il y a dans le cache tu peux utiliser rammap :

Dans la fenêtre principal on a le résumé de l'utilisation de la RAM, on sait notamment si c'est de la mémoire d'un process ou des fichiers mis en cache. Ici en l'occurence c'est principalement les fichiers que je viens de lire.

Dans la fenêtre "File summary" on a le détail de quels fichiers sont dans le RAM

Merci pour les infos et le soft.

Je vais approfondir ça.

[ Dernière édition du message le 09/11/2021 à 22:52:56 ]

Darkmoon

Non, toutes les données lu sont susceptibles de se retrouver caché RAM.

Ben, formulé comme ça, c'est une espèce de pléonasme~truisme. Il est évident que les données qui sont lues sont susceptibles de se retoruver en RAM! :p (mais là je fait exprès de jouer sur les mots!

Mais sinon, de tout temps, la « fonction d'anticipation » (auparavant nommée « Prefetcher » et maintenant « SuperFetch ») a toujours consisté, entre autres (voir l'autre point plus bas concernant le déplacement de données sur disque) à exploiter la RAM pour mettre en cache ce qui est le plus susceptible d'être démarré souvent! Yep! J'ai jamais dit le contraire!

Bref, ton « non » et ton apparent désaccord relève plus de la sémantique et/ou du fait de ne pas tenir compte de certains points que je prends pourtant soin de préciser àmha.

On peut aussi s'en convaincre en regardant ce qu'il y a dans la RAM. Par exemple, après avoir ouvert une session Studio One et l'avoir fermé, dans la RAM il y a...

Oui, je n'en doute pas. Mais ce n'est pas forcément, dans tous les cas, avantageux. Si, P. Ex., tu décides d'ouvrir et de bosser sur du montage vidéo avec plusieurs Go de rushs, l'OS devra se débarrasser de tout ce qu'il avait conservé pour SO. Ça n'est utile que si, P. Ex., tu ré-ouvre SO sans avoir bossé sur autre chose nécessitant bcp de RAM entre les deux.

La réouverture de la session est plus rapide, parce qu'il y a une partie des banques de sons déjà présente dans la RAM.

Oui, naturellement. Mais laisser SO ouvert avec le projet au lieu de le fermer ferait la même chose. Là, si tu ouvres un tout autre projet n'utilisant pas les mêmes données, ben ça ne sert à rien. Autrement dit, ça ne sert que si tu fermes un soft, n'en utilise pas un autre qui requiert l'espace RAM où l'OS conserve les données du premier soft, et ré-ouvre le même soft pour un même projet (utilisant les même données~samples). Je ne trouve donc pas ça si « super » que ça.

Et non ça ne déplace pas les données sur le support de stockage, ce serait pas très malin...

Nope!

*le « Task Scheduler », responsable de l'analyse des traces recueillies par le prefetcher.

Mais, de nos jours, oui, étant donné les quantités/prix de RAM et l'avènement~démocratisation des SSD/NVMe, depuis Vista/W7, le « SuperFetch » (qui à remplacé le « Prefetcher ») exploite essentiellement la RAM et déplacer les données sur disque est, naturellement, devenu inutile étant donné les temps d’accès des disques SSD/ NVMe (sans compter que les défragmenter est contre-productif pour la durée de vie de leurs cellules). Désolé de ne pas toujours tout expliquer dans le moindre détails, comme maintenant, mais j'essai d'éviter de faire systématiquement de longs pavées. Ayant précisé « à l'époque des HDD sous WXP », je croyais que tu aurais compris!

Citation de Darkmoon :Si on brasse beaucoup de données et à chaque fois différentes ca n'apportera pas grand chose. Par contre s'il y a des paternes d'utilisation des donnée bien définis on peu avoir des gains...Ça ne fait pas de sens, car, P. Ex., un professionnel qui bosse sur plusieurs gros projets de photos~vidéos, l’OS ne peut pas « précharger » les rush d’un (des) shooting photo~vidéo qui peuvent faire plusieurs dizaines de Go.

Il y a à priori pas vraiment de risque à utiliser cette fonctionnalité : dans le pire des cas l'OS n'a pas anticipé correctement quelles données allaient être utilisées et tout se passe comme si la fonctionnalité n'était pas présente. Dans le meilleur des cas l'OS a bien deviné et les données à chargées sont déjà dans la RAM.

Je suis « presque » d’accord. Mais il existe des cas de situations (P. Ex., s’il reste en RAM des dizaines de GO d’un très gros projet orchestral, entre autres) où y aura quelques secondes de nécessaires afin de « décharger » complètement la RAM avant d’ouvrir un autre logiciel nécessitant, lui aussi, l’emplacement déjà chargé (expérimenté à quelques reprises chez moi. Teste-le pour voir!).

Voilà, finalement l’on dit tous les deux peu ou prou la même chose!

Il semble juste que tu ignorais, qu’à une époque, la « fonction d’anticipation » déplaçait bel et bien des données sur le disque et que t’as ignoré que j’ai pris soin de souligner que ça ne s’appliquait qu’aux OS à l’époque des HDD. Pour le reste, nous disons la même chose et sommes d'accord, àma.

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

[ Dernière édition du message le 10/11/2021 à 05:12:22 ]

Darkmoon

Pour moi, et c’est un choix perso, selon mon utilisation, j’ai fait le choix, il y a déjà plusieurs années, de ne pas laisser activé toute fonction d’anticipation de mes OS. Parce qu’il arrive très souvent que je bosse par phase. C’est-à-dire que je peux très bien, pendant plusieurs semaines d’affilée, ne bosser que sur du montage vidéo, ensuite que sur du traitement photo (j’ai un DSLR et fait des shoots/vidéo en amateur), ensuite 3 semaines à réaliser principalement des synthèses dans Word et/ou faire des recherches sur le net, pour ensuite partir 3 mois uniquement sur des projets MAO etc.

Du coup, je n’ai jamais désiré que mes OS (que ce soit le Prefetcher à l’époque d’XP ou le SuperFetch de nos jours) concluent (de par leurs analyses) qu’ils doivent mettre en cache tel ou tel truc alors qu’il s’agit souvent de phase intense, mais pas nécessairement représentative de ce qui m’importe, en terme de réaction d’ouverture, pour une « fenêtre de temps donné » selon mes activités.

De plus, j’ai souvent réalisé des tests (depuis WXP jusqu'à W7) pour constater qu’au final — selon mes utilisations spécifiques — que ça ne changeait pratiquement rien dans les faits concrets. Il y a même des logiciels qui, P. Ex., placent directement des « pré-chargement » en RAM (nonobstant le fait d’être exploité ou pas par le Prefetcher/SuperFetch) via les clés de registre...

(HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion [Run/RunOnce/RunService/RunOnceService]).

...Et en les supprimant (et/ou les désactivant via l’onglet « démarrage » du MS-Config) j’ai constaté que l’ouverture de ces derniers (logiciels correspondants) ne nécessite qu’une seconde de plus, tout au plus. Du coup, je n’ai jamais compris l’utilité d’exploiter la RAM et de laisser des processus actifs, parce que, que ce soit le SuperFetch et/ou ce qui est mis en RAM, des process associés sont alors ouvert et en opération, si ce n'est, justement, concernant le SuperFetch, pour analyser, en temps réel, ce que l'on utilise (alors que j’ai besoin d’avoir le moins de trucs chargés lorsque je bosse en basse latence, ou fait du montage vidéo, entre autres) si ce n’est que pour « sauver » une seconde lorsque je veux, P. Ex. ouvrir Word, mon lecteur PDF, l’utilitaire de contrôle NVidia/ATI~AMD, mon correcteur orthographique, un soft Adobe, etc. ??? Bah, non!

De plus, certains logiciels, en eux-mêmes, s’ouvrent bcp plus rapidement que d’autres. Pour les DAW, Reaper et FL sont les champions tout catégoriels. Si l’on désactive les « splash screen » dans les options, ces deux DAW s’ouvrent quasi instantanément! Alors que tous les autres mettent au moins 2, 3 secondes (et même plus), même pour un projet vide.

Et perso, je ne trouve pas de cas de situation où, après des heures à faire autre chose, je voudrais ou bénéficierais du fait que mon OS ait conservé en RAM des dizaines de Go concernant un projet très spécifique. C’est personnel à chacun, mais, pour moi, je vois pas.

Tout ceci, concernant certains paramètres, à activer ou non, installer un antivirus ou pas, désactiver l’indexation, etc, concerne en fait les choix de chacun. Pour moi (désactiver les fonctions d’anticipation), ça s’inscrit dans une « philosophie globale » (la mienne, que je n’impose à personne) qui consiste à privilégier des « terminaux » différents et spécifiques paramétrés « aux petits oignons » pour chaque utilisation. C'est ce qui me plait!

Depuis que j’ai un salaire qui me le permet (près de 20 ans maintenant), j’ai tjrs un « PC bête de course » qui me sert principalement pour 3 activités gourmandes en ressources : MAO/Montage vidéo/Traitement photo. Je ne joue pas et ne fais rien d’autre avec ce PC. Ce dernier, que j’achète neuf et renouvelle au 4~5 ans, ne sert qu’à ça. Il est optimisé non pas pour démarrer « rapidement » mille et une applications, mais afin d’avoir le strict minimum qui tourne en tâche de fond afin de pouvoir exploiter au maximum les capacités de la machine en cour de projet (que ce soit MAO ou autres. J’utilise parfois ce PC avec OBS pour capturer 2 cam en 1080p en plus de la capture d’écran du DAW, donc 3 flux vidéo Full HD au total, plus le DAW qui tourne avec moi qui joue en temps réel.) Ce PC ne possède aucun antivirus, Defender est « supprimé » et/ou désactivé. Il est connecté au net que très rarement (je débranche carrément le RJ45 et/ou désactive la carte réseau) qu’en cas de stricte nécessité (activation de plugins, update obligé). Personne d’autre que moi n’a accès à ce PC, aucune clé USB autre que les miennes s’y connecte, etc. Et même si ça pourra paraître paradoxal à certains (étant donné « l ’apparente absence » de sécurité), c’est ce qui m’assure de ne rien perdre (projets, vidéos, photos), n’utilisant pas ce PC pour surfer et « tester ». Il est quasi en « vase clos ». Et ça me plait!

Ensuite, je me procure d’autres PC, d’occasion cette fois. Dont certains servent de « PC ludique familial » au salon et dans la salle à manger, connectée sur grand écran 40"~50" (pratique pour surfer et/ou visionner des trucs lors de repas entre amis, famille, etc.). Ces derniers sont configurés tout autrement! Et j’ai, aussi, toujours un « vieux PC » qui sert à tester des OS, des distribs Linux, des « trucs/sites peu recommandables», etc. Ce PC ne possède pas de données (archives, souvenirs, etc.) sensibles. Et aucun compte Microsoft, Google, FB n’ai jamais « activé/lié » sur ce PC. Et, finalement, j’utilise la précédente, l'ancienne « bête de course » comme « PC Gamer » pour mes « vieux jeux » (je ne joue qu’à des oldies) et/ou comme « réserve » pour faire de la MAO en cas de sérieux pépins avec ma bête de course actuelle.

Bref, tout ça fait partie d’une « stratégie globale » qui m’est propre et qui satisfait le « geek » que je suis. J’ai aussi une « routine de backup bien huilée » où je préfère archiver manuellement (2 fois/année) sur des disques externes, tout nouveau truc (« souvenirs », vidéos, photos, musiques, textes) qui m’est cher, plutôt que de laisser tourner un soft de backup qui fait de l’incrémentation et consomme des ressources, etc.

Bref, à chacun ses « philosophies d'utilisation »!

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

- < Liste des sujets

- Charte