Top config PC MAO 2022 (test, bench, discussion, débat...)

- 1 183 réponses

- 68 participants

- 78 594 vues

- 81 followers

Darkmoon

Ce sujet est la suite logique des précédents du même noms :

Top config PC MAO 2018 (test, bench, discussion, débat...)

Top config PC MAO 2019 (test, bench, discussion, débat...)

Top Config M.A.O 2020

Top config PC MAO 2021 (test, bench, discussion, débat...)

(Dernière page ici.)

Nous causons config MAO, PC, optimisation, DAW, interface audio, façons de bosser. Nous parlons matos, processeur, etc. Aussi, certains d'entre nous aiguillent les newbs et/ou ceux qui posent des questions vers la machine la plus appropriée pour leur besoin.

Et, bien sûr, nous débattons parfois, mais dans la bonne humeur et le respect, parce que nous sommes passionnés, mais ne partageons pas tous forcément les mêmes idées et opinions (ce qui est très bien ainsi!).

Voilà! En nous souhaitant de bons échanges en cette nouvelle année 2022!

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

ElliotValentine

Concernant les perfs, j'ai pas vu de grand changement. Grosse sensation de produit WIP, et pas d'un produit fini. C'est dommage. W10 était déjà suffisamment mature, j'aurais vraiment voulu qu'ils se penchent sur la cohérence de l'interface, qui était le dernier gros problème de W10.

Edit: Un truc bien relou, Microsoft joue les gros forceurs sur tous les softs complémentaires.

[ Dernière édition du message le 09/02/2022 à 07:40:12 ]

Snowfall

Citation de Snowfall :Intéressant comme données. J'ignore pourquoi mais j'aurais parié l'inverse pour la corrélation entre la capacité de stockage et le pourcentage de pannes.

Perso ça me paraît logique : plus t'as d'espace disponible et moins t'as besoin de réécrire sur les mêmes secteurs...

Maintenant que tu le dis c'est vrai que c'est logique. J'imagine que je me disais un truc du genre "Plus c'est gros plus ça chauffe, donc moins fiable dans le temps"

Deltank

Citation de Sarakyel :Citation de Snowfall :Intéressant comme données. J'ignore pourquoi mais j'aurais parié l'inverse pour la corrélation entre la capacité de stockage et le pourcentage de pannes.

Perso ça me paraît logique : plus t'as d'espace disponible et moins t'as besoin de réécrire sur les mêmes secteurs...

Maintenant que tu le dis c'est vrai que c'est logique. J'imagine que je me disais un truc du genre "Plus c'est gros plus ça chauffe, donc moins fiable dans le temps".

Plus gros, ça dissipe mieux la chaleur en général (plus grande surface en contact avec l'air ambiant) ...

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

[ Dernière édition du message le 09/02/2022 à 09:21:13 ]

Deltank

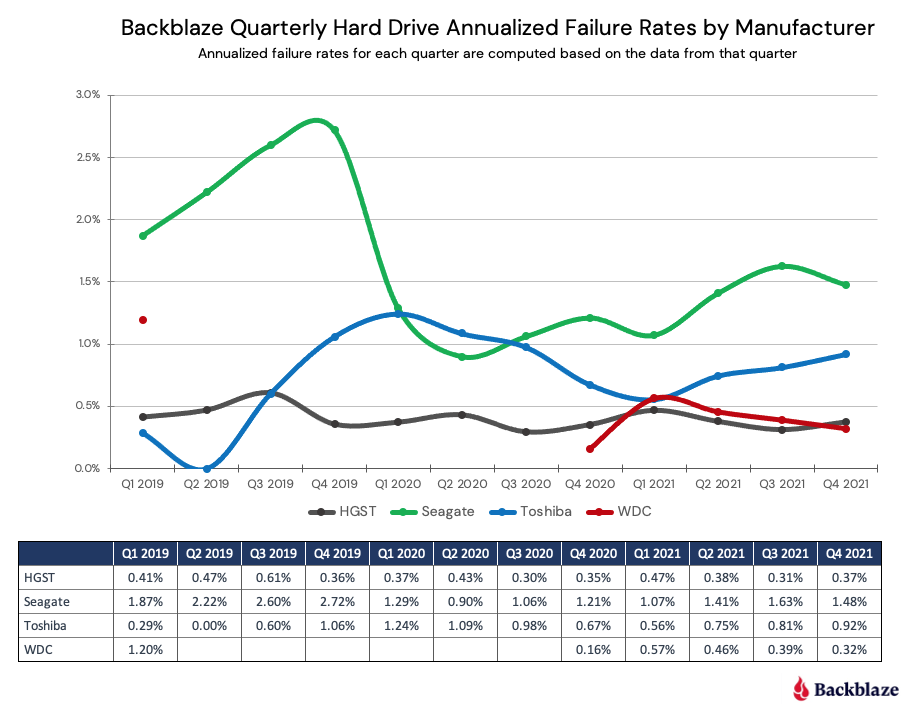

Pour ceux que ça intéresse, Blackblaze (boîte spécialisée dans le stockage de données) vient de publier le taux annualisé de pannes sur ses disques durs pour 2021, comme ils le font chaque année.

Résumé pour les non anglophones et ceux qui ont la flemme de décortiquer les résultats :

- Comme d'hab, Seagate est le plus mauvais élève avec un taux de pannes compris entre 1.11% et 4.79% (!!!) selon les modèles et les capacités. Deux modèles font mieux :

un très vieux (le ST6000DX000) avec un taux de panne très bas de 0.11%, ce qui est très impressionnant pour un disque âgé de plus de 6 ans - même si on ne connaît pas les chiffres des 3 premières années d'utilisation, les plus critiques ;

un plus récent (le ST12000NM001G), avec un taux moyen de 0.52% à prendre avec des pincettes puisque c'est un disque qui a moins de 18 mois.

- Toshiba est dans le milieu du panier avec des taux de pannes annualisés compris entre 0.70% et 2.04%, ce qui reste "bien mais pas top" pour des composants informatiques (les constructeurs visent généralement une moyenne autour des 1%).

- Sans surprise on retrouve WD en tête (Western Digital, qui comprend aussi les disques HGST, anciennement Hitachi) avec des taux compris entre 0.14% et 0.64%. Là on est bien.

- Dernier truc intéressant : plus les disques sont de capacité élevée, moins ils tombent en panne. Ainsi tous les HDD de 10 To ou moins ont un taux de panne supérieur à 1% tandis que ceux de 12 To ou plus ont un taux inférieur à 1%.

Conclusion (TL;DR) : si vous voulez stocker vos données de façon durable, prenez un disque WD aussi gros que possible et vous devriez être tranquille un bon moment.

Sur le parc de 200000 HDD de Blackblaze, 50% c'est du Seagate (c'est le plus représenté), alors qu'il n'y a que 5% de WD (donc 10 fois moins). De plus, les HDD WD ne sont représentés que sur la moitié de la période d'évaluation, il n'y aucune donnée de fiabilité de Q2 2019 à Q3 2020.

Autant on peut dire que les statistiques Seagate sont pertinentes vu le volume et la représentativité dans le temps, autant pour WD ce n'est pas du tout le cas. Avec les données de cette étude, pas possible de conclure objectivement que les HDD WD sont plus fiables que les HDD Seagate.

Pour ce qui est du rapport entre capacité et durabilité, l'étude précise que les plus gros HDD sont aussi les plus récents, et qu'ils apparaissent forcément comme plus fiables car les HDD plus petits sont plus vieux, et tombent donc plus en panne en moyenne.

Pas possible de conclure que les plus gros HDD sont plus fiables.

Tu dis "à prendre avec des pincettes" les bonnes stats d'un disque Seagate qui a moins de 18 mois, mais aucune méfiance de ta part pour les stats de tous les disques WD qui n'ont majoritairement pas plus de 15 mois...

Tu travailles pour WD ?

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

[ Dernière édition du message le 09/02/2022 à 11:11:40 ]

Supaxor

Citation de Supaxor :J'ai repéré ce modèle : https://www.biostar.com.tw/app/en/mb/introduction.php de chez eux qui est le seul Z690/DDR5 à posséder 8 ports SATA III avec la ProArt Z690 Creator de chez ASUS. En temps normal je serais allé chez Asus mais la Biostar permet de monter sur de la RAM OC 6GHz au lieu de 5GHz et une 60aine d'euros de moins... Et si jamais le deuxième RJ45 me manque il existe des interfaces PCI pour ports M2.

Sachant que je vais me monter une config I9-12900KF + 32GB DDR5, qui (je le souhaite) me durera une dizaine d'années et sera fiable (les BSOD en session prise de son c'est pas du tout possible).

Se faire une configuration pour faire de l’overclocking CPU et RAM, ce n'est pas le meilleur point de départ pour éviter les BSOD et miser sur la fiabilité.

L'overcloking multiplie le budget par 2, pour une performance qui n'est pas du tout multipliée par 2, avec par contre un risque de plantages divers, et de perte de temps à passer pour tout stabiliser au lieu de faire de la MAO. Essayer de prévoir les 10 ans à venir en informatique revient à faire de l'astrologie à la vitesse où ça évolue.

Tu pourrais partir sur une configuration en chipset série B6xx (sans overclocking), CPU non K (fréquence verrouillée), et RAM adaptée, moins rapide et moins cher.

Chez Asus il y a les cartes mères séries TUF Gaming, conçues pour la stabilité et la durabilité, moins axées performance à tout prix.

Si tu as besoin de beaucoup de ports SATA, il faut peut-être passer sur une carte contrôleur dédiée, qui t'apportera plus de possibilité.

Merci pour ta réponse, en revanche la notion d'OC sur la RAM n'a rien à voir avec de l'OC pur et dur. C'est tout simplement au delà des fréquences gérées nativement par le CPU, mais la RAM supporte bel et bien cette fréquence nativement (configuré via profil XMP). Si tu parcours un peu les modèles DDR5 qui existent sur le marché c'est bien les mieux cadencés qui proposent également les CAS les plus faibles, et le combo des deux réduit conséquemment les temps d'accès et donc a une influence directe sur les performances de traitement en temps réel. Il en est de même pour les CPU intels, finalement la fonction "Turbo" est un OC natif qui permet à ces processeurs d'atteindre des fréquences mono-cœur en natif qu'on avait pas vu depuis les Pentium IV ! Très très intéressant pour la MAO... Et puis un OC bien fait ne remet normalement pas en cause la stabilité du système, j'ai un autre PC pour usage perso, i7 6th OC à 42%, jamais un bluescreen, et jamais plus de 72°C. Juste avec les outils ASUS. Je ne compte malgré tout pas utiliser ce type de fonctionnalité pour un usage MAO, ça va de soit.

Pour la carte SATA j'y ai pensé, mais aujourd'hui la quasi totalité des cartes mères n'ont que 3 extensions PCI, or, avec un GPU et ma MOTU PCIe424 il ne m'en reste qu'un, et j'aime bien l'idée de garder un slot de libre pour un usage ultérieur. L'autre alternative serait un adaptateur M2 / SATA, si cela existe (afin de brancher deux graveurs SATA sur un M2). Je n'en ai pas trouvé personnellement mais si quelqu'un en a testé je suis preneur des références.

Enfin, je n'essaye pas de visualiser les évolutions sur 10 ans en informatique, j'ai dit que je voulais un poste qui tendrait une 10aine d'années. J'ai toujours fait comme ça et ça ne m'a jamais posé de souci car j'ai toujours visé des composants de qualité et réputés. Ma station de travail actuelle en double Xeon X5600 a près de 9 ans, j'ai un utltabook qui en a 10 (il se traine lui par contre) et un PC fixe qui en a 13 et tourne toujours mieux que les PC en Celeron d'aujourd'hui (c'était un core 2 quad extreme). Tout ce que je veux dire c'est qu'en prenant soins des composants, en suivant les évolutions et avec un peu d'huile de coude des fois, 10 ans c'est vraiment pas insurmontable, pourvu de ne pas tomber sur du cheap ou de mauvaises pièces.

@Darkmoon donc Biostar on évite ? J'avoue ne jamais avoir vu un de leur produit, dommage sur le papier c'était le modèle le plus adapté à mes recherches.

Bonne journée à tous

dogfacedgremelin

apprendre est une des choses les plus difficile à faire. Alors j'apprends chaque jours.

Deltank

Tu travailles pour Seagate ?

Non, et je n'ai pas écrit qu'une marque est mieux ou moins bien qu'une autre.

Je veux juste que les lecteurs du Topic puissent avoir confiance dans l’objectivité des contenus postés.

Après, chacun à ses habitudes et ses préférences d'achats, et fera ce qu'il voudra.

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

[ Dernière édition du message le 09/02/2022 à 11:21:47 ]

Danbei

Plus gros, ça dissipe mieux la chaleur en général (plus grande surface en contact avec l'air ambiant) ...

Plus gros (en capacité) ça peut être juste "plus dense", non ?

- Dernier truc intéressant : plus les disques sont de capacité élevée, moins ils tombent en panne. Ainsi tous les HDD de 10 To ou moins ont un taux de panne supérieur à 1% tandis que ceux de 12 To ou plus ont un taux inférieur à 1%.

Mais surtout les disques les plus grands sont en moyenne les plus jeunes, age de 33 mois en moyenne pour les 12To ou plus et age de 45 mois en moyenne pour les disques de 10To et moins. Donc la corrélation entre taille est AFR est pas évidente.

Enfin, il faut aussi prendre en compte le fait que plus le disque est gros plus la panne impacte de données.

Deltank

Citation de Deltank :Plus gros, ça dissipe mieux la chaleur en général (plus grande surface en contact avec l'air ambiant) ...

Plus gros (en capacité) ça peut être juste "plus dense", non ?

Oui, tout à fait. Sur des HDD, tu peux avoir le même nombre de plateaux, mais plus denses pour une capacité supérieure à nombre égal de plateaux.

Mais surtout les disques les plus grands sont en moyenne les plus jeunes, age de 33 mois en moyenne pour les 12To ou plus et age de 45 mois en moyenne pour les disques de 10To et moins. Donc la corrélation entre taille est AFR est pas évidente.

J'ai fait la même remarque quelque posts avant.

Il y a un parti pris assez évident dans son analyse...

De toute manière, les études de fiabilité sur des HDD en usage entreprise, c'est intéressant, mais ce n'est pas d'un grand secours pour l'usage privé.

Les gammes de HDD sont différentes entre entreprise et particuliers, et surtout, les firmwares sont optimisés selon l'usage par les constructeurs.

Un particulier qui utiliserait des HDD prévus pour usage entreprise n'aurait pas forcément les mêmes résultats niveau fiabilité, car il ne les utiliseraient pas dans les conditions prévues par le constructeur.

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

[ Dernière édition du message le 09/02/2022 à 13:38:45 ]

Danbei

J'ai fait la même remarque quelque posts avant.

Merci Sarakyel pour le lien, c'est une lecture intéressante.

Sarakyel

Sur le parc de 200000 HDD de Blackblaze, 50% c'est du Seagate (c'est le plus représenté), alors qu'il n'y a que 5% de WD (donc 10 fois moins). De plus, les HDD WD ne sont représentés que sur la moitié de la période d'évaluation, il n'y aucune donnée de fiabilité de Q2 2019 à Q3 2020.

Autant on peut dire que les statistiques Seagate sont pertinentes vu le volume et la représentativité dans le temps, autant pour WD ce n'est pas du tout le cas.

Sauf que comme précisé dans mon post d'origine, je considère Western Digital et HGST comme une seule et même marque, puisque toute l'activité HDD de Hitachi a été rachetée par WD et qu'ils continuent à utiliser les mêmes usines et procédés de fabrication. Ce n'est que depuis 2 ans que la marque HGST a complètement disparu et que les HDD pro ont été re-brandés WD. Mais du coup quand on considère le volume global de disques HGST et WD en service dans les armoires de Blackblaze, et qu'on regarde l'évolution de l'AFR sur les 3 dernières années, j'estime qu'on peut considérer que c'est une quantité de données suffisamment fiable :

Pour info, si les IT de Blackblaze ont décidé de faire une distinction entre WD et HGST, c'était précisément pour évaluer s'il y'avait une différence de fiabilité notable depuis le re-branding (qui peut parfois cacher une baisse de qualité de fabrication et/ou de QC). Comme ce n'est pas le cas pour le moment, j'estime qu'il n'est pas déraisonnable de considérer qu'il s'agit d'un seul et unique fabriquant, et que ses produits "pro" sont plus fiables.

Pour ce qui est du rapport entre capacité et durabilité, l'étude précise que les plus gros HDD sont aussi les plus récents, et qu'ils apparaissent forcément comme plus fiables car les HDD plus petits sont plus vieux, et tombent donc plus en panne en moyenne.

Pas possible de conclure que les plus gros HDD sont plus fiables.

Je ne suis pas non plus d'accord : vu qu'il s'agit d'un taux de panne annualisé, c'est intéressant de constater que même si on exclu les références plus anciennes (disons plus de 2 ans) cette tendance se confirme.

Tu dis "à prendre avec des pincettes" les bonnes stats d'un disque Seagate qui a moins de 18 mois, mais aucune méfiance de ta part pour les stats de tous les disques WD qui n'ont majoritairement pas plus de 15 mois...

Ben non, parce que ces "nouvelles" références WD sont en réalité la prolongation des anciennes références HGST... Donc que ce soit en termes de volume ou de durée, il y'a suffisamment de données pour se faire une idée fiable.

De toute manière, les études de fiabilité sur des HDD en usage entreprise, c'est intéressant, mais ce n'est pas d'un grand secours pour l'usage privé.

Les gammes de HDD sont différentes entre entreprise et particuliers, et surtout, les firmwares sont optimisés selon l'usage par les constructeurs.

Un particulier qui utiliserait des HDD prévus pour usage entreprise n'aurait pas forcément les mêmes résultats niveau fiabilité, car il ne les utiliseraient pas dans les conditions prévues par le constructeur.

Là je suis partiellement d'accord : s'il est vrai que les technos ne sont pas exactement les mêmes, et notamment que la partie optimisation logicielle diffère, pour des raisons de coût il est avantageux pour les usines de mutualiser au maximum les procédés de fabrication et les processus de contrôle (qu'ils soient humains ou automatisés). Dans de nombreux domaines (dont l'informatique, mais aussi l'audio), il existe une corrélation claire entre la fiabilité des produits haut de gamme et celle des produits d'entrée de gamme.

Bref, quand un fabricant n'arrive pas à fournir à ses clients professionels des produits avec un taux de panne annualisé inférieur à 1%, il est raisonnable de se méfier d'autant plus de ses produits à destination du marché particulier.

Maintenant c'est vrai que ce n'est pas parce qu'un fabriquant propose des produits très fiables à sa clientèle pro qu'il aura pas forcément le même niveau de fiabilité sur ses gammes grand public, mais il n'est pas déraisonnable de supposer que ce sera tout de même mieux que le concurrent déjà à la ramasse sur le marché pro. Et malheureusement il n'existe pas de sources fiables concernant l'AFR des HDD Seagate et WD vendus par les grosses plateformes en ligne type Amazon, mais de ce que j'entends de la part des fournisseurs avec lesquels je bosse, ça confirme les données publiées par Blackblaze (j'ai même entendu parler de taux de panne supérieur à 5% sur les séries IronWolf a destination des NAS grand public, mais j'ai quand même de gros doutes parce que ça ne serait pas viable industriellement).

Tu travailles pour WD ?

Non, pour ce qui est des HDD j'ai longtemps été pro-Samsung, mais leur division hard drives a été revendue en 2011 à... Seagate. Comme quoi !

[ Dernière édition du message le 09/02/2022 à 16:40:06 ]

Danbei

Citation de Deltank :Pour ce qui est du rapport entre capacité et durabilité, l'étude précise que les plus gros HDD sont aussi les plus récents, et qu'ils apparaissent forcément comme plus fiables car les HDD plus petits sont plus vieux, et tombent donc plus en panne en moyenne.

Pas possible de conclure que les plus gros HDD sont plus fiables.

Je ne suis pas non plus d'accord : vu qu'il s'agit d'un taux de panne annualisé

- Les pannes n'arrivent pas à la même probabilité dans tout le cycle de vie du HDD, il faut donc comparer le AFR pendant une même portion du cycle de vie, ce qui n'est pas le cas ici.

- Une autre hypothèse serait que les constructeurs améliorent progressivement la fiabilité de leur HDD et donc que les disques plus récents soient plus fiables indépendamment de leur taille. Cette hypothèse n'est pas non plus justifié par ces stats en question, en fait ces résultats ne permettent tout simplement pas de conclure.

c'est intéressant de constater que même si on exclu les références plus anciennes (disons plus de 2 ans) cette tendance se confirme.

Je corrige un erreur que j'ai fais dans l'autre post :

Mais surtout les disques les plus grands sont en moyenne les plus jeunes, age moyen de 33 moisen moyenneau maximum pour les 12To ou plus et age moyen de 45 moisen moyenneau minimum pour les disques de 10To et moins. Donc la corrélation entre taille est AFR est pas évidente.

[ Dernière édition du message le 09/02/2022 à 17:30:21 ]

Sarakyel

Tu regarde quelles données pour dire ça ?

Les bilans des années précédentes, qui sont tous consultables depuis le lien donné en fin d'article, et qui permettent de voir l'AFR pour les premiers mois des modèles maintenant vieillissants. Tu peux même faire mumuse avec un CSV qui récap toutes les données de toutes les années. Et la conclusion de cette analyse est écrite

What’s behind the 1.01% for 2021? Large drives

[...]

The AFR for larger drives, defined here as 12TB, 14TB, and 16TB drives, are all below the 2021 AFR of 1.01% for all drives. The larger drives [...] total 66% of the drive days total, while only producing 57% of the drive failures.

Combiné à des indices de confiance assez élevés dans les données concernant la plupart de ces gros disques... Perso je trouve ça suffisamment convaincant. Mais visiblement je suis moins difficile à convaincre que toi !

Deltank

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

dogfacedgremelin

Vous n'utilisez pas d'outils pour faire vos Windows "MAO" directement ?

Zéro réponse. j’en conclus que vous ne trouvez pas plus simple d’agir des le départ sur l’installation de vos Windows mais que vous faite le ménage après coup ? Ou c’est un sujet qui ne vous intéresse pas en terme d’optimisation de vos machines.

apprendre est une des choses les plus difficile à faire. Alors j'apprends chaque jours.

Darkmoon

Citation de dogfacedgremelin :Vous n'utilisez pas d'outils pour faire vos Windows "MAO" directement ?

Zéro réponse. j’en conclus que vous ne trouvez pas plus simple d’agir des le départ sur l’installation de vos Windows mais que vous faite le ménage après coup ? Ou c’est un sujet qui ne vous intéresse pas en terme d’optimisation de vos machines.

J'ai déjà abordé le sujet quelquefois, concernant ntLite, ou encore AME (Windows 10 Ameliorated). Là je dois quitter, mais je vais développer à mon retour.

Mais bon, le principal « problème », c'est que les temps ont changé depuis W10.

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Darkmoon

Donc comme je disais, les temps ont changé.

Mais, comme je l’ai déjà raconté à quelques reprises ici, sauf à ne pas vouloir être connecté au net, c’est maintenant devenu pratiquement inutile. Parce que W10 est devenu comme les OS des smartphones, c’est à dire un OS « mouvant » en perpétuelle évolution et peu importe ce qu’on installe à la base (OS modifié), soit il se mets à jour (et c’est une véritable galère de tenter de bloquer/désactiver ces dernières

J’ai fait plusieurs tentatives et expérimentations ces quatre dernières années. Le seul moyen ou j’ai réussi (à me concocter un Windows 10 personnalisé et stable), c’est en utilisant une image (du DVD OEM qui venait à l’achat de mon 8700K) d’une vieille version de W10, soit la V1709 (« Redstone 3 »/« Fall Creator update ») datant du 17 octobre 2017. En bossant sur cette dernière et en utilisant NTLite, il est possible de virer tout plein de truc inutile (Cortona, Wupdate, Xbox, etc, etc) et, du même coup, de préconfigurer plein de trucs. Sauf que ça implique de ne pas le connecter au net puisque l’OS n’est plus du tout sécurisé et ça implique que l’OS ne sera plus jamais mis à jour (de par le retrait de Wupdate). Conséquemment, il y a certains pilotes (qui se téléchargent via Wupdate habituellement) qui ne peuvent s’installer automatiquement (clavier MIDI, disque externe, interface audio, etc.). Du coup, faut s’y connaître, posséder un autre PC sous W10 (non trafiqué!), installer ces périphériques sur ce dernier, récupérer les fichiers (.cat, .ini, . inf, .sys, .dll) et les installer manuellement sur l’autre sous W10 « charcuté ».

J’ai tenté dernièrement de faire la même chose avec la plus récente image de W10 qui était dispo sur le site de Microsoft (au printemps) et là, ça a été bcp plus difficile et problématique. Au fil des mises à jour, depuis la sortie initiale de W10 (et depuis la V1709), l’OS s’imbrique tjrs plus profondément avec Edge*, entre autres, et tout plein d’autres trucs.

Autrement dit, les utilitaires comme NTLite demeurent utile pour configurer « normalement » (certaines préférences basiques, autorisations, activation, etc.) W10 dans le cadre d’un grand parc informatique où nous avons plusieurs dizaines de postes à installer, mais si c’est pour désactiver/retirer des trucs, dont Microsoft s’efforce d’imbriquer au cœur de l’OS et fait exprès d’empêcher leur désactivation, c’est pratiquement devenu impossible.

Bref, c’est pourquoi que, pour l’instant, sous mon 8700K (encore suffisamment performant pour ce que je fais), je suis revenu sous W7 (non sans difficulté, car les Coffee Lake/8e Gen — et plus récent — et les CM associées ne sont, en théorie, plus compatible avec W7... ...mais me suis débrouillé!

Sinon, comme je l’ai déjà partagé, quand on a pas de besoin ultra spécifique, de toute façon il n’y a plus grand-chose à configurer ou « tweaker » sur W7, W8 et W10 pour faire de la MAO de façon confortable avec la puissance des PC de nos jours.

Essentiellement choisir « Performances élevées » dans les options d’alimentation et désactiver toutes les options d’économie d’énergie. Ainsi que décocher « Autoriser l’ordinateur à éteindre ce périphérique » pour les contrôleurs USB dans le gestionnaire de périphérique sous l’onglet « Controleurs de bus USB ». Et exclure certains dossiers (samples, banques, dossier de projet du DAW) pour le scan de WDefender. C’est pratiquement tout ce qui importe et ce qui a le plus d’incidence, de nos jours (bien sûr, sans compter le fait de désactiver tout antivirus/logiciel tiers qui tourne en backround lorsque l’on bosse dans le DAW, mais ça ne concerne pas l’OS en tant que tel).

Et bon, faire ça (performances élevées, décocher « éteindre USB » et les exclusions Defender) lors d’une réinstallation, ça prend quoi? 10 minutes?

Ça ne vaut donc pas la peine àma de se créer une image préconfigurée juste pour ça (à moins d’avoir un parc informatique de plusieurs PC à installer).

Ça ne vaut donc pas la peine àma de se créer une image préconfigurée juste pour ça (à moins d’avoir un parc informatique de plusieurs PC à installer).*De nos jours, certains DAW (et autres soft), comme Studio One et FL Studio, entre autres, utilisent maintenant certaines fonctionnalités de Edge afin de « communiquer » et de « s'activer » et/ou pour télécharger des updates.

Conclusion : modifier~personnaliser Windows (depuis W10), cette époque est révolue et terminé!

...où alors c'est au prix de multiples essais/erreurs (création d’images/modification sur installation « live ») qui prendrons quelque semaines de boulot à tout réinstaller ses DAW et plugins pour voir si tout fonctionne bien chaque fois qu'on tente de modifier « l'image système »... ...sans compter les failles de sécurisé impliqué, donc de ne pas connecter le PC au net.

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Snowfall

Pour être honnête, je ne suis même pas sûr d'avoir gagné en performances. Un CPU plus récent et sans optimiser Windows 10/11, ma main à couper que ça passe sur la plupart des projets.

[ Dernière édition du message le 10/02/2022 à 07:42:54 ]

dogfacedgremelin

apprendre est une des choses les plus difficile à faire. Alors j'apprends chaque jours.

Sarakyel

Pour être honnête, je ne suis même pas sûr d'avoir gagné en performances. Un CPU plus récent et sans optimiser Windows 10/11, ma main à couper que ça passe sur la plupart des projets.

Exactement.

Se faire un windows "lite" pour la MAO, ça avait du sens à l'époque où les CPU n'avaient qu'un seul core/thread et toute la RAM n'avait qu'un unique canal de communication avec le CPU. C'était la galère, parce que toutes les applis devaient faire la queue pour se réserver un bout de mémoire puis se marchaient sur les pieds pour avoir droit à une fraction de la puissance de calcul disponible. Rien que pour ça, même avec un gros CPU et beaucoup de RAM, jusqu'à Windows Vista ça valait le coup de désactiver un maximum de services en arrière plan et de forcer la priorité de certaines applications gourmandes.

Depuis une grosse dizaine d'année, tous les processeurs sont multi-threadés, toutes les barrettes de mémoire vive disposent d'au moins deux canaux, et la largeur de la bande passante entre tous ces composants ne cesse d'augmenter. Windows a évolé en conséquence et dispose d'une bien meilleure gestion des ressources, avec un système de priorisation des tâches de plus en plus performant, mais aussi des fonctionnalités de mise en sommeil des processus non-cruciaux héritées du développement mobile.

Même les p'tites astuces données par Darkmoon ci dessus (performances élevées, suspension sélective des périphs USB, exclusions Defender), sur le matos récent je ne suis pas certain qu'elles fassent encore une différence. Typiquement le coup du niveau de performance n'impacte guère plus que les GPU, et seuls les appareils USB les plus anciens peuvent encore avoir des soucis liés à la gestion automatisée de leur alimentation (malheureusement je crois que c'est le cas des iLoks, donc rien que pour ça...).

Bref, AME et autres Windows Lites c'est cool quand on veut éviter d'envoyer nos mensurations aux AMAMA (et oui, Apple Meta Alphabet Microsoft Amazon, faut arrêter de parler de GAFAM non ?), mais pour la MAO je ne pense pas qu'il y ait encore un gros intérêt.

Darkmoon

Pour être honnête, je ne suis même pas sûr d’avoir gagné en performances. Un CPU plus récent et sans optimiser Windows 10/11, ma main à couper que ça passe sur la plupart des projets.

Oui (mais c'est un truisme!!). Mais il est important de préciser une chose ici : ce n’est pas que mes quelques conseils de « tweak » n’ont pas d’effets (et/ou ne sont plus utile), c’est surtout — pour le cas spécifique que tu partages — que seulement passer d’un Windows antérieur (W7, etc.) à W10 (ou W11) — pour une même « vieille bécane » — ne fait en fait qu’alourdir les charges et ressources nécessaire par le « nouveau » OS tout en conservant la même capacité de traitement, à cause du même CPU.

Donc, oui, naturellement que de changer pour un CPU plus puissant aura bcp plus d’impact sur tes perfs que de simplement changer d’OS (même s’il est censé mieux gérer les ressources)!

C’est tout à fait normal!

Idem avec les « tweak » : passer d’un 4770K de 4e génération à 4 core @3.9GHz turbo à un proco récent comme, P. Ex., un i9 12900K de 12e génération à 16 core @ plus de 5GHz turbo (avec les autres composants en adéquation : RAM, CM, etc.) sera « le jour et la nuit », même sans aucun « tweak » VS ton 4770K « tweaké ». Mais bon, faut comparer des pomme avec des pommes et des oranges avec des oranges.

...Par contre, entre deux utilisateurs possédant un même PC à base d’un i9 12900K, celui qui bosse, P. Ex., en « performances élevées » obtiendra de meilleures perfs que celui qui bossera en mode « normal » ou « économie d’énergie ». En basse latence sous un gros projet, ça sera immédiatement perceptible puisque'en mode « économie » le processeur ne bosse pas à plein régime (GHz). C'est on ne peut plus factuel et vérifiable!

Mais si l’on parle juste d’OS, les plus récents consomment plus de ressources (même si censé mieux les gérer)! Et ça, je n’en démords pas, car tous les tests que j’ai effectués me le démontrent. Même avec mon « pas si vieux que ça » 8700K, je réussis (avec toute mes connaissances et mon expérience dans le domaine) à exploiter de façon plus performante W7 que W10. Concrètement, ça se traduit par aucun glitch à 64smp avec W7 alors que j’en ai quelques'un, de façon sporadique, avec W10 (pour le même PC, même interface audio, etc.).

Se faire un windows "lite" pour la MAO, ça avait du sens à l’époque où les CPU n’avaient qu’un seul core/thread [...]

Bon, l’on va peut-être me reprocher de vouloir être « trop précis » et/ou d’enculer les mouches, mais, bien qu’étant d’accord sur l’idée générale de fond (« c’était nécessaire avant, bcp moin de nos jour »), je persiste à affirmer que jusqu’à W7 (et jusqu’aux processeurs Skylake de 6e Gen, de série « 6000 », P. E.x), il était encore utile de tweaker l’OS, au sens où, si l’on avait les connaissances, il était tout à fait possible de gagner en ressources processeur. Pas tant pour les jeux ou autres, mais en MAO, P. Ex, ça pouvait se traduire par pouvoir passer d’un buffer de 128smp à 64smp ou 32smp sans glitch VS avec quelques glitch sans optimisations. Donc, oui, je suis d’accord, mais cela a persisté quand même bcp plus longtemps qu’à l’apparition des premiers « Dual Core ».

D’ailleurs, il y a quelques mois, j’avais posté ici un exemple du nombre de « process » qu’il y avait, tout juste après le boot de l’un de mes PC sous W10 VS du nombre d’un autre sous W7. Des dizaines de plus pour W10!

Bref, ce qui est utile en MAO (outre les perfs élevées = GHz au max), de par la spécificité de l’exploitation du « temps réel », ce n’est pas tant de pouvoir « modifier » Windows que d’être en mesure de lui « ordonner » de ne rien faire, en tâche de fond, lorsque l’on bosse dans le DAW en basse latence. Le problème avec W10 (et les suivants), c’est que ce n’est plus possible! Microsoft limite maintenant ce que nous pouvons désactiver! Il est maintenant impossible de désactiver certains trucs de télémétrie, certains « diagnostiques » et autres « processus » qui peuvent démarrer quand bon leur semble en tâche de fond. Pour 99% des usages courants (même pour le montage vidéo, etc.), ça ne pose aucun problème, mais dès qu’on bosse en 64smp ou moins (via une interface USB), la moindre instruction/requête mémoire/disque peut créer un minuscule glitch, de façon sporadique, mais juste assez pour emmerder quand l'on s’enregistre, P. Ex.

Sinon, oui, plusieurs utilitaires existent pour W10 (pour désactiver temporairement la télémétrie, WUpdate, etc.), mais c’est une galère à gérer (je les ai tous essayés) et à maintenir puisqu’à chaque mise à jour, tout est à revérifier/refaire. Même certains trucs que l’on désactive dans le planificateur des tâches se réactivent parfois lors d’une mise à jour. Bref, c'est la merde!

C’est d’ailleurs fort probablement précisément pourquoi Intel a « choisi » d’aller dans une direction spécifique avec sa nouvelle génération de processeur en déclinant maintenant deux types de « core » au sein d'un même processeur, à savoir les « Performance Core », dédiés au tâche lourdes de l’utilisateur VS les « Efficiency Core » dédiées aux tâches de fond que nécessite l’OS.

L’on peut voir la chose de deux façons :

- la première comme une « avancée » qui permet de « résoudre » le problème des tâches de fond tjrs plus nombreuses requises par les nouveaux OS, tout comme passer d’un seul core à plusieurs core l’avait été à l’époque.

- ou, la deuxième, comme moi, qui n’aime pas trop cette nouvelle direction, considérer que pendant qu’on (Intel) s’efforce de « compenser » pour pallier aux ressources tjrs grandissantes que nécessite ces nouveaux « OS en perpétuelle mutation qui ne laissent plus le total contrôle aux utilisateurs avancés »,...ben l’on se retrouve, au lieu d’avoir encore plus de core pouvant tous bosser au max de GHz, ben avec plus de core, mais dont certains fonctionnent à plus bas régime, car dédiés exclusivement à faire tourner l’OS.

Bref, à mon sens, si Microsoft n’avait pas pris cette direction (intrusive et limitante pour les utilisateurs avancés, ou rien ne peut être désactivé), Intel n’aurait pas eu besoin d’aller dans cette direction. Bon, ok, en pratique, c’est optimisé (selon les premières review et tests) pour W11 et ça produit de « meilleures perfs », oui, mais probablement que cela aurait été encore mieux/plus (en terme de gain de perfs) s’il n’avait (Intel) pas été obligé de prendre cette « direction » (dédié des core aux tâches de fond). Mais bon, ça, c’est mon avis perso « de geek » et ça peut se discuter~débattre!

Même les p’tites astuces données par Darkmoon ci dessus (performances élevées, suspension sélective des périphs USB, exclusions Defender), sur le matos récent je ne suis pas certain qu’elles fassent encore une différence

Là, désolé, mais tu te trompes. Je suis le premier à dire que tous les autres « tweak » ne sont plus vraiment nécessaires, mais passer à « performances élevées » a encore bcp d’impact! ...quand on bosse en basse latence (64smp ou moins) dans un DAW! Ne me crois pas sur parole, essaie-le! Mets-toi en mode « normale » ou « économie », ouvre un gros projet dans ton DAW et tu verras si tout se passe encore bien, sans problème.

Et pour les exclusions de Defender, ce n’est pas juste utile en MAO, plusieurs utilisateurs (sur divers forum ici et là) se plaignent d’un « lag » parfois (si ce n’est qu’en utilisation standard, en ouvrant simplement des fenêtres en voulant accéder à des fichiers) et la cause c’est parce que Defender doit alors scanner les fichiers du dossier. Pour la suspension sélective USB (dans les options d’alimentation) et l’autorisation d’éteindre les contrôleurs (dans le gestionnaire de périph), c’est moins fréquent comme problème (en théorie l’OS devrait être « intelligent et ne pas suspendre un périphérique en cours d’utilisation), mais il arrive parfois, pendant un certain temps de pose (qui fait croire que ce n’est pas utilisé) que ça puisse créer des problèmes. De toute façon absolument tous les constructeurs d’interface audio (et éditeurs de DAW) recommandent de paramétrer ces quelques paramètres, surtout les performances élevées!

Ce qui n’est plus vraiment utile, c’est toutes les autres « pseudo-astuces », comme de toucher à la mémoire virtuelle, la priorité des différents core, la base de registre, etc., etc.

"Si t'enregistres à Poudlard, avec l'ingé son Dumbledore, les lois physiques tu peux t'en foutre. Mais dans l'monde réel, les lois physiques, les mesures, le dBFS, tout ça existe bel et bien." youtou

Sarakyel

dogfacedgremelin

Du coup, j'ai totalement basculé en ce qui concerne la M.A.O sur MacOS malgré les contraintes de ce système m'impose (je ne retrouve pas l’expérience utilisateur de Win10) mais forcé de constater que ça marche vraiment bien même sur hack.

du reste le i9 12900 + Z690 (j'ai volontairement pas mis le K puisque le 1% de différence permet une ventilation plus soft avec ses 65W de TDP un ventilo qui absorbe 240W sera quasi en mode fanless en tournant au minimum la plupart du temps) fera AMHA un très bon hack et probablement le dernier sur intel (sans y passer des nuits blanche).

apprendre est une des choses les plus difficile à faire. Alors j'apprends chaque jours.

Deltank

Mais est-ce encore nécessaire aujourd'hui ?

Est-ce que le temps passé à faire de l'informatique au lieu de faire de la musique en vaut la peine ?

Je ne crois pas, d'autant plus quand je lis tous vos retours sur le sujet.

"Le monde se divise en deux catégories : ceux qui passent par la porte, et ceux qui passent par la fenêtre." (Tuco)

[ Dernière édition du message le 10/02/2022 à 15:32:43 ]

Eric Music Strasbourg

parce que oui je suis certains que l'on peut gagner énormément et de plus en plus entre linux et windows mais en même temps j'ai l'impression que tout n'est pas compatible.

ce qui m'énerve sur windows au delà des performances moins élevées c'est par exemple que l'on ne puisse ^pas utiliser des driver roland boutique en même temps que les driver asio de l'uad. depuis le temps que apple sait faire y a quand même un manque d’intérêt visible de la part de microsoft d'améliorer ce genre de point qui est vraiment pénible.

Eric

- < Liste des sujets

- Charte