Pseudo-sciences et zététique, avez vous un avis debunké ?

- 4 770 réponses

- 111 participants

- 195 494 vues

- 100 followers

Traumax

J'inaugure avec une émission appelée a entrer dans la légende de la zetetique, l'interview de jacques grimaud par la TeB :

Le rat taupe nu !

iktomi

C'est aussi vain que de me répondre "non car l'un c'est du texte et l'autre des images !"

En ce qui me concerne je vois de plus en plus de gens découvrir ces outils, et en avoir peur (ce sont souvent des personnes avec un bagage scientifique ou informatique plutôt humble). Je pense que les aider à comprendre comment ça fonctionne et leurs limites peut aider à mieux appréhender ces sujets. (et les désacraliser aussi un peu)

Tes formules, je suis pas certain...

[ Dernière édition du message le 17/01/2023 à 08:45:00 ]

miles1981

Non mais dans les grandes lignes, évidemment que ça ne fonctionne pas strictement pareil. (tu as saisis que je m'adressait aux personnes qui ne connaissent rien de ces sujets ?)

C'est aussi vain que de me répondre "non car l'un c'est du texte et l'autre des images !"

En ce qui me concerne je vois de plus en plus de gens découvrir ces outils, et en avoir peur (ce sont souvent des personnes avec un bagage scientifique ou informatique plutôt humble). Je pense que les aider à comprendre comment ça fonctionne et leurs limites peut aider à mieux appréhender ces sujets. (et les désacraliser aussi un peu)

Tes formules, je suis pas certain...

Justement, c'est important de bien dire les choses, d'etre precis. Il y a des subtilites, meme si je suis d'accord avec 95% de ton message. Je vois meme des gens avec un gros bagage scientifique qui pretendent que ca leur repond et que ca permet de faire des recherches parce qu'ils ne comprennent pas la dependance temporelle du modele.

Les formules sont correctes, un reseau tel que chatgpt a une dependance temporelle (type LSTM) sur les precedents (qui sont aussi du coup des sorties precedentes), meme si l'entrainement reste un modele forward pur (pusiqu'on ne sait pas entrainer un modele non forward).

Audio Toolkit: http://www.audio-tk.com/

Will Zégal

En ce qui me concerne je vois de plus en plus de gens découvrir ces outils, et en avoir peur (ce sont souvent des personnes avec un bagage scientifique ou informatique plutôt humble). Je pense que les aider à comprendre comment ça fonctionne et leurs limites peut aider à mieux appréhender ces sujets. (et les désacraliser aussi un peu)

Les gens ont raison d'en avoir peur : comme l'automatisation et la robotisation, ça va flinguer un paquet d'emplois. Sauf qu'au lieu que ça soit du travail manuel qui va passer à la trappe, ça va être du travail dit intellectuel.

Je vois meme des gens avec un gros bagage scientifique qui pretendent que ca leur repond et que ca permet de faire des recherches parce qu'ils ne comprennent pas la dependance temporelle du modele.

Je ne comprends pas cette notion de dépendance temporelle (je ne la connais pas, plus exactement). Est-ce ce que ça concerne le fait que les données d'apprentissage sont antérieures à une date donnée et que donc l'engin exclus tout ce qui est récent ? Ou rien à voir ?

En tous cas, que des gens fassent des recherches avec est assez flippant. Enfin, je ne sais pas de quelles recherches on parle, mais dans les différentes vidéos que j'ai vu sur ChatGPT, il est capable de sortir des énormités avec un formidable aplomb. Du coup, ce qu'il sort est à prendre avec beaucoup de pincettes.

D'après ce que j'ai compris, c'est une sorte de beta, un truc en phase de test grandeur nature. Pas un produit supposé fini.

Si on s'en sert comme secrétaire pour lui faire écrire une lettre ou comme codeurs pour lui faire pisser du code (sur des systèmes pas sensibles), ça va. Si la lettre comporte de la merde, on le verra tout de suite. Si le code est foireux (apparemment, il s'en sort plutôt bien), ça va vite se voir aussi.

Mais si on compte dessus pour s'abstenir de chercher soi-même des informations solides de fiables sans prendre le temps de vérifier derrière ce qu'il sort, là ça me semble très casse-gueule.

D'ailleurs, le truc ne se prétend pas (à ma connaissance) être une ressource de savoir, mais un agent conversationnel, comme son nom l'indique. Bref, il est fait pour discuter avec une personne de la façon la plus naturelle et crédible possible. Pas pour remplacer un labo de recherche ou un service documentaire sur des domaines pointus.

miles1981

Citation :Je vois meme des gens avec un gros bagage scientifique qui pretendent que ca leur repond et que ca permet de faire des recherches parce qu'ils ne comprennent pas la dependance temporelle du modele.

Je ne comprends pas cette notion de dépendance temporelle (je ne la connais pas, plus exactement). Est-ce ce que ça concerne le fait que les données d'apprentissage sont antérieures à une date donnée et que donc l'engin exclus tout ce qui est récent ? Ou rien à voir ?

En tous cas, que des gens fassent des recherches avec est assez flippant. Enfin, je ne sais pas de quelles recherches on parle, mais dans les différentes vidéos que j'ai vu sur ChatGPT, il est capable de sortir des énormités avec un formidable aplomb. Du coup, ce qu'il sort est à prendre avec beaucoup de pincettes.

D'après ce que j'ai compris, c'est une sorte de beta, un truc en phase de test grandeur nature. Pas un produit supposé fini.

Si on s'en sert comme secrétaire pour lui faire écrire une lettre ou comme codeurs pour lui faire pisser du code (sur des systèmes pas sensibles), ça va. Si la lettre comporte de la merde, on le verra tout de suite. Si le code est foireux (apparemment, il s'en sort plutôt bien), ça va vite se voir aussi.

Mais si on compte dessus pour s'abstenir de chercher soi-même des informations solides de fiables sans prendre le temps de vérifier derrière ce qu'il sort, là ça me semble très casse-gueule.

D'ailleurs, le truc ne se prétend pas (à ma connaissance) être une ressource de savoir, mais un agent conversationnel, comme son nom l'indique. Bref, il est fait pour discuter avec une personne de la façon la plus naturelle et crédible possible. Pas pour remplacer un labo de recherche ou un service documentaire sur des domaines pointus.

La dependance temporelle vient du fait qu'on injecte au reseau de neurones les valeurs precedentes une par une. A chaque fois qu'on injecte une nouvelle valeur, c'est un pas de temps. Et a la fin de l'injection du "prompt", on recupere une nouvelle valeur, qu'on reinjecte en entree pour avoir la suivante.

C'est pour ca que c'est un modele qui ne peut pas faire de recherche, mais certains pensent que ca marche. Et ca peut etre le cas pour des faits tres connus qui sont bien documentes, mais des qu'on part sur des choses peut connues et peu rencontrees, on va partir dans les hallucinations, il invente meme des publis pour des personnes connues.

Pas pour rien que des etudiants l'ont utilise pour des dissertations

Audio Toolkit: http://www.audio-tk.com/

Will Zégal

Au final, je trouve que ça ouvre une question assez intéressante : notre dépendance aux outils numériques et les conséquences des limites de leur fiabilité.

Je ne sais pas pourquoi, ça me rappelle un voyage en Espagne où le GPS racontait n'importe quoi. Dans une ville notamment, il avait X fois tenté de nous faire passer en voiture... par des escaliers.

Il nous aurait fait tourner dingos si au lieu d'être en vacances, pas pressés ni stressés, on avait été à la bourre pour un rendez-vous important ou limites pour prendre un avion ou un train.

Là, ça nous a bien fait marrer.

Mais j'ai déjà entendu parler d'accidents de gens qui avaient un peu trop aveuglément suivi leur GPS et avaient fini dans des ports au même (sous réserve) tombés d'une falaise.

Chez moi, Google Maps persiste à signaler comme trajet possible la traversée d'un site militaro-industriel avec des barrières et badges d'accès.

miles1981

Au final, je trouve que ça ouvre une question assez intéressante : notre dépendance aux outils numériques et les conséquences des limites de leur fiabilité.

J'ai eu le souci a Nouvel An. J'ai aussi fait confiance a Google Maps pour rejoindre ma copine en prenant un bus a l'aeroport. Ben Google m'a envoye dans une autre ville... Je ne m'en suis rendu compte que dans le bus...

Audio Toolkit: http://www.audio-tk.com/

Will Zégal

ça, c'est arrivé deux fois à ma douce : on allait quelque part en voiture, mais elle a rentré l'adresse (rue ou lieu dit)... sans faire gaffe à la ville.

Bon, dans un cas (rue), on s'est retrouvés à 1,5 km de notre destination. Pas méchant.

Dans l'autre (lieu dit), on s'est retrouvés dans la pampa après 40 bonnes minutes de route, à téléphoner à la personne chez qui on allait et dont la description de l'environnement ne disait absolument rien pour nous guider (tu m'étonnes !), tout ça avec les diificultés d'un réseau bien foireux. Pour finalement se rendre compte de l'erreur et refaire près d'une demi-heure de route pour aller au bon endroit qui était... à 1/4 d'heure de chez nous.

Il va sans dire que je contrôle un peu plus désormais quand c'est elle qui met le GPS.

Attention : je ne dis pas que c'était la même chose dans ton cas. Google peut être un peu farceur, en effet. Je me demande ce qui arrivait aux gens qui ne sont pas du coin qui essayent de passer par l'arsenal évoqué plus haut

Arrivait parce que j'ai vérifié et ils ont enfin corrigé le tir. Par contre, il font passer en voiture par un autre endroit fermé par un portail, pourtant bien visible sur streat view.

miles1981

En fait, les bus qui etaient sur Google Maps n'allaient pas la ou Google Maps le disait au moment prevu, ni la bonne ligne. Apparemment en dehors des tres grandes villes, c'est de la m***e.

Audio Toolkit: http://www.audio-tk.com/

Anonyme

Citation de Will Zégal :on allait quelque part en voiture, mais elle a rentré l'adresse (rue ou lieu dit)... sans faire gaffe à la ville.

Ça peut arriver aussi quand tu écries la bonne ville mais pas le bon pays. Vienne dans le Rhône ou Valence en Espagne. Versailles (Kentucky, Missouri, Ohio, Indiana et Illinois). Brest, en Biélorussie...

Projacks

Ceux qui déplacent des montagnes... font chier les cartographes.

[ Dernière édition du message le 18/01/2023 à 09:06:57 ]

Will Zégal

Enfin, je dis ça, je ne l'ai pas essayé. J'ai quand même l'impression, d'après les vidéos que j'ai vues qu'il est presque aussi long de lui donner des instructions précises que de le faire soi-même.

Exemple : quelqu'un qui sait qu'il a des problèmes d'orthographe / grammaire va peut-être lui faire écrire un mail ou une lettre de motivation. Mais il ne sera pas forcément capable de voir si chatGPT fait des fautes. Donc ne le corrigera pas.

En plus, j'imagine qu'il base son apprentissage sur la masse. Or, la masse est plus ignorante que les spécialistes.

Du coup, si t'as une majorité de gens qui disent que, au pif, le soleil tourne autour de la terre, que va considérer ChatGPT ?

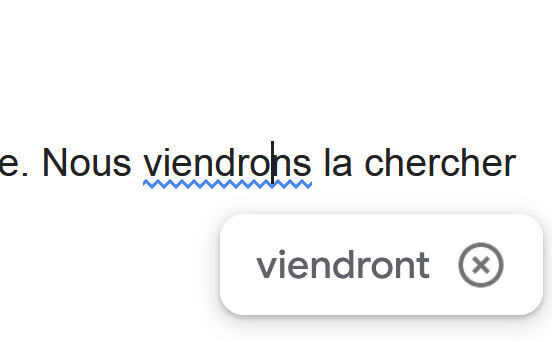

J'ai pris l'exemple basique du mail ou du courrier parce qu'hier, Google mail m'a fait ça :

Le pire, c'est que ça m'a foutu le doute au point que je suis allé vérifier.

Edit : j'avais posté ça dans "les images qui tordent". Commentaire

Pour Google, c'est une IA, donc la règle est déduite de la majorité des données analysées sur le web. Si une majorité écrit "nous viendront", alors la règle devient "nous viendront"...

Bref, l'orthographe devient démocratique...

...Vive l'ortografe!

[ Dernière édition du message le 18/01/2023 à 10:43:27 ]

miles1981

A l'heure actuelle les possibles problèmes de fiabilité de GPT sont normaux, une IA ça doit apprendre (et être nourris donc), ça n'a pas la science infuse, c'est d'ailleur le principe de la chose, c'est de "l'apprentissage artificiel". Dans le cas de GPT qui est un modèle conversationnel, ce qu'il se passe c'est que si il se trompe, comme on peu lui répondre et le corriger, lui va être capable de prendre en compte les réponses qui lui sont données et apprendre pour ne plus se tromper. C'est tout l'intérêt de la mise à disposition au grand public en ce moment, entraîner l'IA de manière bien plus massive que ce qui aurait pu être possible en labo.

Lol. Le principe meme de chatgpt fait que cela ne pourra jamais etre un modele de recherche de quoique ce soit.

Audio Toolkit: http://www.audio-tk.com/

miles1981

Encore faut-il que les gens le corrigent. Parce que j'imagine que les gens l'utilisent massivement pour des trucs qu'ils ne savent pas faire.

Enfin, je dis ça, je ne l'ai pas essayé. J'ai quand même l'impression, d'après les vidéos que j'ai vues qu'il est presque aussi long de lui donner des instructions précises que de le faire soi-même.

Et en plus, il faudrait enlever de son apprentissage les erreurs passees, ce qui n'est pas possible ! Bref, c'est une mecomprehension profonde du machine learning que de croire qu'on peut corriger correctement un tel modele.

Audio Toolkit: http://www.audio-tk.com/

Anonyme

Dr Pouet

C’est plutôt bien expliqué ici :

Anonyme

miles1981

Non mais ChatGPT, c’est juste de la complétion automatique de texte. Du genre : après « telle série de 5 mots », on peut mettre tel morceau de phrase, le tout basé sur ce qu’on trouve sur une sélection du net (exemple : Wikipédia). Mais du coup, si la forme est bonne, et bluffante, comme le sens n’a pas vraiment d’importance, c’est assez voué à l’échec.

C'est ce que j'ai dit :D

Audio Toolkit: http://www.audio-tk.com/

iktomi

Gronoeil Vert

Tamen pax et amor, oscula.

iktomi

Et j'ai apprécié qu'Elizabeth reprenne (dans le feutré) les propos d'Olivier sur l'anti-science des pseudo-sciences : Ils se présentent bel et bien comme une "science", mais elle-même alternative, avec de l'empirisme à tout va, du témoignage personnel, des prétendues rouages physiques indétectables, et aujourd'hui du quantique de partout (avant d'aller se réfugier dans de l'encore plus petit quand ce sujet deviendra mieux maitrisé par le public).

[ Dernière édition du message le 28/01/2023 à 11:28:49 ]

Gronoeil Vert

J’attends la suite avec impatience.

Tamen pax et amor, oscula.

iktomi

Et en plus, il faudrait enlever de son apprentissage les erreurs passees, ce qui n'est pas possible ! Bref, c'est une mecomprehension profonde du machine learning que de croire qu'on peut corriger correctement un tel modele.

C'est ce que les devs sur Stable Diffusion font en permanence.

Le modèle change continuellement de version, 1.4, 1.5, 2.0, 2.1... avec chacun des variants de tensors, et des fix... Je ne vois pas où est l'obstacle.

Cela reviendrait à dire qu'une fois un modèle créé, non seulement il n'est pas modifiable ou remplaçable (quitte à lui faire réapprendre de zéro après correction), mais qu'en plus on est obligé de continuer à l'utiliser, ou alors bazarder tout le logiciel ?

Soit il y a un soucis d'emploi des termes, soit on parle pas du tout de la même chose, mais il y a un problème dans cette affirmation.

Quant à mon propos sur les formules savantes, je n'ai jamais dis qu'elles n'étaient pas correctes, je dis qu'elles n'aident surement personne parmi les gens qui ont déjà du mal à comprendre ce qu'est et comment fonctionnent ces "AI-trucmuche".

En tout cas on est bien d'accord, et c'est pas faute d'avoir posté 2 fois la vidéo de Mr Phi : ChatGPT répond un truc "probable" et une "moyenne", pas un "résultat juste". Si ça tombe juste, c'est purement une chance statistique.

Ce n'est pas un outil de recherche. (Pas plus que Stable Diffusion n'est un outil de recherche d'image)

[ Dernière édition du message le 28/01/2023 à 11:43:36 ]

iktomi

miles1981

Citation de miles1981 :Et en plus, il faudrait enlever de son apprentissage les erreurs passees, ce qui n'est pas possible ! Bref, c'est une mecomprehension profonde du machine learning que de croire qu'on peut corriger correctement un tel modele.

C'est ce que les devs sur Stable Diffusion font en permanence.

Le modèle change continuellement de version, 1.4, 1.5, 2.0, 2.1... avec chacun des variants de tensors, et des fix... Je ne vois pas où est l'obstacle.

Cela reviendrait à dire qu'une fois un modèle créé, non seulement il n'est pas modifiable ou remplaçable (quitte à lui faire réapprendre de zéro après correction), mais qu'en plus on est obligé de continuer à l'utiliser, ou alors bazarder tout le logiciel ?

Soit il y a un soucis d'emploi des termes, soit on parle pas du tout de la même chose, mais il y a un problème dans cette affirmation.)

On ne peut pas desapprendre quelque chose. Une fois que la contribution a ete entrainee, elle est la et elle reste. Oui, elle sera dilluee dans l'ensemble, mais ce n'est pas un argument. Pour properment enlever la contribution d'une image ou d'un texte ou de n'importe quel echantillon dans un reseau de nerones, il faut le re entrainer. de zero.

Audio Toolkit: http://www.audio-tk.com/

iktomi

PS : qui a employé l'argument de la "dilution dans l'ensemble" ? Si ça c'est pas un homme de paille...

[ Dernière édition du message le 30/01/2023 à 11:32:49 ]

- < Liste des sujets

- Charte