Il y a deux ans, une révolution a montré son nez en sous-marin, une vieille promesse des technologies de DSP qui a été finalement satisfaite grâce à l'IA, avec simplicité et gratuitement : la possibilité de cloner à l'identique des amplis et pédales. Parlons donc de Neural Amp Modeler !

L’an dernier, nous vous avions proposé dans nos colonnes un trio de dossiers qui portait sur la convolution et ses applications, qui était une mise à jour d’un très vieux dossier de votre serviteur, avec un guide d’achat sur les réverbérations à convolution et un autre sur les simulateurs d’enceintes guitare et basse, où l’usage de réponses impulsionnelles enregistrées ci et là s’est répandu comme une trainée de poudre depuis de nombreuses années.

Nous nous étions interrogés à de multiples reprises sur la possibilité de voir émerger une technologie quelconque, qui permettrait de faire la même chose que ce que permet la convolution, à savoir copier les caractéristiques soniques d’un traitement sonore pour l’appliquer à n’importe quelle source audio, mais avec un champ d’application qui couvre les traitements non linéaires (distorsion, compression, exciteurs, appareils avec des lampes, etc.), donc en capacité de produire des harmoniques, et pas simplement le linéaire pur et dur (réverbération, filtres, prise de son d’enceintes guitare). Parmi les usages que l’on ferait d’une telle technologie, il y aurait évidemment un focus sur le matériel dédié à la guitare (amplificateurs et pédales notamment), mais aussi un champ des possibles qui irait s’attaquer à de multiples appareils de studio dont on voudrait pouvoir virtualiser les apports et les bienfaits.

Quelques années plus tard, on s’intéressera de plus en plus près à un concept, celui du « clonage » d’amplificateur guitare, en l’abordant sous différents angles. D’abord, l’angle du Tone Matching consiste à traiter une piste de guitare déjà produite par une égalisation générée automatiquement, pour coller le plus possible au son d’une autre piste, via convolution ou assemblage de bandes d’un EQ paramétrique (possible dans Fabfilter Pro-Q et la plupart de ses concurrents). Le résultat peut être assez intéressant si le signal à corriger n’est pas trop éloigné de la cible, la correction étant de fait linéaire, ce qui limite évidemment les applications.

L’autre approche, celle proposée par Kemper / Access avec son Profiler Amp en 2012, allait créer une petite révolution. Cette fois-ci, on allait pouvoir copier la partie non linéaire également ! Or, le résultat attendu n’était pas exactement au rendez-vous. Malgré les différentes évolutions de la technologie depuis la sortie du premier produit de la firme, la dernière en date de 2023 s’appelant « Liquid Profiling », la ressemblance obtenue est, disons d’un niveau aléatoire, et les comparatifs en ligne que vous pourrez aller écouter vous montreront des signes d’excellence et des gros ratés à d’autres moments. Ce côté aléatoire on le retrouve d’ailleurs chez des concurrents directs qui ont cherché à adopter le même concept (on pense notamment à la fonctionnalité de clonage du Peavey Revalver 4, apparue en 2016 et qu’on retrouve encore dans des produits testés récemment dans nos lignes), qui proposent parfois des traitements supplémentaires à apporter pour optimiser la corrélation simulation / cible via des processus laborieux et d’une fiabilité parfois discutable.

Autour de la fin de la décade précédente, des articles scientifiques pressants indiquaient que l’intelligence artificielle allait prochainement être la solution à ce problème. Alors que le Deep Learning commençait à faire parler de lui dans la sphère publique, on commençait à voir apparaître des projets de démonstration de la technologie pour reproduire le comportement de pédales d’effets ou d’amplificateurs guitare. Puis, en 2022, un de ces projets fut mené un peu plus loin que les autres. Steven Atkinson, musicien et Applied Scientist chez Amazon, mis en ligne gratuitement son travail réalisé sur son temps libre, la première version du plug-in Neural Amp Modeler ainsi que le processus pour mesurer soi-même son matériel, exporter le résultat du processus sous forme d’un petit fichier de 200 kilo-octets, et le charger dans le plug-in pour simuler ce matériel avec un niveau de réalisme au minimum étonnant, et surtout une communauté très active qui a partagé rapidement des centaines de profils d’amplificateurs et de pédales. C’est ce dont nous allons vous parler dans ce dossier !

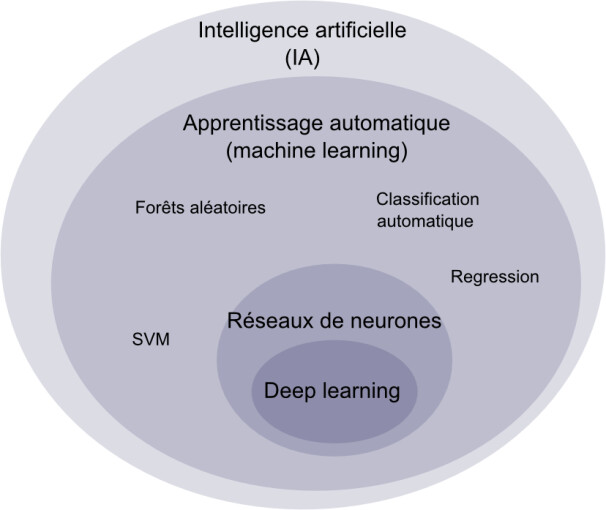

C’est quoi l’IA ?

Avant de vous exposer les prouesses réalisables par Neural Amp Modeler, que j’avais d’ailleurs déjà utilisé dans un de mes précédents tests, il me semble opportun sans être H.S. de partager avec vous quelques informations sur ce sujet, ô combien brûlant aujourd’hui, qu’est l’intelligence artificielle dans notre société. On en a déjà parlé ci et là avec l’article de Los Teignos sur MusicLM, ses nombreux éditos évidemment, ou encore l’interview de Jason Valax, fondateur de Albstract.

Déjà le terme « d’intelligence artificielle » est très galvaudé, dans la mesure où les usages existants aujourd’hui de ces technologies, ainsi que ceux que l’on peut déjà imaginer dans le futur, n’ont pas vraiment grand chose à voir aujourd’hui avec une quelconque manifestation d’intelligence, même artificielle, à l’encontre de l’imaginaire dystopique. À l’heure actuelle, il s’agit le plus souvent d’automatisation de tâches rébarbatives, d’utilisation de règles mathématiques pour faire apparaître de l’ordre et de la logique là où il ne semble pas y en avoir de manière évidente, de réussir à faire croire à la présence d’une intelligence humaine de manière algorithmique (quitte à faire des choses qui dans le détail n’ont aucun sens), et parfois même à utiliser un peu de savoir-faire algorithmique pour interpoler entre plusieurs contenus parfaitement humains.

Il existe des applications répandues de l’IA qui ne sont pas du machine learning, par exemple tous les systèmes basés sur des règles et des symboles (systèmes experts conçus pour imiter la prise de décision humaine dans un domaine spécifique, comme en médecine ou en finance, logique floue), les algorithmes de recherche comme ceux que l’on retrouve régulièrement dans le jeu vidéo (voir l’excellente introduction au sujet sur YouTube du Joueur du Grenier), des langages de programmation logique comme le Prolog avec ses applications, des systèmes de traitement du langage naturel qui étaient utilisés encore jusqu’à il y a peu pour la traduction du texte…

Mais aujourd’hui, ce dont il est question quand on parle de ce sujet pour le grand public, c’est principalement de tous les clones de ChatGPT de OpenAI (qui d’ailleurs n’est plus open source, contrairement à DeepSeek, par exemple) ou de Midjourney et DALL-E, que l’on appelle aussi IA génératives, et qui permettent de générer du texte, des images, des vidéos, du son ou même du code en réponse à des requêtes ou prompts, grâce au Deep Learning et aux LLMs (large language models), nourris par d’énormes quantités de données. Les deux paragraphes du dessus ont d’ailleurs été écrits pour le fun avec l’aide de ChatGPT et d’un peu de réécriture, dans l’optique d’illustrer ce qu’il est possible de faire en aide à la rédaction (c’était d’ailleurs la première fois que je le fais), et aussi parce que c’est drôle de demander à une IA ce qu’elle pense de l’IA pour écrire un article sur l’IA avec comme illustration des paragraphes écrits par l’IA pour expliquer ce qu’est l’IA…

Aujourd’hui l’IA est aussi au cœur de polémiques, voire de questionnements fondamentaux sur les répercussions du déploiement de cette technologie, et des conséquences sur la société humaine. Elle pose un certain nombre de problèmes à des niveaux individuels et plus macro, d’autant que les applications et le fond scientifique progressent actuellement de façon très rapide, voire incontrôlée. Si l’avènement des IAs dites « fortes » (en gros Terminator et consorts) ou des superintelligences nous semble peu probable pour le moment, l’humain réalise déjà avec l’existant un certain nombre de choses problématiques, suffisamment pour qu’il y ait une demande forte de citoyens et d’experts sur des manœuvres de régulation et de protection. Mais, pour le moment le sujet est très peu intériorisé par les pouvoirs publics de la plupart des pays occidentaux, qui ont plutôt tendance à vouloir favoriser le business et l’accélérationnisme. Pourtant, alors que « le sommet de l’IA » se tenait début février en France, nous avons été nombreux à découvrir la vidéo de vulgarisation des problématiques du moment illustrée par une partie de paperclips. Et Médiapart vient de livrer un tableau peu reluisant des usages du moment de l’IA qui vont contre l’intérêt général, et même parfois le droit national et international : militarisation, collecte de données sans consentement pour la technosurveillance ou le détournement du droit d’auteur, déploiement de reconnaissance faciale et voix en temps réel, précarisation du travail, dégradation des services publics, influence et désinformation sur les réseaux sociaux, le tout avec un coût énergétique hors de contrôle qui va encore plus loin que celui des cryptomonnaies et des technologies blockchain…

C’est quoi l’IA appliquée à la M.A.O.

Fort heureusement, les applications et problématiques posées de l’intelligence artificielle à la musique sont sur une autre échelle, ce qui ne nous empêchera pas toutefois d’exercer notre sens critique. Tout ce qui permet d’automatiser des tâches ingrates ou de simplifier la vie des musiciens a toujours créé de tout temps des polémiques, des débats « analogique contre numérique », en passant par l’impact sur ces dernières décades de la diffusion d’outils d’aide à la composition ou au mixage, de la virtualisation des machines, voire même des humains d’un EZDrummer ou d’un EZMix qui ont forcément influencé la perte de vitesse des studios d’enregistrement traditionnels, ou les kilomètres de présets de nos plug-ins modernes. On parle aussi régulièrement des pratiques de Spotify et des déclarations de son fondateur, avec la diffusion de morceaux réalisés par des IAs (type Suno) pour réduire la part de leurs revenus à redistribuer aux artistes réels (documenté dans le livre Mood Machine de Liz Pelly sorti récemment).

Qui aurait cru qu’on parlerait aujourd’hui de tous ces sujets en voyant les évolutions de la technologie au service de la musique ? Il y a à peine une dizaine d’années, les débuts de l’IA permettaient timidement de générer des notes MIDI à partir de bases de données issues de partitions classiques, avant qu’on parle de machine learning symbolique ou profond. Les débuts des générateurs automatiques de musique étaient plutôt rudimentaires et n’intégraient pas encore la dimension du sound design et du mixage. L’IA a aussi pas mal été utilisée dans le contexte des interfaces homme-machine pour la reconnaissance des gestes et l’interaction avec le matériau sonore (voir par exemple les différentes expérimentations avec les contrôleurs de jeux vidéo Kinect de Microsoft ou Wiimotes de Nintendo, l’Aerodrums, ou tout ce qui est publié aux conférences annuelles NIME).

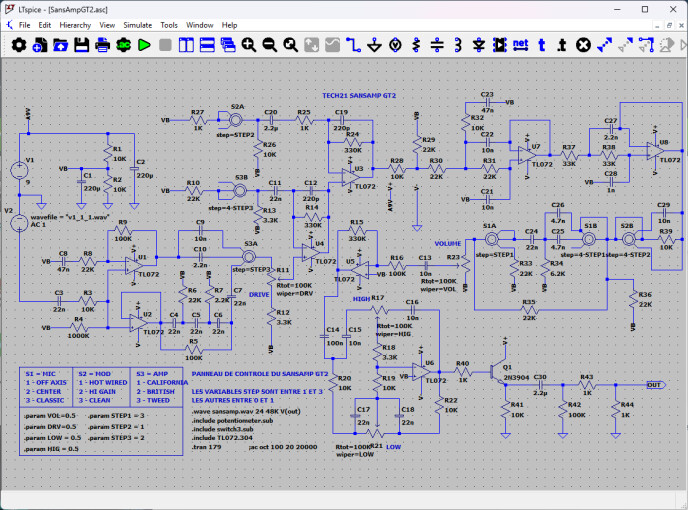

Et puis, on a vu du machine learning montrer le bout de son nez dans les simulateurs d’amplificateurs guitare depuis déjà quelques années. La première occurrence du phénomène provient, il me semble, de l’éditeur de plug-ins russe du nom de Mercuriall, issu de la vague des développeurs qui échangeaient sur feu le forum Guitarampmodeling à propos de techniques d’émulation, et qui partageaient leurs créations gratuitement. C’est ainsi qu’on vit débarquer en même temps les freewares notamment de LePou, Ignite Amps, TSE, et Mercuriall. Ils utilisaient des techniques qui avaient été inspirées du travail des chercheurs Federico Fontana, Thomas Serafini, et David T. Yeh, et des moteurs de simulations généralistes SPICE, tels que le logiciel LTSpice édité par Linear Technology. L’usage du Machine Learning permettait alors de remplacer des tableaux de valeurs précalculés à interpoler par un réseau de neurones, plus facile à utiliser et à déployer. À ma connaissance, il y a quelques autres sociétés qui ont utilisé plus tard cette approche…

C’est quoi Neural Amp Modeler ?

Neural Amp Modeler est donc le projet de Steven Atkinson, docteur en ingénierie mécanique, chercheur en statistiques et machine learning, et guitariste amateur. Le projet commença sur son temps libre en 2019, fut abandonné quelque temps, puis repris début 2022. Steven utilisa ses connaissances pour concevoir à la fois le processus d’entrainement en python, et le moteur de simulation temps réel, qu’il finit par remplacer en septembre 2022 par l’état de l’Art du domaine appliqué à l’audio, avec des modèles de réseaux de neurones LSTM (Long short-term memory) et basés sur le WaveNet de Google / DeepMind.

À ce stade, son travail permettait déjà à son grand étonnement d’obtenir un niveau de similarité excellent entre ses résultats – qu’il pouvait utiliser en temps réel dans un plug-in – et les originaux qui étaient utilisés pour l’entrainement, avec un réalisme supérieur à celui obtenu via les procédés de clonage des produits Kemper, du Quad Cortex de Neural DSP, ou des produits ToneX de IK Multimedia, en tout cas dans ses tests. Il existait déjà à ce moment des produits qui réalisaient le clonage par machine learning, WaveNet était disponible depuis 2016 et très fortement lié au domaine de l’audio, des articles IEEE et DAFX faisaient état des premières tentatives de créer des plug-ins de simulation de matériel guitare par IA, notamment celui de Alec Wright + Vesa Välimäki de l’université de Aalto, et Eero-Pekka Damskägg + Lauri Juvela de Neural DSP en 2020 avec une autre variante de WaveNet. Le nerf de la guerre ici n’était pas seulement le résultat en lui-même, mais aussi l’efficacité du processus d’entrainement, qui dépend fortement du type de signal à envoyer dans les originaux, sans oublier l’existence d’une implémentation C++ rapide pour utiliser le résultat en temps réel. Cette contrainte est très spécifique à l’audio et à nos problématiques de musiciens, tandis que la plupart des applications du machine learning sont réalisées à la demande en offline dans des environnements où tout est codé en python, sans l’intérêt de mixer les langages de programmation ou de garantir une basse latence et une consommation de charge processeur (ou GPU) en dessous d’un certain seuil.

Honnêtement, on peut dire aujourd’hui qu’il est difficile de dégager une technologie à base d’IA qui ferait un meilleur travail que les autres, vu qu’elles affichent des performances et des problématiques similaires, qui tendent vers le même niveau de réalisme à chaque itération par design. Quand NAM s’est vraiment fait connaître en 2023, il existait d’ailleurs déjà des initiatives gratuites, comme Proteus ou Aida-X, ainsi que différents projets moins user-friendly dans les méandres de GitHub. Mais ce qui a fait que ce projet est passé devant en termes d’intérêt, c’est clairement l’engagement de sa communauté, et les tonnes de profils rendus disponibles pour NAM (plus de 2500 packs de profils gratuits en février 2025, ainsi que du contenu payant proposé ailleurs), en comparaison avec une poignée seulement de profils pour les autres technologies gratuites.

Neural Amp Modeler en action : comment l’utiliser et quels résultats attendre ?

Alors, comment ça marche ? Et bien on peut aller sur le site ToneHunt, télécharger des profils de matériel qui nous intéressent au format NAM, télécharger un des plug-ins qui lit ces fichiers (voir une liste plus loin dans le dossier), ouvrir le plug-in et sélectionner le profil NAM voulu. On obtient une simulation du matériel en question, le plus souvent une pédale de distorsion ou un amplificateur guitare. Je reprécise que tout cela est gratuit évidemment !

Et, comme pour les autres simulateurs d’amplificateurs, on fera attention à la gestion de la stéréo, on pourra utiliser des effets avant ou après si on le souhaite, et on rajoutera une simulation de la partie « enceintes ». Il est d’ailleurs tout à fait possible d’utiliser plusieurs instances du moteur NAM à la suite (certains plug-ins compatibles le permettent déjà) pour avoir, par exemple, une Klon Centaur, un Fender Reverb et un 1×12 en Greenback, tous gérés par NAM (même si sur la partie enceinte l’usage le plus répandu aujourd’hui reste toujours les réponses impulsionnelles).

Précisons qu’un profil ici correspond à un élément à simuler donné avec un set de paramètres fixés et qui ne varie pas, indiqué par son auteur en général. Il n’est pas pour l’instant possible de capturer du matériel avec NAM qui inclurait toutes les variations de ses potentiomètres (par exemple, une Tube Screamer avec le Drive, le Tone, et le Volume variables à l’envi) autrement qu’en proposant des captures pour différents sets de paramètres. Toutefois, cela est déjà possible en adaptant la technologie, Steven Atkinson ayant justement mis en ligne à un moment donné un proof of concept à savoir un plug-in dédié intitulé « NAM Parametric: Overdrive », qui simule une pédale analogique custom de sa conception avec la technologie. C’est quelque chose qui sera amené à être beaucoup plus diffusé dans un futur proche, le moteur Proteus proposant déjà quelque chose de similaire, ainsi que les plug-ins de la marque Fazertone en source fermée.

Le fichier input.wav suggéré est mono en 24 bits, avec une fréquence d’échantillonnage de 48 kHz, et fait une durée de très exactement 3 min et 10 secondes. N’importe quel autre fichier pourrait faire l’affaire, mais, en partant de celui-ci, la première étape est de le passer au travers du matériel que l’on cherche à reproduire. Cela peut d’ailleurs aussi être un plug-in ! Dans le cas d’un amplificateur guitare hardware, on recommandera l’usage d’un boitier de réamping, qui permet de convertir un signal niveau ligne (en sortie de votre interface audio) en un signal qui présente une haute impédance comme les pickups d’une guitare électrique passive, pour obtenir un comportement de l’amplificateur plus proche de conditions d’usage réel. On enregistrera alors la sortie de l’ampli, qu’on exportera ensuite au même format identique, avec exactement la même durée également (attention c’est très important). Enfin, on pourra déclencher la phase d’entrainement, avec une version locale du projet qui exécute la fonction (de préférence si vous êtes à l’aise avec le code et que vous possédez un GPU Nvidia pour accélérer le processus, notamment si vous avez envie de faire l’opération sur beaucoup de captures à la fois en personnalisant certains réglages), ou bien avec les outils en ligne comme Google Collab, et le nouveau site web ToneZone3000 dont je vous recommande l’usage. Toutes les informations à jour sont disponibles ici : https://www.neuralampmodeler.com/users

Notons qu’il peut arriver que les méthodes d’entrainement ci-dessus vous indiquent des erreurs avant même le démarrage du procédé. Pour améliorer les performances du processus, il est recommandé d’utiliser votre STAN pour envoyer le signal à enregistrer et enregistrer la sortie de l’appareil ou du logiciel à capturer en même temps, avec la bonne fréquence d’échantillonnage, et un réglage des niveaux qui permet de limiter le niveau de bruit sur la mesure.

Dans mon test du Nembrini Audio MP1 Pro, simulation du préampli ADA MP-1, j’avais mis deux échantillons sonores que je vais vous refaire écouter ici, le A correspondant à un enregistrement de l’original à partir d’un signal dry réampé, et le C à la même chose passée dans le plug-in NAM en réglant en amont le niveau de gain d’entrée et le volume de sortie, avec à chaque fois la même simulation d’enceintes.

- Dist Tube – Exemple A00:11

- Dist Tube – Exemple C00:11

Le moins que l’on puisse dire, c’est que nous sommes sur un niveau de performance de clonage d’amplificateur saturé qui est assez remarquable ! Les deux échantillons sonores sont faciles à différencier en faisant attention au niveau de bruit et de hum sur les premières secondes, mais sur le reste, en calant les sons à l’échantillon près, on arrive même à avoir une performance avec un null test qui est singulière (en moyenne en dessous de –30 dB) compte tenu des conditions d’enregistrement et de réglage du protocole. Sur des sons clairs, on peut obtenir également des résultats intéressants si on compare le son d’un Roland Jazz Chorus avec une capture NAM (réalisée aussi avec les mêmes réglages, et un peu d’uniformisation des volumes d’entrée et de sortie).

- Jazz Chorus Original00:19

- Jazz Chorus NAM00:19

On peut également s’amuser à faire un test cette fois-ci avec des pédales de distorsion, par exemple, la distorsion JHS Pedals Notaklon, réplique de la mythique Klon Centaur, d’abord désactivée, puis activée dans l’exemple sonore suivant (avec une capture de Dumble Overdrive en son clair issue de ToneHunt.org), ou un peu de Bass Attack de Hartke sur la basse.

- Dumble Clean Notaklon00:16

- Underworld Bass00:21

Ainsi, la technologie de Neural Amp Modeler nous semble très à l’aise sur différents registres liés à la guitare. Notons qu’il est possible, comme avec certains concurrents, de réaliser des captures qui profilent une combinaison de différents appareils hardware. On trouve ainsi de nombreuses captures sur ToneHunt.org d’amplificateurs guitare typés métal qui incluent une Tube Screamer en amont (utilisation classique pour obtenir un côté tight sans forcément utiliser le gain de la pédale), ou des amplificateurs plutôt son clair avec des pédales de boost, distorsion, ou fuzz incorporées. Tout ce qui compte, c’est l’imagination, tout ça…

Gain staging avec Neural Amp Modeler : optimiser son signal pour un rendu réaliste

À présent, parlons d’un sujet central avec NAM qui n’avait pas lieu d’être avec la convolution et les réponses impulsionnelles, l’impact du niveau d’entrée ou ce qu’on appelle parfois aussi le gain staging. Avec la convolution, une fois qu’on a réglé le volume de sortie à un niveau acceptable, on est assuré d’obtenir un rendu sonore satisfaisant et similaire à la cible à simuler. Avec NAM, la capture étant non linéaire, le niveau d’entrée dans le plug-in va avoir un impact dramatique sur le résultat. Pire, en fonction des conditions dans lesquelles la capture a été faite, il est nécessaire de partir d’un volume d’entrée assez faible (par exemple –12 dB) comme valeur par défaut ou de départ pour utiliser un fichier NAM dans de bonnes conditions d’usage, avec le niveau de gain attendu. Et cette valeur peut changer drastiquement d’une capture à une autre !

Une bonne pratique dans l’usage de NAM sera donc, quelle que soit la capture utilisée, d’avoir constamment à portée de souris ou de doigt le réglage du niveau d’entrée. On peut imaginer qu’il n’y aura pas besoin de changer ce réglage à chaque fois, surtout si on navigue dans un pack donné de captures où le niveau d’entrée du signal avant capture ne change pas sans arrêt, mais il faudra toujours garder cela en tête, notamment si on utilise plusieurs profils à la suite (par exemple pour la partie pédale, puis amplificateur, etc.).

Cette notion de gain nous amène à faire plusieurs observations supplémentaires. Pour commencer, nous le savions déjà avec les simulateurs de matériel analogique, mais ici également, le niveau d’entrée de la simulation n’équivaut pas au réglage de gain qui existe dans l’original ! Que ce soit dans une pédale de distorsion classique ou une grosse tête à 12 lampes moderne, les constructeurs positionnent souvent le réglage dit de gain dans un circuit électronique à un endroit situé après un certain nombre de composants, dans l’optique d’obtenir un son toujours propre quelque soit la valeur du réglage, ainsi que des interactions intéressantes avec le reste du circuit, ou des filtres qui vont modifier la réponse en fréquence du résultat en fonction de la valeur de gain. Tous ces « sweet spots » ne seront donc pas accessibles à l’aide d’une seule capture, même réalisée déjà avec un certain niveau de gain, juste en faisant varier le niveau d’entrée de la simulation ou même le volume au niveau de la guitare. Il sera plus intéressant d’avoir plusieurs captures avec différentes valeurs de ce paramètre.

De même, puisque la simulation NAM a un comportement hautement interactif avec le niveau de gain, on peut imaginer que le réalisme de simulation sera optimal sur un cadre donné et restreint de valeurs de niveau d’entrée qui correspond aux conditions de capture. Cela soulève une remarque supplémentaire. Admettons que l’on pousse le volume d’entrée fort dans NAM, est-ce que ce que l’on entend est bien ce qui se passerait dans l’original avec un volume d’entrée similaire ? Aucun simulateur d’ampli ou de pédale analogique ne garantit cela, ce n’est pas le nouveau challenger qui va déroger à la règle (que celui qui n’a jamais essayé de mettre 60 dB de volume d’entrée dans son plug-in préféré pour le fun parle maintenant ou se taise à jamais). D’ailleurs, je ne résiste pas à l’envie de vous faire écouter ce qui sort de IK Multimedia Amplitube 4 quand on joue un peu trop longtemps avec des signaux d’amplitude beaucoup trop forte, j’avais réussi à détraquer complètement le moteur de simulation à un moment donné, qui m’envoyait ce genre de sons sans que je ne fasse quoi que ce soit en entrée à part des interactions avec le potentiomètre de gain sur un amplificateur émulé high gain.

Sans aller jusque là, on peut imaginer qu’avec un niveau de gain suffisant, ce qu’on entendra, ça sera, par exemple, des saturateurs utilisés dans le réseau de neurones qui saturent plutôt que quelque chose présent naturellement dans l’appareil mesuré. De plus, avec de tels niveaux de gain, il est probable également que des phénomènes très numériques comme l’aliasing puissent venir polluer le signal. C’est d’ailleurs un sujet récurrent dans la communauté NAM. Le moteur semble avoir un comportement un peu difficile à quantifier à ce niveau-là, dépendant de la simulation utilisée, qu’on pourra réduire au maximum en appliquant un filtre passe-bas avant la simulation ou en utilisant des captures réalisées avec une fréquence d’échantillonnage supérieure à 48 kHz.

Enfin, à moins de mettre une quantité de gain impressionnante dans le monde analogique, on aura du mal à faire entendre sur l’enregistrement qui sert à l’entrainement des phénomènes comme ceux que l’on peut obtenir facilement en numérique en poussant un peu le volume d’un glissement de souris. Après tout, même nos sorties audio d’interfaces numériques ont une limite au niveau du volume de sortie, tout comme d’éventuels amplificateurs de puissance. Ce qui nous permet de réaliser – pour terminer cet aparté sur le gain staging – qu’il est important lorsqu’on réalise des mesures de garantir qu’on envoie un signal assez fort dans le matériel analogique à capturer, quitte à en mettre un peu plus que ce qu’il faudrait, pour qu’on soit certain d’avoir le bon niveau de non-linéarité dans la simulation. Car NAM ne pourra pas produire une sonorité issue de l’original qui n’est pas présente dans l’enregistrement utilisé par l’entrainement ! Donc, inutile, par exemple, de pousser fort NAM avec une capture d’enceinte ou de pédale de distorsion dans l’espoir d’obtenir une sonorité qui n’existe pas dans la capture, faute de niveau suffisant appliqué à l’enregistrement. Mais avec un peu de marge de gain, on peut faire ressortir correctement le grain de l’amplificateur original avec un peu de marge, comme ici avec un Peavey 5150 II.

Cela peut être particulièrement dramatique dans le cas, par exemple, de la pédale ProCo RAT. Celle-ci possède un comportement très caractéristique qui la fait sonner comme une overdrive plutôt classique tant que le niveau de gain est inférieur à un seuil, qui pourrait presque la faire passer pour une Tube Screamer. Puis, au-dessus de ce seuil, à cause d’une erreur initiale de conception du designer sur une valeur de résistance, le gain en entrée d’un des amplificateurs opérationnels augmente brutalement, et notre joli signal légèrement distordu se transforme indubitablement et inexorablement en carré, apportant le côté fuzz classique de la pédale. Sans ce boost de gain nécessaire, une simulation NAM ne pourrait ainsi jamais donner la sonorité attendue, même avec plus de volume en entrée du plug-in (ici un exemple cliché d’utilisation de la RAT, à partir d’une capture de la JHS Pedals PackRAT, sur une ligne de TB-303).

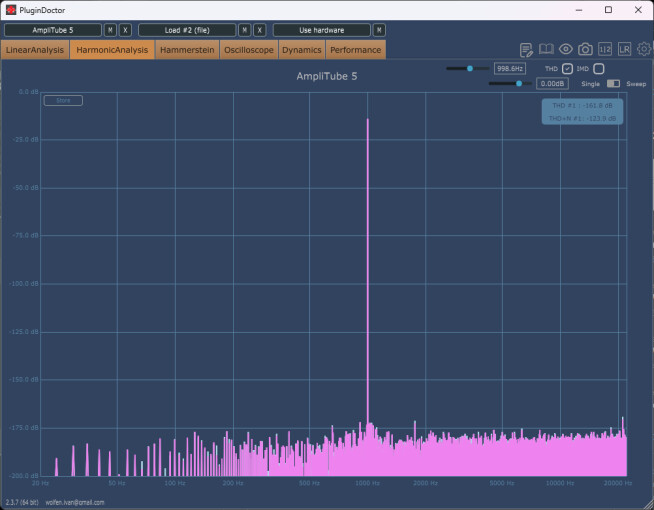

Enceintes pour amplificateurs guitare et basse

De même, le cas des enceintes nécessite une certaine attention, d’autant que NAM va pouvoir nous apporter un éclairage intéressant. Lorsque Neural Amp Modeler est sorti, j’ai attendu avec impatience la mise en ligne de profils d’enceintes guitare, repiquées avec des microphones classiques, dans le but de pouvoir entendre via NAM cette fameuse non-linéarité issue des haut-parleurs qui est un sujet depuis la sortie des premiers simulateurs de Two Notes. En effet, on fantasme beaucoup encore aujourd’hui sur ces non-linéarités qui ne sont pas accessibles avec les simulateurs classiques à base de réponse impulsionnelle, mais seulement avec ceux qui intègrent des modèles physiques ou des approches plus avancées (notamment chez Two Notes, Mercuriall, Overloud, etc.). Pour savoir où votre simulateur préféré se situe, il est aisé d’utiliser, par exemple, le fameux DDMF PluginDoctor, et de jeter un œil à la réponse harmonique du produit. S’il n’y a pas la moindre trace de distorsion, cela signifie que l’approche utilisée est parfaitement linéaire.

- Guitar – Dry00:10

- Guitar – IR00:10

- Guitar – NAM Low Gain00:10

- Guitar – NAM Mid Gain00:10

- Guitar – NAM High Gain00:10

- Guitar – NAM Higher Gain00:10

- Guitar – NAM Highest Gain00:10

- Guitar – NAM Hell Gain00:10

Or, dans ce que nous entendons ici, il est en fait très probable que les non-linéarités proviennent de la saturation du moteur NAM plutôt que des enceintes elles-mêmes, pour les raisons que nous venons d’évoquer ! Dans le cas contraire, nous aurions déjà une certaine quantité de non-linéarités présentes avec la valeur par défaut du volume d’entrée. Ce qui n’est manifestement pas le cas, et entre en contradiction avec ce que nous disions dans le dossier sur la simulation d’enceintes. Le mystère reste donc entier, et nous allons le résoudre en faisant là encore nos propres mesures, sur une enceinte Harley Benton 1×12 avec un haut-parleur Celestion V30, et une prise de son en close-miking avec un SM57 (on ne peut pas faire plus classique !) avec beaucoup de volume en sortie. Nous allons ensuite écouter le rendu de la simulation NAM avec le volume d’entrée qui augmente progressivement. Sur l’exemple sonore, on entend clairement quelque chose qui nous semble d’origine analogique, puis une saturation à la toute fin, qui est très probablement celle de NAM, mais avec des sonorités intéressantes entre les deux.

La performance des simulations d’enceintes a ainsi franchi un nouveau palier grâce à Neural Amp Modeler ! Pas mal de petites choses bougent encore à ce niveau-là d’ailleurs aujourd’hui, et on se dit que les remarques sur les déplacements de potentiomètres en live sur les pédales pourraient s’appliquer à différents positionnements de microphones dans l’espace, qui seraient interpolés par le modèle, ce qui permettrait de résoudre un autre problème typique de ces simulations dans la foulée !

De plus, NAM permettant de modéliser des stacks complets (pédale + ampli + enceinte + micro par exemple) avec la même capture, on pourrait également récupérer un peu de réalisme supplémentaire dans la simulation des interactions entre ces différents éléments, notamment l’impédance de l’enceinte avec l’amplificateur de puissance, pour se rapprocher encore plus des prises de son réelles. En attendant, nous allons aussi continuer à regarder les dernières innovations en la matière, telles que le Kemper Kabinet, ou le IK Multimedia ToneX Cab, réalisés en partenariat avec Celestion, et écouter encore un peu de saturation d’enceintes avec une capture d’un Mesa Boogie JP2C.

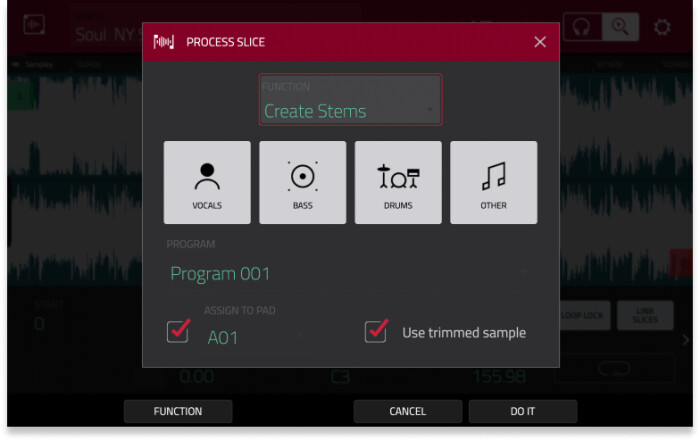

Aller plus loin avec NAM

Alors, jusqu’où peut-on encore aller avec Neural Amp Modeler ? Malheureusement, le moteur dans son état actuel a un certain nombre de limites en matière de capacités d’émulation. Par exemple, il ne permet pas pour le moment de reproduire d’effets « temporels » de type délai ou réverbes (ce qui peut être problématique sur les simulations d’enceintes si on veut « le son de la pièce » sans ajouter de réverbe supplémentaire), ou encore de modulations, provoquées par un LFO ou même une enveloppe qui suit le signal comme sur les compresseurs. Ce que l’on entend sur les captures NAM existantes est très insuffisant, et semble représentatif du caractère fréquentiel linéaire pur ou non linéaire, mais sans certaines caractéristiques clé, comme la queue de la réverbe ou le pompage du compresseur, ce qui tout de suite limite pas mal les applications possibles de la technologie à l’heure actuelle, qui s’étendent à peine au delà du monde de la guitare à d’autres types de distorsions comme celle des préamplificateurs à lampes en général.

Mais cela ne doit pas nous décourager à trouver des applications rigolotes avec ce qui est déjà disponible. Nous avons évidemment quelques idées, qui nous ont été soufflées par des petits plaisantins qui mettent en ligne des profils un peu particuliers sur ToneHunt.org. Nous avons pu constater là-bas que parfois les annotations affichées sur les profils disponibles peuvent être mensongères ou fallacieuses sur les origines du matériel capturé. Ainsi, puisque rien n’empêche de capturer le son d’un plug-in, il y a des captures qui ont été réalisées sur des modélisations, notamment chez Neural DSP, ou plus amusant encore, avec le logiciel LTSpice !

Neural Amp Modeler : les meilleures solutions logicielles et matérielles pour l’utiliser

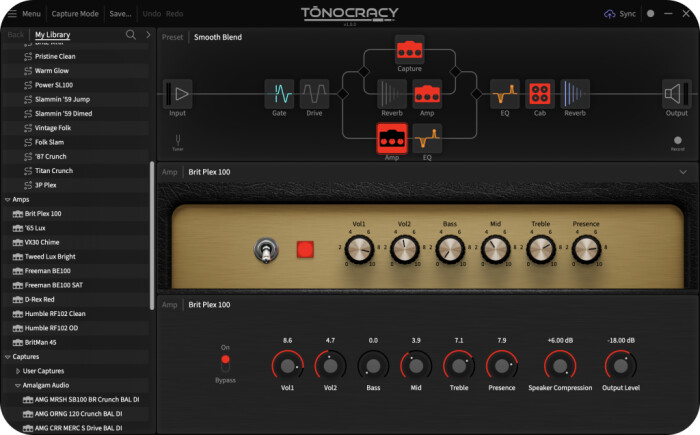

Pour terminer ce dossier, nous allons à présent vous faire quelques recommandations de solutions numériques pour utiliser les profils au format Neural Amp Modeler… On peut par exemple utiliser le plug-in Neural Amp Modeler officiel ! Celui-ci est gratuit, régulièrement mis à jour avec son moteur de traitement, il est fourni avec un noise-gate et une section d’égalisation rudimentaire, et il dispose aussi d’un lecteur de réponses impulsionnelles par convolution pour la simulation d’enceintes.

On pourrait s’arrêter là, mais le plug-in est finalement assez rudimentaire, et ne dispose pas (à l’heure actuelle dans sa version 0.7.13) de la stéréo. Aussi, naturellement, nous allons regarder quelles sont les alternatives, gratuites et payantes, qui permettent d’aller encore plus loin avec la technologie.

Software

Niveau logiciel, il existe différents types de projets, certains qui sont exclusivement des versions alternatives du plug-in d’origine et qui permettent simplement d’ouvrir des profils NAM, tandis que d’autres sont des simulateurs d’amplificateurs généralistes proposant la lecture de fichiers NAM de façon optionnelle. De la première catégorie, on peut citer notamment NAM Universal de WaveMind, qui est gratuit, qui propose différents ajouts, dont la stéréo, des filtres supplémentaires sur le chemin du signal, et la possibilité de charger plusieurs profils NAM pour l’amplificateur et pour une pédale.

Hardware

Depuis peu, il existe également du matériel qui permet de charger les fichiers NAM, comme les lecteurs de réponses impulsionnelles dont on avait parlé dans notre précédent dossier ! Cela fait d’autant sens que les développeurs de technologies concurrentes se sont lancées eux aussi sur le créneau, que ce soit IK Multimedia avec son ToneX Pedal, Neural DSP avec le Nano Cortex, ou encore le récent GS1000 de Mooer. Ainsi, le NAM Player de Dime Head (595 $) dispose de deux moteurs de lecture de fichiers NAM simultanés, d’un lecteur de réponses impulsionnelles et d’un moteur de convolution avancé qui peut gérer les IRs de jusqu’à 60 secondes, et de quelques effets (délai, réverbération, noise-gate, etc.). On pourrait parler aussi du Poly Effects Ample (400 $), qui est basé sur NAM, mais qui ne permet pas de choisir soi-même les profils que l’on veut utiliser. L’offre à ce niveau-là est aujourd’hui assez limitée, mais on peut imaginer qu’elle va continuer à s’étoffer, côté constructeurs français (sérieux) peut-être ? En tout cas, quelque soit la plateforme le résultat sonnera aussi bien et dépendra d’abord des captures utilisées et de votre jeu !

- Théâtre des rêves00:42

- Underworld Section Outro00:15

Conclusion

Neural Amp Modeler est à n’en point douter le début de quelque chose dont on risque de reparler encore dans quelques années. Il ne doit pas tout à son créateur direct, mais aussi à ses instigateurs et à ses utilisateurs, qui ont fait quelque chose d’intéressant de la technologie open source grâce au partage, dans une dynamique détonante par rapport aux applications corrosives plus lucratives du moment de l’intelligence artificielle.

NAM a encore quelques limitations (impact de l’aliasing, consommation CPU importante, y compris avec les moteurs simplifiés, obligation de resampler le signal d’entrée vers la fréquence d’échantillonnage de la capture, matériel qui ne peut être capturé, etc.), mais il est très probable que l’on voit débarquer prochainement de plus en plus de produits software et hardware conçus sur la même idée et qui iront de plus en plus loin sur les possibilités.

Pour autant, comme avec chaque sujet lié à l’IA, cela ne nous empêche pas de rester vigilants sur les usages ou un certain nombre de questions éthiques. On pense à d’innombrables débats « analogique contre numérique » à venir (sachant que l’IA ne permet toujours pas de rétablir le lien physique entre une simulation et la guitare ou le système de diffusion final du son causés par les convertisseurs analogiques / numériques), sur l’impact de la possibilité de copier à l’identique un son comme cela était le cas pour la convolution ou les produits Kemper, et de tous les débats sur les outils qui entendent simplifier la vie du compositeur, quitte à rendre moins utile de faire appel à des musiciens (avec batteries virtuelles par exemple) ou des ingénieurs du son (avec les EZmix like ou tous les outils de mastering automatique par plug-ins et en ligne), qui résonnent beaucoup avec nos considérations modernes sur les IAs génératives. Trancher sur tous ces sujets sort complètement du cadre de l’article évidemment.

Mais si l’IA au sens large ne permet pas encore de rendre le Phoenix Pro possible, profitons quand même de ce que des plug-ins gratuits, powered by AI ou non, peuvent faire au service de la création musicale.