La production, les prises, le mixage mais aussi le mastering : Bob Power a touché à tout. Il est dans le circuit depuis assez longtemps pour avoir pu assister aux premières loges au passage de l’analogique au numérique, à la chute de l’industrie du disque, à la montée en puissance d’internet, et pour ainsi dire à tout ce que l’on peut imaginer durant cette période. Il s’est fait une place dans l’industrie musicale grâce à son travail en tant qu’ingénieur du son spécialisé dans le mixage pour le groupe hip-hop culte A Tribe Called Quest, ainsi que pour son travail de réalisation artistique et de mixage pour des artistes estampillés R&B tels qu’Erykah Badu, D'Angelo, Me'Shell Ndegéocello, The Roots ou encore Chaka Kahn, le tout sans jamais avoir manqué de travail. À présent, il enseigne aussi la production musicale au prestigieux Clive Davis Institute of Recorded Music de l’Université de New York (NYU).

Power ne s’est jamais gêné pour dire ce qu’il pensait. Lorsque nous nous sommes entretenus avec lui récemment, il avait plein de remarques pertinentes à faire sur la production musicale et la technologie qui lui est associée.

Vous vous êtes vraiment fait connaître en enregistrant et mixant A Tribe Called Quest dans les années 90. Qu’est-ce qui, dans leur musique, était si révolutionnaire et si original ?

Ce qui était si spécial avec leur musique, c’est facile à entendre : des constructions musicales vraiment très sophistiquées pour l’époque. Ils utilisaient essentiellement des samples, ce qui n’était alors pas si courant, en partie parce que la technologie ne le permettait pas. Les technologies d’échantillonnage n’étaient pas encore aussi développées.

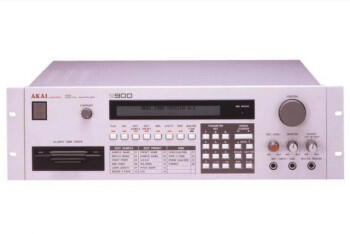

C’était encore l’époque de l’Akai S900. Niveau résolution, c’était du 16 bits ?

Du 12 bits.

C’est vrai.

Et les premiers SP12, c’était du 12 bits.

Sur le plan artistique, qu’est-ce qui rendait A Tribe Called Quest si fascinant ?

Tout d’abord, et ceci pour n’importe quel disque, il faut de super morceaux. Et ils illustrent parfaitement à quel point il peut y avoir énormément de types différents de bonnes chansons, pas besoin de forcément faire du Billy Joel. Leur autre atout, c’était leur capacité à assembler la musique. Encore une fois, pour l’époque, leur utilisation des samples était particulièrement sophistiquée : au lieu d’avoir la même boucle qui se répétait de bout en bout, ils recombinaient de façon très travaillée de nombreux éléments qui au départ n’avaient rien à voir. Et puis, les deux MC, Q-Tip et Phife, avaient aussi beaucoup de caractère. Ils étaient vraiment très complémentaires, et leurs styles et leurs messages étaient intéressants à écouter. J’ai remasterisé quelques-uns de leurs morceaux pour les sorties commémorant leur 25e anniversaire. C’est fascinant de réécouter en boucle des chansons que j’ai écoutées il y a 25 ans ; elles ont gardé tout leur charme.

La MPC était-elle déjà sortie à l’époque ?

Pas au début. Au départ, il y avait juste l’EMU SP12 et le S900.

J’ai eu un S950, et je me rappelle que tout était sauvegardé sur disquettes, il n’y avait pas encore de disques durs.

C’est vrai, et si vous aviez quelque chose qui était plus long que le temps d’échantillonnage maximum, qui n’était pas particulièrement long, on devait alors le sampler en deux morceaux qu’il fallait ensuite envoyer séparément dans le multipiste.

Je trouve ça intéressant, cette façon dont les évolutions technologiques entrainent le développement de nouveaux styles musicaux.

C’est clair. Il y a un parallèle fascinant entre le développement des technologies, notamment les technologies utilisées pour les instruments, et la façon dont la musique populaire est conçue et sonne. Et il n’y a aucun style dans lequel ce lien est plus évident que le hip-hop, où l’on a vu les structures des morceaux se complexifier avec l’extension des durées des samples.

C’est vrai. Je pense toujours à l’évolution du reggae dub, où les effets de délai sont devenus si importants dans le son.

Et c’étaient des délais analogiques, à bande !

Et donc, selon vous, quel a été l’impact de la technologie sur le hip-hop entre cette époque et maintenant ?

Disons que ce n’est plus le même monde. À l’époque, tout était très difficile à faire techniquement. Aux débuts du MIDI, les interfaces étaient vraiment bizarres. Les sampleurs en étaient à leur préhistoire, pareil pour les séquenceurs. Il n’y avait pas d’instrument virtuel permettant de travailler en MAO, tout reposait sur du matériel externe. Il fallait se synchroniser aux bandes, et il fallait forcément enregistrer sur bande vu qu’à l’époque il n’y avait pas de multipistes numériques. La première version de Pro Tools s’appelait Sound Tools, elle ne marchait qu’en stéréo et sonnait affreusement. On travaillait avec l’enregistreur de 24 pistes, le synthé et le sampleur, avec une technologie de séquençage qui commençait tout juste à balbutier. Si on compare à notre époque où il suffit presque de lancer sa STAN et d’appuyer sur la barre d’espace pour que tout marche, on n’est plus du tout dans le même univers, techniquement parlant.

C’est sûr.

Ce qui est intéressant, c’est que ce qu’il se passe maintenant ressemble à ce qui est arrivé aux débuts du MIDI en matière de démocratisation de la production musicale. Ça a popularisé l’enregistrement musical, n’importe qui peut acheter un ordinateur portable et obtenir quelque chose qui ressemble à un morceau, enregistré par ses soins en une heure et demie. Ceci dit, c’est intéressant de voir à quel point, après tout ce temps, tout semble cyclique : le marché est saturé, il y a plein de choses qui sortent, dont la plupart n’a pas beaucoup d’intérêt. Donc, je suppose qu’au final on en revient toujours à une excellente interprétation d’une très bonne chanson. Si vous gardez ça en ligne de mire, alors vous vous rendez compte que même si tout a changé, cet aspect n’a pas évolué.

Maintenant, la botte de foin est tellement énorme que l’aiguille est obligée de faire un marketing d’enfer pour qu’on la remarque, au moins en ligne. Mais c’est vrai que c’est un autre univers, et les labels n’ont plus la même influence qu’auparavant.

Oui, et ils font bien plus attention. Pour ce qui est de l’utilisation de leurs ressources, ils sont bien plus réticents et portés sur la stratégie. Ils signent moins d’artistes : 20 ans en arrière, 80% des gens signaient des contrats avec un label dont on n’entendait jamais parler au final. Aujourd’hui ils ne peuvent plus se le permettre. Ils ont été rattrapés par les économies d’échelle, d’une certaine façon.

Aujourd’hui, est-ce que vous utilisez davantage Logic ou Pro Tools ?

Les deux ! Quasiment tout ce que je mixe me parvient sous la forme de projets Pro Tools, contre, je dirais, peut-être 8% sous Logic. Depuis que le format Audio Unit existe, j’ai mes synthés et mes plug-ins prêts à utiliser sur les deux plateformes. Le plus souvent, les mêmes plug-ins sont disponibles dans les deux formats, donc ça revient vraiment au même. Et puis, depuis que le code audio de Pro Tools a été réécrit, tout sonne tellement bien… Tous deux fonctionnent en virgule flottante, et je crois que leurs traitements internes se font en 32 bits.

Et est-ce que vous préférez l’un à l’autre ?

Non, je n’ai pas de préférence entre les deux. Même si j’utilise en général Logic pour le MIDI et de nombreuses productions, la plupart du boulot que je fais pour des clients est sous Pro Tools. J’utilise Logic depuis sa création sur Atari. Au départ, il s’appelait Creator, puis Notator et la première fois que je l’ai utilisé c’était sur un Atari 1040 parce que je ne pouvais pas me payer un Mac. Ceci dit, c’était une plateforme incroyablement fiable. Rudimentaire, comme tout ce qui se faisait à l’époque, mais il y avait un port MIDI intégré. C’était plutôt impressionnant.

Parlons un peu mixage. Aujourd’hui vous travaillez sur MAO, c’est bien ça ? Ça doit beaucoup vous changer ?

Ouais, c’est le cas depuis que j’ai cessé de mixer en studio, ça doit faire sept ou huit ans maintenant, Ceci dit, je travaillais déjà essentiellement sur MAO avant ça. Je n’utilise pas d’insert analogique sur les pistes individuelles, seulement un bus stéréo analogique. Mon bus stéréo est sympa, avec un Vari-Mu de chez Pendulum, un API 2500, des égaliseurs Tube-Tech, des égaliseurs GML, un égaliseur Prism Maselec… Ouais, des trucs vraiment sympas.

Vous utilisez encore tout ça ?

Plus vraiment. Je l’utilise pour le mastering, parce que je n’arrive toujours pas à obtenir les mêmes résultats en restant exclusivement sur MAO. Ceci dit, j’entends dire que certains des grands noms du mastering commencent à le faire.

Vraiment ? C’est impressionnant !

Oui. Enfin, pour moi c’est une vraie hérésie, mais ça m’intéresserait d’explorer cette piste.

OK, je vois. Faites-vous beaucoup de mastering, ou est-ce juste une petite part de votre activité ?

Ça compte peut-être pour 15% de mon travail.

Et que pensez-vous de logiciels comme Ozone ou autres, avec lesquels il suffit quasiment de lancer un preset pour s’approcher du but ?

Je pense qu’Ozone est vraiment un bon logiciel, qui est très en avance sur plein d’aspects. Quant aux presets, ce ne sont que des presets, c’est bon pour les crétins, pour ce que j’en dis.

[Rires] Et avez-vous essayé le dernier Ozone, avec la fonction Master Assistant qui analyse votre musique et vous propose un « point de départ » ?

Je n’ai pas encore installé la dernière version.

OK.

Je finirai bien par le faire parce que ça m’intéresse d’entendre ce qu’ils ont fait. Ozone a été mon limiteur préféré pendant longtemps, et c’était bien de tout avoir dans une seule interface. Mais le problème avec leur limiteur, même si je trouve qu’il sonne superbement bien, c’est qu’il n’avait pas de réglages séparés pour les temps d’attaque et de relâchement. Il n’y avait qu’un seul réglage, et je n’étais jamais sûr lequel de ces deux paramètres il affectait le plus.

Je crois que c’est toujours le cas, mais ils changent l’algorithme de leur limiteur assez souvent.

Oui, je crois que c’est leur algorithme III qui a longtemps été mon favori. Il conserve la profondeur de manière incroyable. Mais ne pas disposer d’un réglage séparé du temps de relâchement est tout de même un gros problème, parce que, comme vous le savez probablement, le temps de relâchement et l’action du limiteur comptent pour 50% des problèmes de distorsion.

Attardons-nous un peu là-dessus, parce que je pense que nos lecteurs seraient intéressés d’en savoir un petit peu plus à ce sujet.

Eh bien, ce n’est que mon avis et ma propre expérience, mais le temps de relâchement est la cause de beaucoup de distorsion. Bien sûr, ça peut aussi arriver avec l’attaque. Si on entre avec un signal vraiment, vraiment très fort, une attaque trop rapide peut complètement castrer les transitoires. Là, le temps de relâchement est important parce que s’il est trop long, on perd toute l’énergie de la musique. S’il est trop court, c’est souvent là qu’on se retrouve avec une distorsion qui craque, parce que le relâchement du limiteur se fait de manière vraiment tout sauf musicale. Il faut souvent le synchroniser à la dynamique qui soutient la musique.

C’est vrai. D’ailleurs beaucoup de limiteurs ont un réglage automatique du relâchement, n’est-ce pas ?

Oui, c’est vrai. Et en théorie, il lit la forme d’onde et ajuste le relâchement en fonction.

Trouvez-vous que cette fonction marche plutôt bien ?

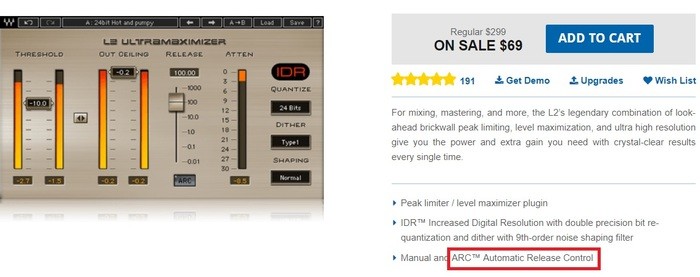

Je la désactive toujours pour ajuster le temps de relâchement par moi-même, du coup je n’en sais rien. C’est marrant, avec la plupart des compresseurs de chez Waves, par exemple beaucoup de leurs plus anciens modèles comme le C4, le C6 et le Renaissance Compressor, l’ARC est activé dans le réglage par défaut. Je crois que c’est le réglage automatique du temps de relâchement [ndlr: Auto Release Control], et personne ne sait ça. Je vois mes étudiants qui bougent le réglage du temps de relâchement alors que cette fonction est toujours activée, et je leur dis : "non, non, il faut d’abord décocher cette case, là !".

Si vous deviez donner des conseils à quelqu’un qui commence à monter un studio aujourd’hui, et qui n’a le budget que pour un seul excellent élément matériel, que lui diriez-vous de prendre en priorité ? Une super interface avec d’excellents convertisseurs ou alors un très bon micro ?

Il y a trois éléments qui sont vraiment importants. De façon générale, l’interface et les enceintes de monitoring sont cruciales. Et avec des enceintes, la notion de « neutralité » n’existe pas. Techniquement parlant, même l’oreille humaine n’est pas neutre. Ce que vous en attendez, c’est qu’elles vous révèlent tout ce qu’il y a dans le signal, ce que la plupart des enceintes de deux voies n’arrivent pas à faire : elles laissent souvent un trou dans les fréquences médianes, et le plus souvent, les graves ne descendent pas assez bas. Ensuite, vous voulez qu’elles reproduisent tous les éléments de manière à peu près équilibrée par rapport au spectre des fréquences. Des enceintes différentes offrent cela à des degrés différents et selon les goûts de chacun. On attend aussi qu’elles nous donnent une idée de la façon dont la musique va être retranscrite sur d’autres systèmes. Mais oui, une interface, c’est vraiment très important, aussi bien pour la fidélité du signal transmis aux enceintes que pour la qualité de la conversion.

Et les microphones ?

Tout le monde pense que les micros sont un élément super sexy, et c’est vrai. On vit actuellement une sorte de second âge d’or de l’audio pro, vu qu’ils font maintenant des émulations qui, sur beaucoup de plans, surpassent les originaux (au moins, ils ne tombent pas en panne). Mais concernant les micros, les gens se focalisent sur le fait de voir si c’est un micro à lampe, à large ou petit diaphragme et tout ça. Or, avec l’interface, la partie la plus importante du matériel d’enregistrement c’est le préampli des micros, pratiquement tous ceux qui ont fait ce boulot pendant un certain temps vous le diront. J’ai fait de super enregistrements avec un [Shure SM]57 et des préamplis micros API parce qu’ils fonctionnent vraiment très bien ensemble, il se trouve que c’est une combinaison qui sonne superbement bien. Prenez le meilleur des micros au monde, si vous l’associez à un préampli minable ça va clairement pourrir le résultat, alors qu’un très bon préampli associé à un micro de milieu de gamme sonnera bien mieux.

A présent, vous enseignez la technologie à l’Université de New York, c’est bien ça?

J’enseigne la production au Clive Davis Institute of Recorded Music, au sein de l’Université de New York. Nick Sansano, l’un des fondateurs du département, s’occupe du domaine de la production. Il est professeur associé et développe le cursus de production. J’y suis depuis sept ou huit ans, tout d’abord en tant que professeur auxiliaire et maintenant en tant que titulaire. La plupart de mes heures sont consacrées à des étudiants de deuxième année, c’est un cours de production réparti sur toute l’année. J’y aborde absolument tout, de la façon de régler les préamplis des micros jusqu’au niveau des musiciens en passant par les micros et l’aspect psychologique de la production. Je donne aussi un cours d’arrangement musical que j’ai moi-même élaboré, et qui est vraiment orienté vers l’arrangement pour le studio. Souvent, il y a un décalage entre ce qui marche en live et ce qui marche en studio.

Pourtant, on dit souvent que si l’arrangement d’une chanson est bon, elle va bien passer à l’enregistrement, ou que ça facilitera le travail au mixage, et bien rendre en live aussi. Du coup, pourquoi dites-vous cela ? Quels sont les caractéristiques d’un arrangement qui sont davantage cruciaux en studio qu’en live ?

En fait, c’est comme un diagramme de Venn. Les deux se recoupent environ à 50%. Il y a des choses avec lesquelles on peut faire illusion en live, mais qui en studio ne marcheront pas forcément aussi bien. En studio, l’essentiel, c’est le choix des instruments, par exemple prendre une basse de type Jazz ou alors une Precision, choisir une Strat ou préférer une guitare à micros doubles pour les arpèges et autres. Mais en live, on a une espèce de grosse bouillie sonore au sein de laquelle l’intelligibilité de chaque instrument est moindre, du coup la définition sonore n’est plus si importante au final. L’énergie, c’est ça qui compte ! En studio, à l’inverse, la définition sonore de chaque instrument prend une importance critique, et dans le monde moderne, le choix de votre instrument et ses caractéristiques sonores sont aussi déterminants que la précision de votre jeu. Pourtant, si on regarde en arrière, beaucoup des techniques que l’on utilise en studio ont pour origines historiques des limites technologiques ou économiques. On ne double pas les pistes des cuivres parce qu’un jour quelqu’un a dit « tiens, ça sonne mieux comme ça », on le fait parce qu’on n’avait pas les moyens de payer huit personnes, du coup on en payait quatre et on doublait les pistes. Il y a plein de choses comme ça sur lesquelles il est intéressant de réfléchir.

Évidemment, les problèmes de fréquences qui se chevauchent et qui nuisent à la clarté du son posent plus de problème en studio.

Oui, dans un mixage moderne ça devient beaucoup, beaucoup plus important. De toute façon, en live, on n’entend pas tout ça très bien, les signaux ne se distinguent pas clairement les uns des autres, du coup ça ne change pas grand chose. Mais imaginons que vous faites des arpèges sur un morceau où figurent d’autres instruments qui jouent des accords. N’importe qui connaissant ce type de situation va probablement choisir une Strat ou une Tele, parce que leurs caractéristiques sonores se prêtent mieux à ce genre de contexte.

Si vous avez une guitare rythmique et un clavier, je suppose que vous faites beaucoup d’égalisation pour les empêcher de se marcher sur les pieds ?

Oui. Si vous ne le faites pas, il faut que votre pré-production soit parfaite. Vous savez, quand je produis un groupe de scène, on fait en général quatre, cinq, six semaines de répétitions avant d’enregistrer, juste pour être sûrs qu’ils jouent les bonnes sections avec le bon timbre.

Je vois. Mais quand vous faites votre pré-production, est-ce que vous les enregistrez aussi pour entendre comment ça sonne, au moins avec un deux-pistes ou quelque chose de ce genre ?

À la fin de l’étape de pré-production, vous devriez être en mesure de mettre un téléphone, un [SM]57 ou n’importe quoi au milieu de la pièce, et arriver à tout entendre, malgré le fait que le son sera plutôt du genre « lo-fi ». Si vous y arrivez, ça veut dire que vous jouez comme il faut avec le bon timbre de façon à laisser assez d’espace aux autres instruments pour qu’on les entende.

Revenons un instant à vos activités d’enseignement. Remarquez-vous une différence concernant les connaissances techniques de vos étudiants par rapport à l’époque où vous avez débuté ? Est-ce que la génération qui a grandi entourée d’ordinateurs a beaucoup plus de connaissances en matière de production ?

Oui. De nos jours, les étudiants ont vraiment un excellent niveau. Lorsqu’ils arrivent, beaucoup d’entre eux sont autodidactes mais ils ont un niveau incroyable. Et actuellement, la musique pop « mainstream » se résume à de la musique électronique avec une ligne mélodique et des paroles. Du fait de la nature même de la production de musique électronique, on peut tout faire soi-même, sur son ordinateur portable, et on peut commencer dès l’âge de 10 ans. Ainsi, le niveau des étudiants en production va vraiment crescendo d’année en année. Il leur faut encore apprendre à utiliser un micro de manière efficace, ou à utiliser l’air et l’espace autour des instruments, mais ceux qui maîtrisent vraiment l’aspect technologique semblent le faire de mieux en mieux chaque année.

Merci !

Mais de rien.